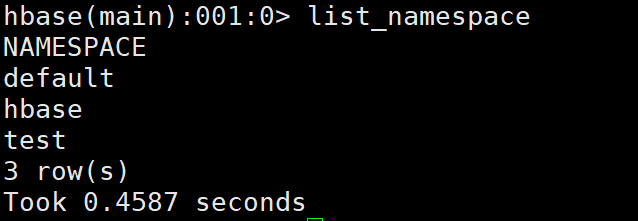

大数据平台搭建(容器环境)——HBase2.x分布式安装配置

HBase2.x分布式安装配置 确认是否完成Hadoop和Zookeeper的分布式(Hadoop伪分布式不可以)安装部署,没有的话请进行安装部署并启动。 一、解压 1. 将Master节点Hbase安装包解压到/opt/module目录下 tar -zxvf /opt/software/hbase-2.2.3-bin.tar.gz -C /opt/module/ 二、配置 ...

【大数据】可视化仪表板 - Superset的安装和使用

一、Superset简介Apache Superset是一个现代化的、企业级的数据探索和可视化平台,旨在帮助数据工程师和科学家在Web界面上创建和共享各种类型的数据洞察。1. 软件作用Apache Superset 的底层是一个 Flask 应用程序,其核心功能包括数据可视化、仪表板制作、数据切片和切块、以及 SQL Lab。在 Superset 的应用结构中,Flask 应用程序处理路由、视图....

【大数据】Sqoop的安装及使用

一、Sqoop简介Sqoop 是一款用于在 Hadoop 和关系型数据库之间传输数据的工具,提供了一种快速、简便的方法来将大量数据从关系型数据库导入到 Hadoop 分布式文件系统(HDFS),或者从 Hadoop 导出到关系型数据库。1. 软件作用Sqoop 的全称是 SQL-to-Hadoop,是一个开源项目,主要用于大数据处理领域。它可以在 Hadoop 和关系型数据库之间实现数据的双向传....

想问下,官网这个MMA迁移工具,“MaxCompute数据迁移”这个文档,是在客户端安装MMA工具?

想问下,官网这个MMA迁移工具,“MaxCompute数据迁移”这个文档,是在客户端安装MMA工具老操作的还是在阿里云控制台操作的?这一步没看明白。

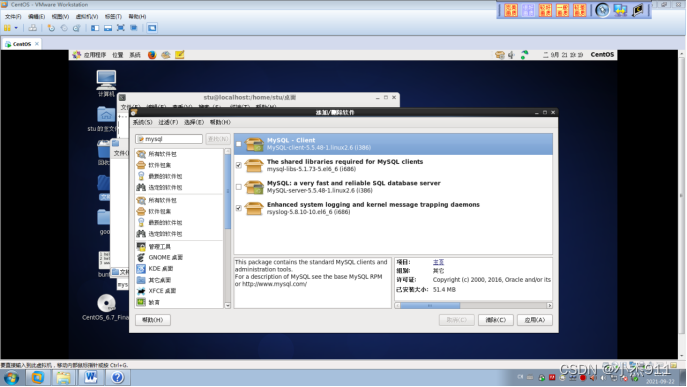

【大数据学习篇14】centos6安装Mysql(下)

3.4 检查进程,并关闭[root@localhost 桌面]# ps -aux|grep mysqlWarning: bad syntax, perhaps a bogus '-'? See /usr/share/doc/procps-3.2.8/FAQroot 2189 0.0 0.1 5124 139....

【大数据学习篇14】centos6安装Mysql(上)

1. centos6.5安装mysql5版本1.1 以su超级用户,安装Mysql数据库[st01@master ~]$ rpm -ivh MySQL-server-5.5.48-1.linux2.6.i386.rpm--force --nodeps1.2 启动Mysql数据库[root@master st01]# service mysql start1.3、安装Mysql客户端[root@m....

【大数据学习篇13】在linux上安装jupyter

1、安装Anaconda31.1 自己选择一个位置下载wget https://repo.continuum.io/archive/Anaconda3-5.0.1-Linux-x86_64.sh1.2 进入自己的安装目录,安装anacondabash Anaconda3-5.2.0-Linux-x86_64.sh一直按回去车然后按yes就好了。1.3 配置anaconda的路径vim /etc/....

【大数据学习篇5】 Spark安装实验

1. Spark安装与测试1.1 安装Scala语言#上传安装scala安装包 /home/hd/apps [hd@master apps]# pwd /home/hd/apps #解压 [hd@master apps]$ tar -zxvf scala-2.11.0.tgz #改名 [hd@master apps]$ mv scala-2.11.0 scala #切换root用户 [hd@m.....

【大数据学习篇4】Hive安装与操作(下)

2.1.5 在hdfs 中创建下面的目录 ,并且授权hadoop fs -mkdir -p /user/hive/warehousehadoop fs -mkdir -p /user/hive/tmphadoop fs -mkdir -p /user/hive/loghadoop fs -chmod -R 777 /user/hive/warehousehadoop fs -chmod -R 7....

【大数据学习篇4】Hive安装与操作(上)

1. 安装MariaDB在Centos7使用Yum安装MariaDB全部删除MySQL/MariaDBMySQL 已经不再包含在 CentOS 7 的源中,而改用了 MariaDB;1.1 使用rpm -qa | grep mariadb搜索 MariaDB 现有的包:如果存在,使用rpm -e --nodeps mariadb-*全部删除:[root@localhost ~]# rpm -qa....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云原生大数据计算服务 MaxCompute更多安装相关

- 大数据计算云原生大数据计算服务 MaxCompute安装

- 大数据计算云原生大数据计算服务 MaxCompute安装方包

- 云原生大数据计算服务 MaxCompute安装方包

- 数据计算云原生大数据计算服务 MaxCompute安装

- 云原生大数据计算服务 MaxCompute安装导入

- 云原生大数据计算服务 MaxCompute superset安装

- 云原生大数据计算服务 MaxCompute包安装

- 云原生大数据计算服务 MaxCompute安装mma

- 安装云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute集群环境安装

- 云原生大数据计算服务 MaxCompute hbase安装

- 云原生大数据计算服务 MaxCompute dockerfile安装

- 云原生大数据计算服务 MaxCompute sqoop安装

- 云原生大数据计算服务 MaxCompute安装步骤

- 云原生大数据计算服务 MaxCompute安装hbase

- 云原生大数据计算服务 MaxCompute伪分布安装

- 云原生大数据计算服务 MaxCompute flume安装

- 云原生大数据计算服务 MaxCompute安装zookeeper

- 安装云原生大数据计算服务 MaxCompute框架

- 云原生大数据计算服务 MaxCompute安装编程

- 云原生大数据计算服务 MaxCompute组件安装

- 云原生大数据计算服务 MaxCompute安装kafka

- 云原生大数据计算服务 MaxCompute数据采集安装

- 云原生大数据计算服务 MaxCompute伪分布式安装

- 阿里云ecs安装云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute安装flume

- 云原生大数据计算服务 MaxCompute vmware安装

- 云原生大数据计算服务 MaxCompute kafka安装

- ubuntu安装云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute安装脚本

云原生大数据计算服务 MaxCompute您可能感兴趣

- 云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute oss

- 云原生大数据计算服务 MaxCompute分布式

- 云原生大数据计算服务 MaxCompute数据处理

- 云原生大数据计算服务 MaxCompute odps

- 云原生大数据计算服务 MaxCompute实践

- 云原生大数据计算服务 MaxCompute天作之合

- 云原生大数据计算服务 MaxCompute区块链

- 云原生大数据计算服务 MaxCompute心跳

- 云原生大数据计算服务 MaxCompute崛起

- 云原生大数据计算服务 MaxCompute MaxCompute

- 云原生大数据计算服务 MaxCompute大数据计算

- 云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute dataworks

- 云原生大数据计算服务 MaxCompute sql

- 云原生大数据计算服务 MaxCompute分析

- 云原生大数据计算服务 MaxCompute报错

- 云原生大数据计算服务 MaxCompute应用

- 云原生大数据计算服务 MaxCompute表

- 云原生大数据计算服务 MaxCompute阿里云

- 云原生大数据计算服务 MaxCompute spark

- 云原生大数据计算服务 MaxCompute产品

- 云原生大数据计算服务 MaxCompute任务

- 云原生大数据计算服务 MaxCompute计算

- 云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute开发

- 云原生大数据计算服务 MaxCompute大数据

- 云原生大数据计算服务 MaxCompute查询

- 云原生大数据计算服务 MaxCompute hadoop

- 云原生大数据计算服务 MaxCompute平台

大数据计算 MaxCompute

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。

+关注