大数据Zookeeper-02.伪分布式安装

安装前准备 操作系统准备 本次安装采用的操作系统是Ubuntu 20.04。 更新软件包列表。 sudo apt-get update 安装Java 8+ 使用命令安装Java 8。 sudo apt-get install -y openjdk-8-jdk 配置环境变量。 vi .bashrc export JAVA_HOME=/usr/lib/jvm/java-8-open...

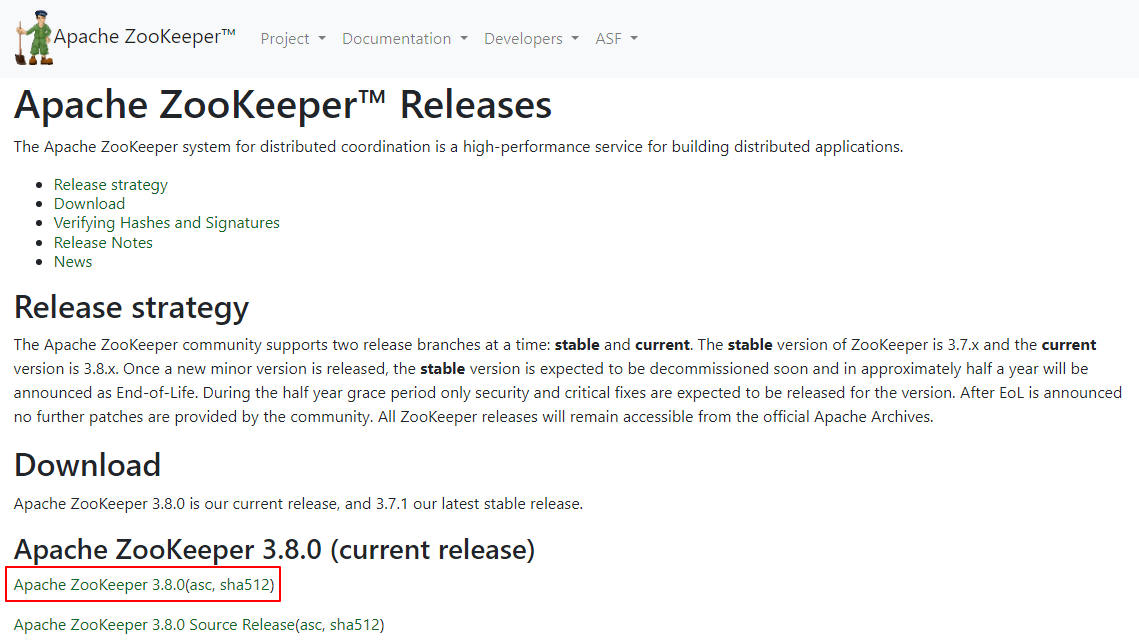

大数据Zookeeper-01.单机环境安装

安装前准备 操作系统准备 本次安装采用的操作系统是Ubuntu 20.04。 更新软件包列表。 sudo apt-get update 安装Java 8+ 使用命令安装Java 8。 sudo apt-get install -y openjdk-8-jdk 配置环境变量。 vi .bashrc export JAVA_HOME=/usr/lib/jvm/java-8-open...

大数据物流项目中CM的安装与运用

大数据服务器之CM安装架构及目录 针对整个物流项目来说,1台虚拟机安装部署大数据环境:基于CM6.2.1安装CDH6.2.1。关于CM功能及CM安装,不再过多赘述,项目还是要注重于业务及数据和实现。提供虚拟机【node2.itcast.cn】解压后,导入VMWare 软件中,启动虚拟机即可(选择我已移动该虚拟机)1)、启动之前,设置node2.itcast.cn内存:4GB或者6GB或者8GB即....

大数据入门系列 1:全网最全,Windows 安装 VMware Workstation 虚拟机完整步骤及需要注意的问题

文章目录前言一、下载正版虚拟机不同版本1.1、通过官网进行下载 VM 虚拟机1.1.1、选择所需版本下载1.1.2、VM 15.1.0 Pro for Windows 下载1.2、免注册账号又安全地下载虚拟机1.2.1、浏览器搜索下载需要的版本1.2.2、校验下载包的安全性二、虚拟机安装步骤2.1、进入安装向导2.2、接受许可协议2.3、自定义安装并选择安装路径2.4、产品更新、用户体验计划自行....

大数据基础系列 4:伪分布式 Hadoop 在 Ubuntu 上的安装流程完整步骤及易错点分析

文章目录前言一、创建 Ubuntu 用户二、安装 Java2.1、查看本地 Java 版本2.2、验证 Java 在本地的配置情况三、安装 ssh 服务3.1、安装 openssh-server3.2、查看 ssh 服务是否启动四、Hadoop 伪分布式安装4.1、Hadoop 下载4.2、进入下载安装包的目录4.3、Hadoop 解压4.3.1、解压命令 tar zxvf 中 zxvf 分别是....

大数据入门系列 3:全网最全,Ubuntu 安装 VMware Tools 完整步骤及需要注意的问题

文章目录前言一、启动 Mware 虚拟机二、打开 terminal 命令界面三、检查软件包更新四、安装 VMware Tools五、检查 VMware Tools 是否安装成功总结前言尽管客户机操作系统在未安装 VMware Tools 的情况下仍可运行,但许多 VMware 功能只有在安装 VMware Tools 后才可用。安装 VMware Tools 后,工具套件中的实用程序可增强虚拟机....

大数据入门系列 2:全网最全,VMware 虚拟机上安装 Ubuntu 完整步骤及需要注意的问题

搜索文章目录前言一、自备 VMware 虚拟机二、下载 Ubuntu 镜像文件2.1、下载安装 ubuntu 系统时 LTS 版本和正式版本的区别?2.2、Ubuntu 版本更新规则三、VMware 虚拟机上配置 Ubuntu 安装环境3.1、在 VMware 新建一个虚拟机3.2、配置类型选择自定义3.3、虚拟机硬件兼容性选择默认3.4、安装客户机操作系统3.5、选择客户机操作系统3.6、选择....

大数据基础-安装Hadoop

1:上传hadoop安装包网络异常,图片无法展示|2:解压hadoop安装包我们看一下bin目录,这里面有hdfs,yarn等脚本,这些脚本后期主要是为了操作hadoop集群中的hdfs和yarn组件的再来看一下sbin目录,这里面有很多start stop开头的脚本,这些脚本是负责启动 或者停止集群中的组件的。其实还有一个重要的目录是etc/hadoop目录,这个目录里面的文件主要是hadoo....

大数据基础-Linux虚拟机安装

注意:在安装虚拟机之前需要先确认虚拟化功能是否已经打开,不同电脑的开启方式不一样,这个需要大家根据自己对应品牌的笔记本到网上搜一下:如何开启虚拟化通过下面这些步骤确认是否开启了虚拟化功能。在任务栏上点击右键--任务管理器--性能--CPU,如下图网络异常,图片无法展示|确保以及开启虚拟化、如果没有请自行百度各类电脑开启虚拟化教程,这里不赘述新建虚拟机选择新建网络异常,图片无法展示|选择自定义高级....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云原生大数据计算服务 MaxCompute更多安装相关

- 大数据计算云原生大数据计算服务 MaxCompute安装

- 大数据计算云原生大数据计算服务 MaxCompute安装方包

- 云原生大数据计算服务 MaxCompute安装方包

- 数据计算云原生大数据计算服务 MaxCompute安装

- 云原生大数据计算服务 MaxCompute安装导入

- 云原生大数据计算服务 MaxCompute superset安装

- 云原生大数据计算服务 MaxCompute包安装

- 云原生大数据计算服务 MaxCompute安装mma

- 安装云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute集群环境安装

- 云原生大数据计算服务 MaxCompute hbase安装

- 云原生大数据计算服务 MaxCompute dockerfile安装

- 云原生大数据计算服务 MaxCompute sqoop安装

- 云原生大数据计算服务 MaxCompute安装步骤

- 云原生大数据计算服务 MaxCompute安装hbase

- 云原生大数据计算服务 MaxCompute伪分布安装

- 云原生大数据计算服务 MaxCompute flume安装

- 云原生大数据计算服务 MaxCompute安装zookeeper

- 安装云原生大数据计算服务 MaxCompute框架

- 云原生大数据计算服务 MaxCompute安装编程

- 云原生大数据计算服务 MaxCompute组件安装

- 云原生大数据计算服务 MaxCompute安装kafka

- 云原生大数据计算服务 MaxCompute数据采集安装

- 云原生大数据计算服务 MaxCompute伪分布式安装

- 阿里云ecs安装云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute安装flume

- 云原生大数据计算服务 MaxCompute vmware安装

- 云原生大数据计算服务 MaxCompute kafka安装

- ubuntu安装云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute安装脚本

云原生大数据计算服务 MaxCompute您可能感兴趣

- 云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute oss

- 云原生大数据计算服务 MaxCompute分布式

- 云原生大数据计算服务 MaxCompute数据处理

- 云原生大数据计算服务 MaxCompute odps

- 云原生大数据计算服务 MaxCompute实践

- 云原生大数据计算服务 MaxCompute天作之合

- 云原生大数据计算服务 MaxCompute区块链

- 云原生大数据计算服务 MaxCompute心跳

- 云原生大数据计算服务 MaxCompute崛起

- 云原生大数据计算服务 MaxCompute MaxCompute

- 云原生大数据计算服务 MaxCompute大数据计算

- 云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute dataworks

- 云原生大数据计算服务 MaxCompute sql

- 云原生大数据计算服务 MaxCompute分析

- 云原生大数据计算服务 MaxCompute报错

- 云原生大数据计算服务 MaxCompute应用

- 云原生大数据计算服务 MaxCompute表

- 云原生大数据计算服务 MaxCompute阿里云

- 云原生大数据计算服务 MaxCompute spark

- 云原生大数据计算服务 MaxCompute产品

- 云原生大数据计算服务 MaxCompute任务

- 云原生大数据计算服务 MaxCompute计算

- 云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute开发

- 云原生大数据计算服务 MaxCompute大数据

- 云原生大数据计算服务 MaxCompute查询

- 云原生大数据计算服务 MaxCompute hadoop

- 云原生大数据计算服务 MaxCompute平台

大数据计算 MaxCompute

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。

+关注