实时计算 Flink版产品使用合集之如何重写序列化器

问题一:Flink CDC的ddl里字段类型是啥? Flink CDC的ddl里字段类型是啥? 参考答案: test_datetime2 datetime(3) 关于本问题的更多回答可点击进行查看: https://developer.aliyun.com/ask/584510 问题二:F...

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(七)

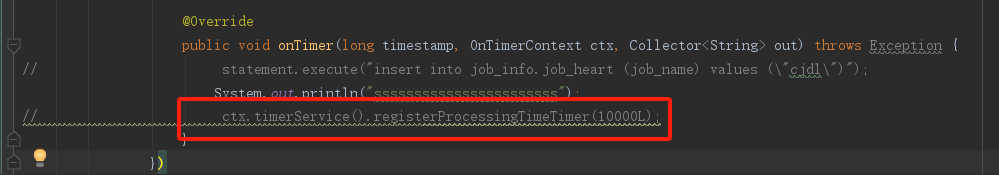

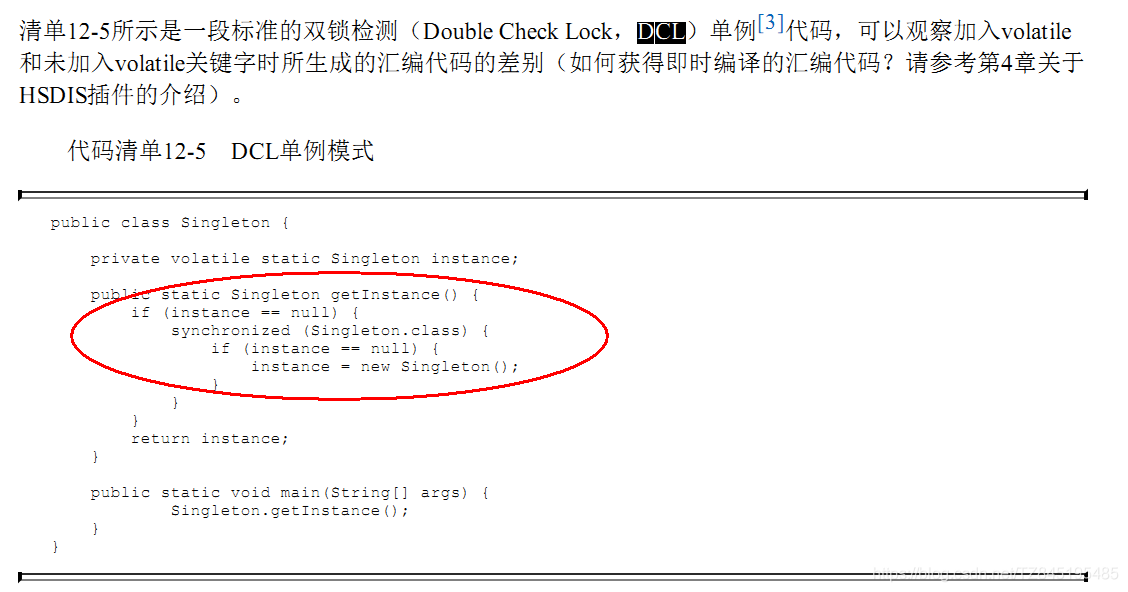

⑤. 查询代码展示(这里补充一个在工作中实际遇到过的案例:公司某个卡卷活动,送保养给客户,设置的是一个月,最后当那个key消失的时候,我的邮箱就收到了3条报警邮件,我们分析了一下代码,出现了缓存击穿的现象,最后我们使用周志明老师的双端检索机制,使用重量级进行加锁,进行二次if判断,重新查询数据库,将热点代码进行重新设置进去) /** * 业务逻辑并没有写错,对于小厂中厂(QPS《=...

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(六)

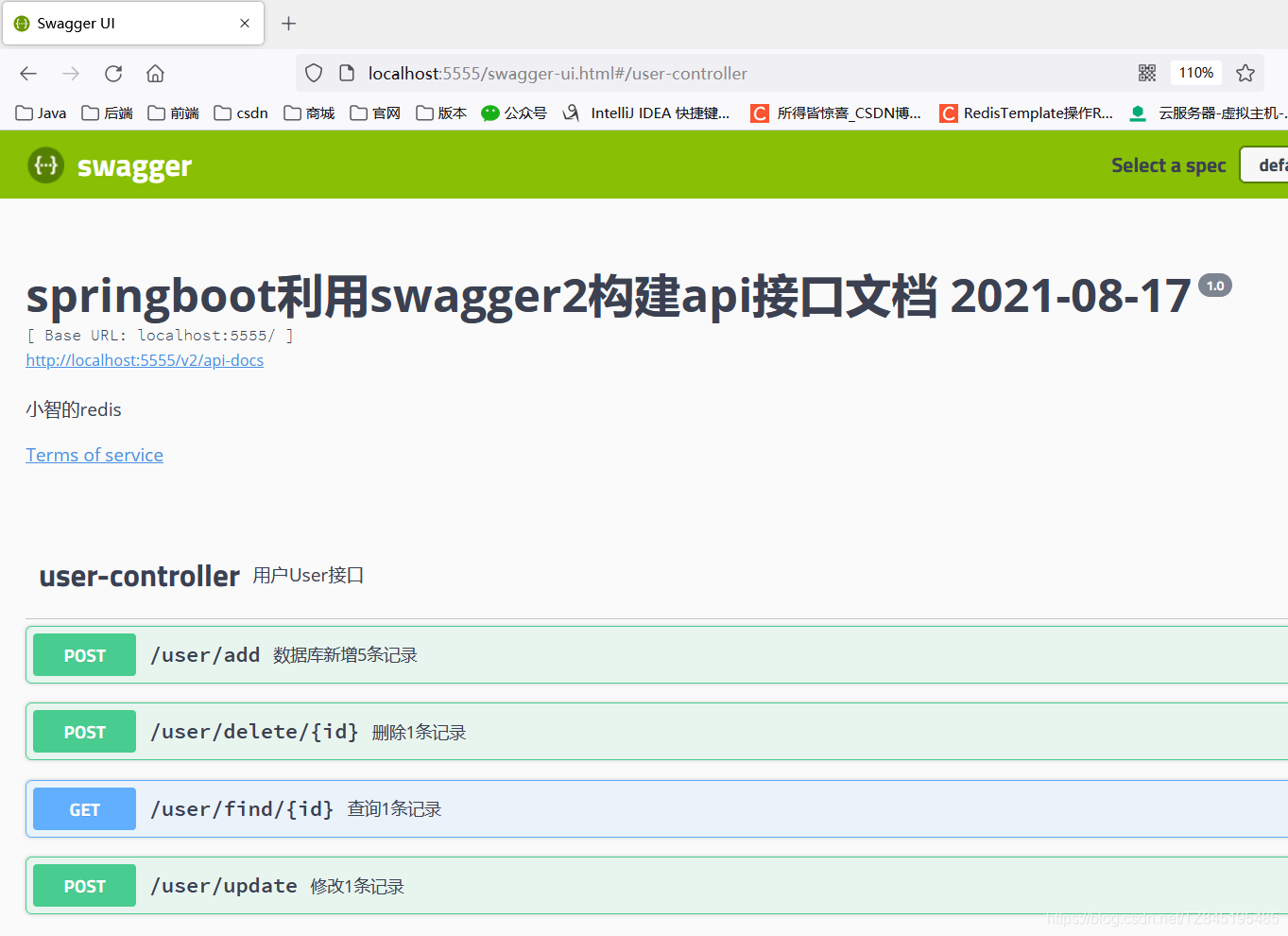

③. 配置类RedisConfig、SwaggerConfig@Configuration public class RedisConfig { /** * @param lettuceConnectionFactory * @return * * redis序列化的工具配置类,下面这个请一定开启配置 * 127.0.0.1:6379&g...

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(五)

@NoArgsConstructor @AllArgsConstructor @Data @ApiModel(value = "用户信息") //数据传输对象 public class UserDTO implements Serializable { @ApiModelProperty(value = "用户ID") private Integer id; @ApiMo...

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(四)

@Table(name = "t_user") public class User { @Id @GeneratedValue(generator = "JDBC") private Integer id; /** * 用户名 */ private String username; /** * 密码 */ ...

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(三)

②. 业务类、controller、service、entity、mapper@Api(description = "用户User接口") @RestController @Slf4j public class UserController { @Resource private UserService userService; @ApiOperation("数据库新增5...

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(二)

server.port=5555 spring.application.name=redis0511 # ========================logging 日志相关的配置===================== #系统默认,全局root配置的日志形式,可以注释掉 logging.level.root=warn #开发人员自己设置的包结构,对那个package进行什么级别的日志监控....

REDIS02_基于SpringBoot+Mybatis+Redis重写Redis的序列化的缓存实战(一)

①. 建立redis_20210511、设置pom文件、写YML、主启动类<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" ...

Oscache集群环境下报错重写并序列化了

严重: Manager [localhost#/status1]: Unable to receive message through TCP channel java.lang.NullPointerException at com.opensymphony.oscache.base.algorith...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。