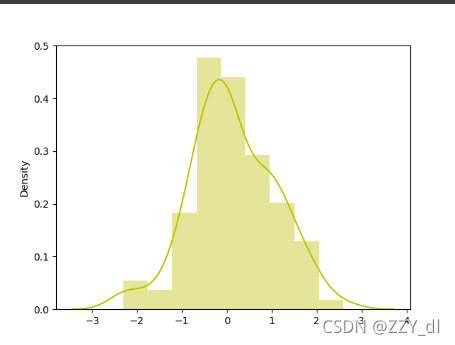

Seaborn可视化学习笔记(一):可视化神经网络权重分布情况

函数信息 #displot参数如下 sns.distplot(a, bins=None, hist=True, kde=True, rug=False, fit=None, hist_kws=None, kde_kws=None, rug_kws=None, fit_kws=None, color=None, vertical=False, norm_hist=False, axlabel=No....

神经网络中权重初始化的重要性

在神经网络的构建和训练过程中,权重初始化是一个至关重要的环节。它对神经网络的性能、收敛速度以及避免过拟合等方面都有着深远的影响。下面将详细介绍神经网络中权重初始化的重要性。 一、权重初始化的作用 决定网络的起始状态权重初始化为神经网络提供了一个起始点。不同的初始化方法会使网络在训练开始时处于不同的状态,这将直接影响到后续的训练过程和最终的性能表现。 影响收敛速度合适的...

**反向传播算法**在多层神经网络训练中至关重要,它包括**前向传播**、**计算损失**、**反向传播误差**和**权重更新**。

反向传播算法(Backpropagation Algorithm)是训练人工神经网络中最为广泛使用的算法之一,特别是在多层前馈神经网络中。以下是反向传播算法的基本工作原理: 前向传播(Feedforward)阶段: 输入数据首先通过网络的输入层进入,经过一系列的隐藏层(如...

初始化神经网络权重的方法总结

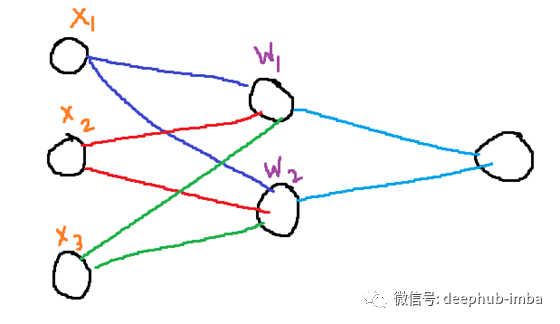

在本文中,评估了权值初始化的许多方法和当前的最佳实践零初始化将权值初始化为零是不行的。那我为什么在这里提到它呢?要理解权值初始化的需要,我们需要理解为什么将权值初始化为零是无效的。让我们考虑一个类似于上面所示的简单网络。每个输入只是一个标量X₁,X₂X₃。和每个神经元的权重是W₁和W₂。每次权重更新如下:Out₁ = X₁*W₁ + X₂*W₁ + X₃*W₁Out₂ = X₁*W₂ + X₂*....

卷积神经网络中的参数共享/权重复制

参数共享或权重复制是深度学习中经常被忽略的领域。但是了解这个简单的概念有助于更广泛地理解卷积神经网络的内部。卷积神经网络(cnn)能够使那些通过网络馈送的图像在进行仿射变换时具有不变性。这个特点提供了识别偏移图案、识别倾斜或轻微扭曲的图像的能力。仿射不变性的这些特征是由于CNN架构的三个主要属性而引入的。局部感受领域权值共享(参数共享)空间子采样在本文中,我们将探索权值共享,并了解它们的用途以及....

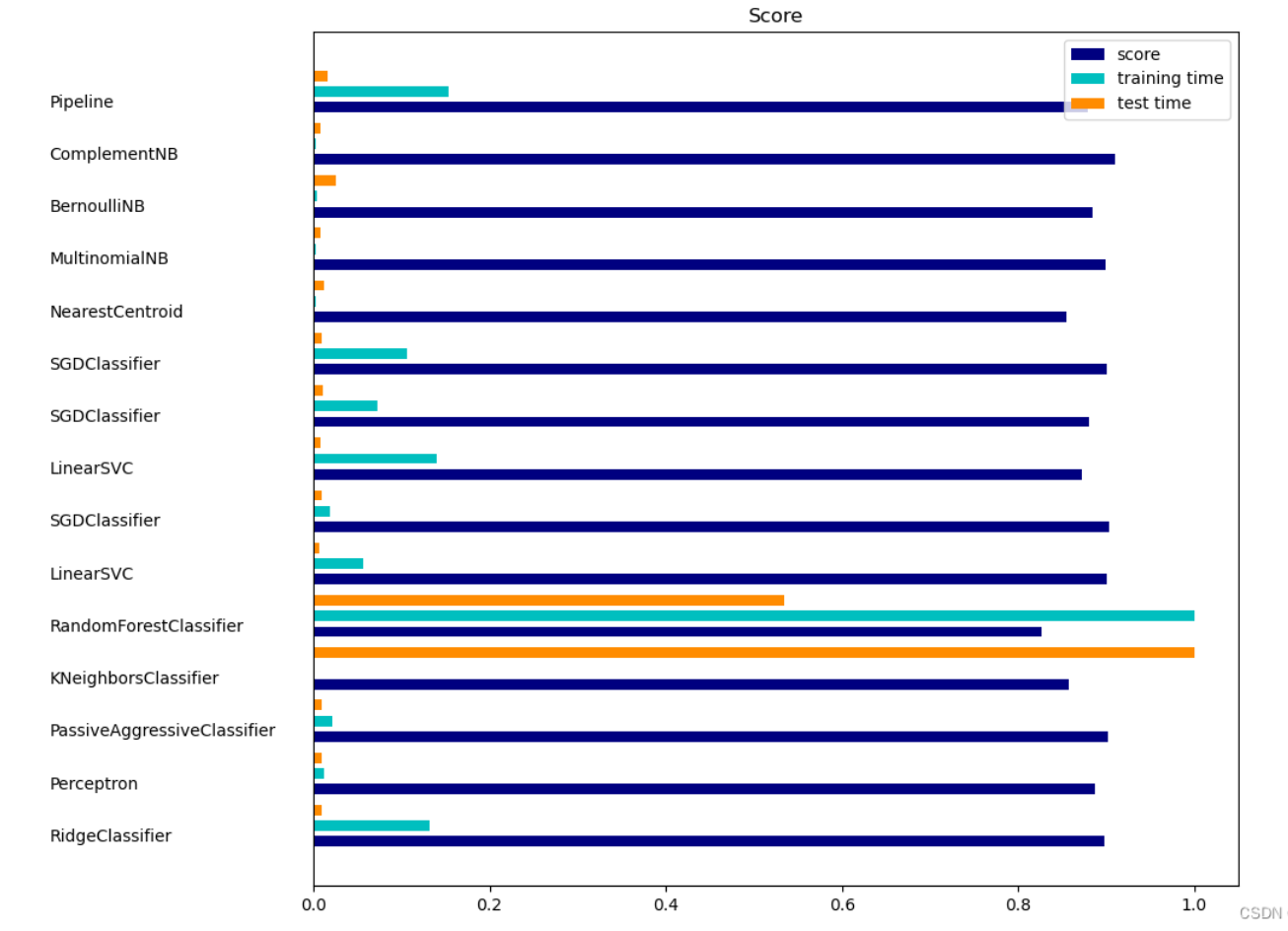

【34】文本文档分类实战(哈希编码/权重编码提取特征 + 卡方过滤 + 搭建神经网络分类)

这里我使用的是sklearn自带的一个数据集,属于一个新闻分类数据,有20类,18846个样本,其中11314个训练样本。其类别信息分别为:['alt.atheism', 'comp.graphics', 'comp.os.ms-windows.misc', 'comp.sys.ibm.pc.hardware', 'comp.sys.mac.hardware', 'comp.windo...

Pytorch中自定义神经网络卷积核权重

Pytorch中自定义神经网络卷积核权重自定义神经网络卷积核权重神经网络被深度学习者深深喜爱,究其原因之一是神经网络的便利性,使用者只需要根据自己的需求像搭积木一样搭建神经网络框架即可,搭建过程中我们只需要考虑卷积核的尺寸,输入输出通道数,卷积方式等等。我们使用惯了自带的参数后,当我们要自定义卷积核参数时,突然有种无从下手的感觉,哈哈哈哈哈哈哈哈~~,请允许我开心下,嘿嘿!因为笔者在初入神经网络....

请教一下各位大佬,为什么几乎所有的教程里面pytorch搭建神经网络都没有看到显式的权重初始化步骤?

请问pytorch是有默认随机初始化吗? 本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。 https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

告别深度学习炼丹术!谷歌大脑提出“权重无关”神经网络

来源:新智元 作者:新智元 文章来源:微信公众号 数据派THU 本文约5600字,建议阅读10+分钟。 无需权重训练!谷歌再向深度学习炼丹术发起“攻击”。 [ 导读 ]神经网络训练中“权重”有多重要不言而喻。但现在,可以把权重抛诸脑后了。谷歌大脑最新研究提出“权重无关神经网络”,通过不再强调权重来搜索网络结构,所搜索的网络无需权重训练即可执行任务! 还在为 “调参炼丹” 感到痛苦吗?是时候重...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。