如果你的PyTorch优化器效果欠佳,试试这4种深度学习中的高级优化技术吧

在深度学习领域,优化器的选择对模型性能至关重要。虽然PyTorch中的标准优化器如 SGD 、 Adam 和 AdamW 被广泛应用,但它们并非在所有情况下都是最优选择。本文将介绍四种高级优化技术,这些技术在某些任务中可能优于传统方法,特别是在面对复杂优化问题时。 我们将探讨以下算法: 序列最小二乘规划(SLSQP) 粒子群优化(PSO) 协方差矩阵自适应进化策略(CMA-ES) ...

PyTorch模型训练:优化器与损失函数的选择

在深度学习的模型训练过程中,优化器和损失函数的选择对模型的性能至关重要。PyTorch作为一个广泛使用的深度学习框架,提供了多种优化器和损失函数,帮助开发者更有效地训练模型。本文将介绍如何在PyTorch中选择合适的优化器和损失函数。 一、优化器的选择 优化器是深度学习模型训练中的关键组件,它负责根据模型的损失来调整模型的权重。PyTorc...

PyTorch基础之优化器模块、训练和测试模块讲解(附源码)

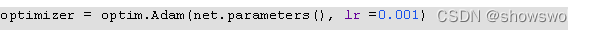

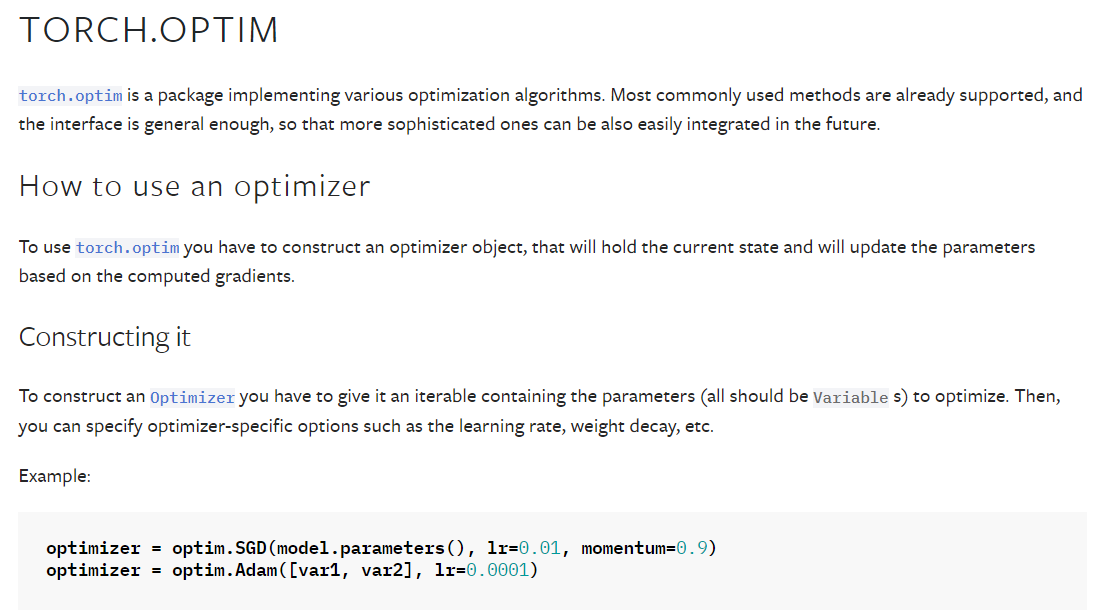

一、优化器模块torch.optim是一个具备各种优化算法的库,可以支持大部分常用的优化方法,并且这个接口具备足够的通用性,这使得它能够集成更加复杂的优化算法1:optimizer的使用构建一个optimizer对象参数设置(需要优化的参数、设置学习率等)另外,还可以单独设置每个参数值表示model.base的参数都将使用0.001的学习率,model.regression的参数将使用0.000....

Pytorch学习笔记(7):优化器、学习率及调整策略、动量

前期回顾: Pytorch学习笔记(1):基本概念、安装、张量操作、逻辑回归Pytorch学习笔记(2):数据读取机制(DataLoader与Dataset)Pytorch学习笔记(3):图像的预处理(transforms)Pytorch学习笔记(4):模型创建(Module)、模型容器(Containers)、AlexNet构建Pytorch学习笔记(5):torch.nn---网络层介绍(卷....

【PyTorch】Optim 优化器

五、Optim 优化器参考文档:https://pytorch.org/docs/stable/optim.html1、SGD参考文档:https://pytorch.org/docs/stable/generated/torch.optim.SGD.html#torch.optim.SGDimport torch.optim import torchvision from torch impo....

[深度学习实战]基于PyTorch的深度学习实战(上)[变量、求导、损失函数、优化器](一)

一、前言 用了Matlab搭建神经网络才愈发感觉"人生苦短,我用PyTorch“是多么正确。毕竟新的神经网络架构还是得自己一点点敲,现在是一点都笑不出来了,指望Matlab提供的老框架和训练算法也做不出什么算法方法的突破,顶多就是在实现功能上方便点罢了。 本博文要求读者有一定的Python编程基础!,对机器学习和神经网络有一定的了解!。如果是零基础学习人群,请参看我之前的....

![[深度学习实战]基于PyTorch的深度学习实战(上)[变量、求导、损失函数、优化器](一)](https://ucc.alicdn.com/pic/developer-ecology/u4n2puyxrj26a_c06960d9be3a46828d7fd91af0d80a2f.png)

[深度学习实战]基于PyTorch的深度学习实战(上)[变量、求导、损失函数、优化器](二)

五、损失函数 损失函数,又叫目标函数,是编译一个神经网络模型必须的两个参数之一。另一个必不可少的参数是优化器。 损失函数是指用于计算标签值和预测值之间差异的函数,在机器学习过程中,有多种损失函数可供选择,典型的有距离向量,绝对值向量等。 上图是一个用来模拟线性方程自动学习的示意图。粗线是真实的线性方程,虚线是迭代过程的示意,w1 是第一次迭代的权重,w2 是第二次迭代的权重,w3 是第三次迭....

![[深度学习实战]基于PyTorch的深度学习实战(上)[变量、求导、损失函数、优化器](二)](https://ucc.alicdn.com/pic/developer-ecology/u4n2puyxrj26a_39e6172217094f9584f942fdc87dd93c.png)

Pytorch基本使用——优化器

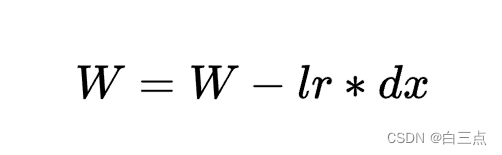

目录1 SGD1.1 原理1.2 构造1.3 参数详解——momentum2 Adam及AdamW2.1 更新规则2.2 理解一阶估计变量m和二阶估计变量v及探讨Adam如何利用的它们2.3 AdamW✨1 SGD损失函数是用来度量模型输出和真实值的偏差,损失函数越小,说明我们的模型效果越好,所以我们需要不停的最小化这个函数。如果损失函数是一个凸函数,求得最小值还是比较简单的,直接求导就可以。但....

【Pytorch神经网络理论篇】 10 优化器模块+退化学习率

同学你好!本文章于2021年末编写,获得广泛的好评!故在2022年末对本系列进行填充与更新,欢迎大家订阅最新的专栏,获取基于Pytorch1.10版本的理论代码(2023版)实现,Pytorch深度学习·理论篇(2023版)目录地址为:CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(2023版)目录本专栏将通过系统的深度学习实例,从可解释性的角度对深度学习的原理进行讲解与分析,通....

Pytorch教程[08]优化器

一.什么是优化器pytorch的优化器:管理并更新模型中可学习参数的值,使得模型输出更接近真实标签导数:函数在指定坐标轴上的变化率方向导数:指定方向上的变化率梯度:一个向量,方向为方向导数取得最大值的方向二.optimizer的属性基本属性• defaults:优化器超参数• state:参数的缓存,如mom en tum的缓存• params_groups:管理的参数组• _step_coun....

![Pytorch教程[08]优化器](https://ucc.alicdn.com/pic/developer-ecology/c38d40d014e34b83b0395d3298d8cbed.png)

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

pytorch您可能感兴趣

- pytorch keras

- pytorch tensorflow

- pytorch代码

- pytorch示例

- pytorch gpu

- pytorch profiler

- pytorch系统

- pytorch神经网络

- pytorch resnet50

- pytorch图像

- pytorch模型

- pytorch教程

- pytorch实战

- pytorch训练

- pytorch学习

- pytorch数据集

- pytorch官方教程

- pytorch安装

- pytorch卷积

- pytorch构建

- pytorch卷积神经网络

- pytorch数据

- pytorch源码

- pytorch分类

- pytorch框架

- pytorch案例

- pytorch学习笔记

- pytorch版本

- pytorch张量

- pytorch python