【文本摘要(3)】Pytorch之Seq2seq: attention

写在最前面代码参考:https://github.com/jasoncao11/nlp-notebook/tree/master/4-2.Seq2seq_Att跪谢大佬,文本摘要的全部代码几乎都有了只有小部分需要修改,可能是版本原因本代码已跑通,若有问题欢迎留言,一起交流探讨如有理解不对的地方,还请过路的大佬们指点一二参考:https://www.bilibili.com/video/BV1op....

【文本摘要(2)】pytorch之Seq2Seq(下)

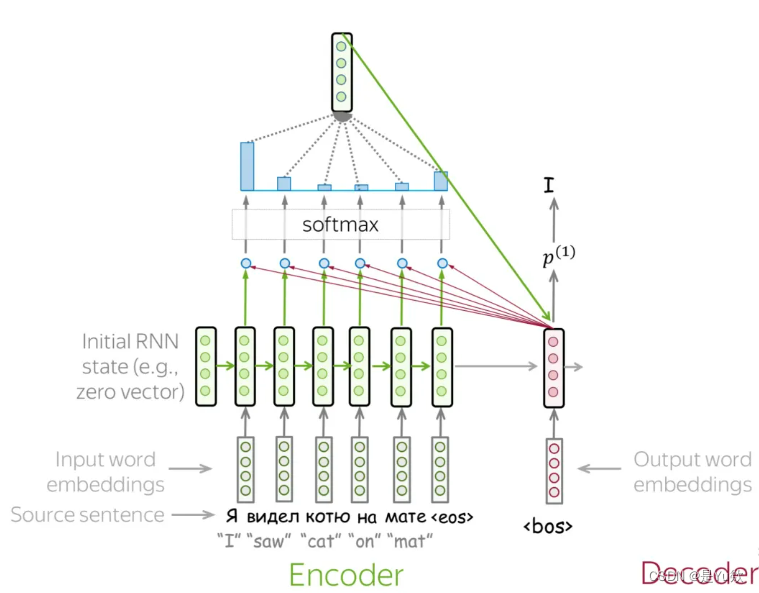

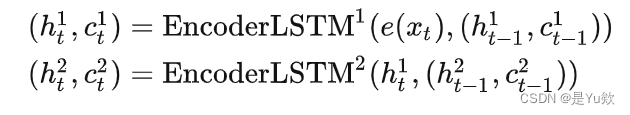

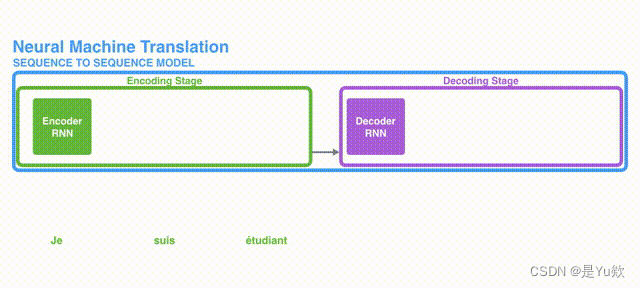

生成模型的输出序列这段代码是一个基本的序列到序列模型中的解码部分,用于生成模型的输出序列。具体而言,这个代码通过模型的encoder对输入序列进行编码,然后使用模型的decoder对编码后的信息进行解码,从而生成模型的输出序列。下面是这段代码的具体解释:res = []:创建一个空列表,用于存储模型生成的输出序列(字符串)。encoder_outputs, hidden = model.enco....

【文本摘要(2)】pytorch之Seq2Seq(上)

写在最前面改废了两个代码后,又找到了一个文本摘要代码终于跑起来了改废的两个代码:一个是机器翻译改文本摘要,结果没跑起来。。。一个是英文文本摘要改中文文本摘要,预测的摘要全是,,,这种代码参考:https://github.com/jasoncao11/nlp-notebook/tree/master/4-2.Seq2seq_Att跪谢大佬,文本摘要的全部代码几乎都有了只有小部分需要修改,可能是版....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

pytorch您可能感兴趣

- pytorch性能

- pytorch模型

- pytorch数据集

- pytorch压缩

- pytorch实践

- pytorch感知

- pytorch部署

- pytorch训练

- pytorch量化

- pytorch技术

- pytorch神经网络

- pytorch教程

- pytorch实战

- pytorch学习

- pytorch代码

- pytorch tensorflow

- pytorch官方教程

- pytorch安装

- pytorch卷积

- pytorch构建

- pytorch gpu

- pytorch卷积神经网络

- pytorch数据

- pytorch源码

- pytorch分类

- pytorch框架

- pytorch案例

- pytorch学习笔记

- pytorch版本

- pytorch张量