集成学习之随机森林、Adaboost、Gradient Boosting、XGBoost原理及使用

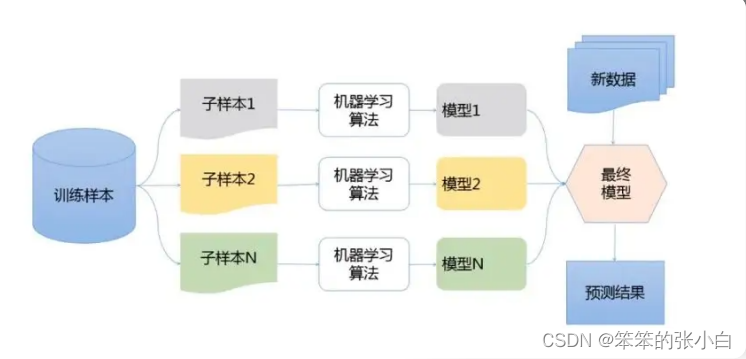

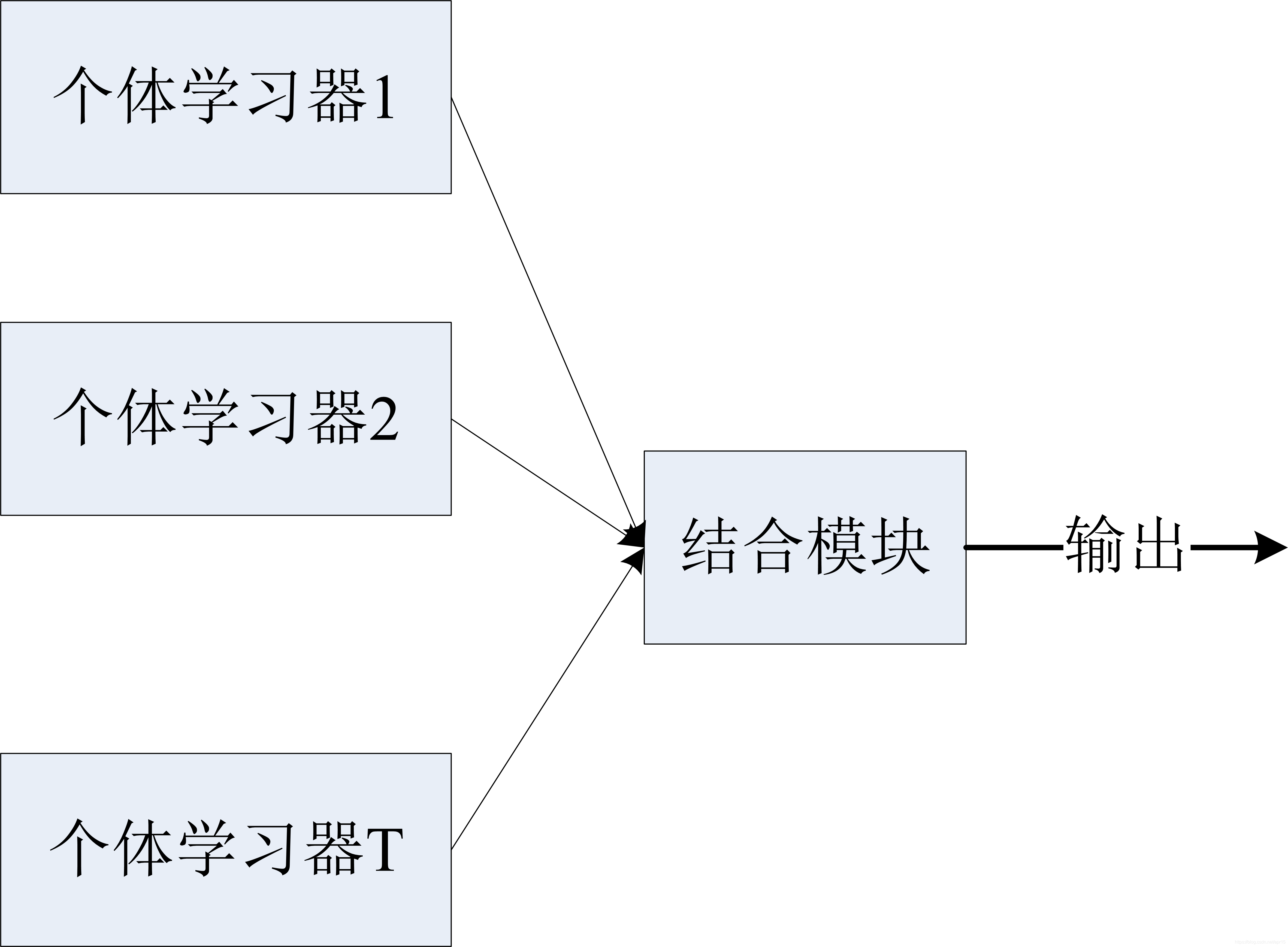

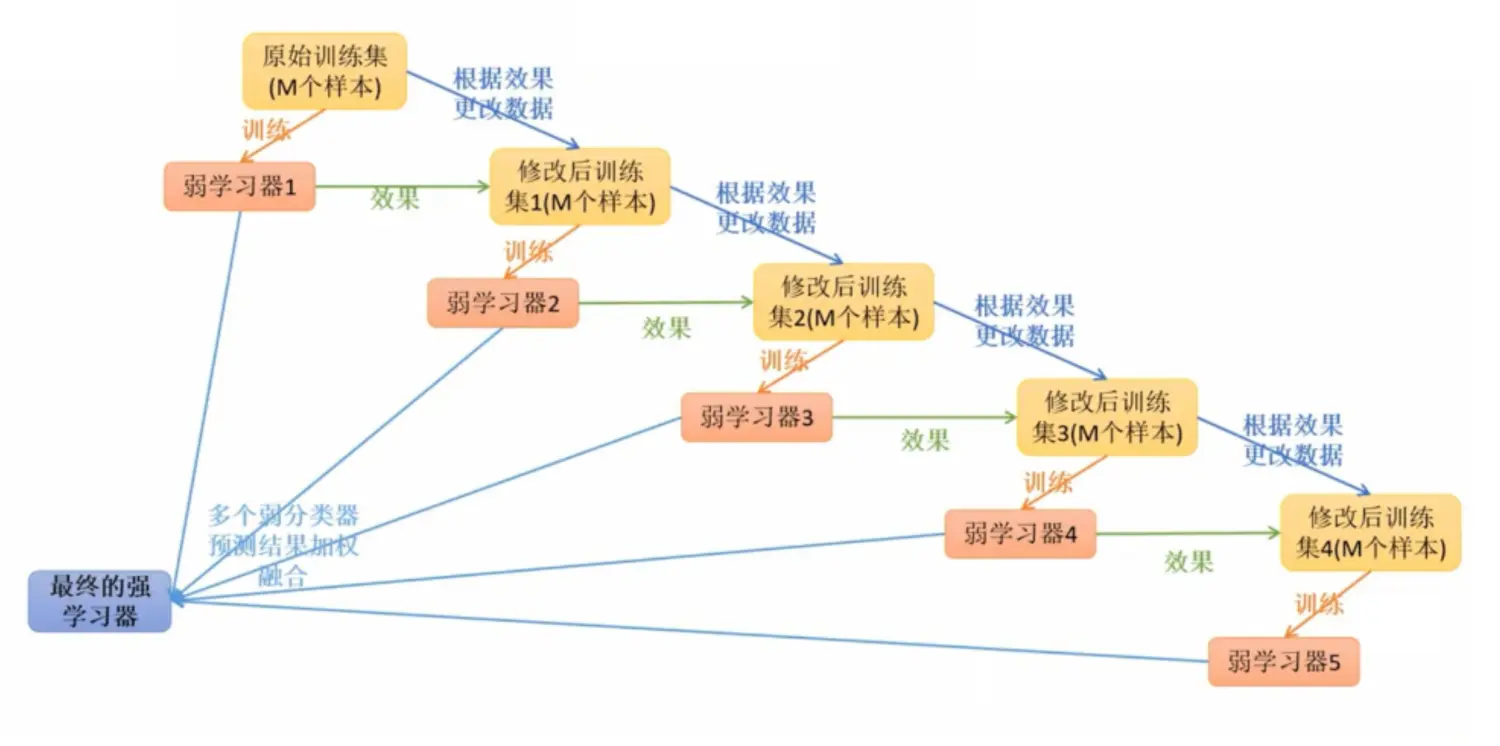

集成学习 什么是集成学习集成学习(ensemble learning)本身不是一个单独的机器学习算 法,而是通过构建并结 合多个机器学习模型来完成学习任务——博采众长。集成学习很好 的避免了单一学习模型带 来的过拟合问题。 集成学习的类型根据个体学习器的生成方式,目前的集成学习方法大致可分为两 大类:Bagging(个体学习器间不存在强依赖关系、可同时生成的并行化 方法)Boosting(个体学....

Machine Learning-L12-集成学习:Boosting/Bagging/随机森林

集成学习通过构建并结合多个学习器来完成学习任务,然后把结果整合起来进行整体预测。也称为multi-classifier system、committee-based learning。对于训练集数据,训练若干个个体学习器,并通过一定的结合策略,最终形成一个强学习器。集成学习常可获得比单一学习器显著优越的泛化性能。集成学习要求个体学习器(individual learner)要有一定的准确性及多样....

集成学习(Bagging,Boosting) 简介

引言 一个人的力量是渺小的,但是一群人聚集到一起,就有了群体智慧。如在我们的城市的社会分工中,有的人是工程师,政客,有的人是建筑工人,有的人是教师,也有罪犯等等,每个人对这座城市都贡献着价值,整座城市也就井然有序,盎然向上,由于每个人对社会的作用不同,甚至有的为负贡献如罪犯等,如果有一个决策机关如政府的存在,就可以使数以百万人口的城市运作起来,而不是一盘散沙的存在。这种集聚群体智慧的思想,衍生出....

06 集成学习 - Boosting - GBDT算法原理、总结

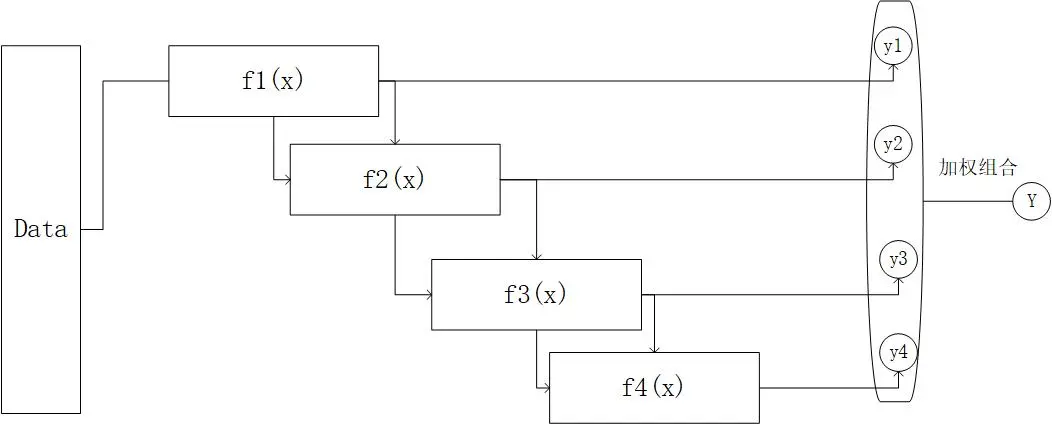

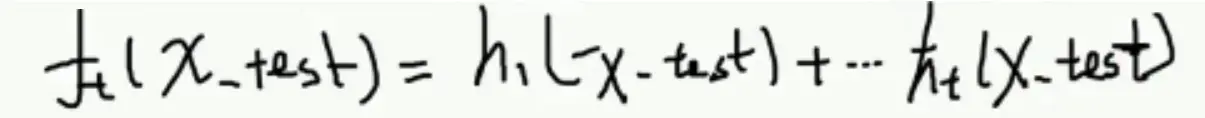

05 集成学习 - Boosting - GBDT初探 十四、GBDT的构成 ● GBDT由三部分构成:DT(Regression Decistion Tree-回归决策树)、GB(Gradient Boosting-梯度提升)、Shrinkage(衰减)1、先构建__回归决策树__,然后用到提升的思想:ft(x) = ∑ ht(x);2、__梯度提升:__ 下一个模在拟合上一个模型的残差,其.....

05 集成学习 - Boosting - GBDT初探

04 集成学习 - Boosting - AdaBoost算法构建 回顾: 1、Bagging-随机森林是一个并行模型,Boosting是一个串行模型,所以Boosting模型运算效率会低一些。2、Bagging算法解决的是模型过拟合问题,Boosting模型解决的是欠拟合问题。 十一、梯度提升迭代决策树 - GBDT GBDT(Gradient Boosting Decison Tree 梯度....

04 集成学习 - Boosting - AdaBoost算法构建

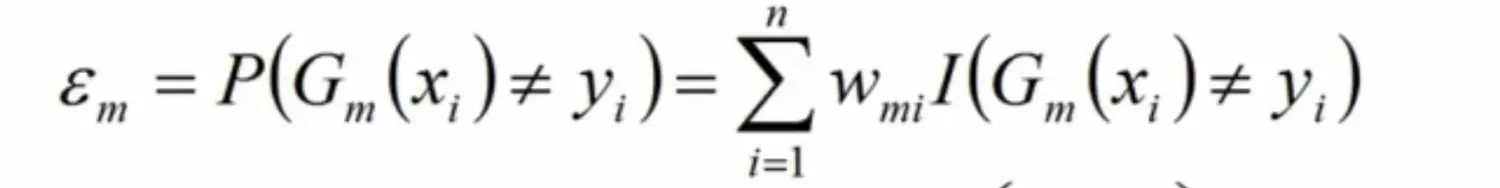

03 集成学习 - Boosting - AdaBoost算法原理 十、AdaBoost算法构建 上一章最后说明了每个基模型的权值α是如何求得的,于是我就可以对模型进行更新操作了。 构建过程一 1、假设数据集: T={(X1,Y1),(X2,Y2),...(Xn,Yn)} 2、初始化训练数据权重分布:D1={w11,w12,...,w1i,...,w1n},w1i = 1/n , i=1,2,3....

03 集成学习 - Boosting - AdaBoost算法原理

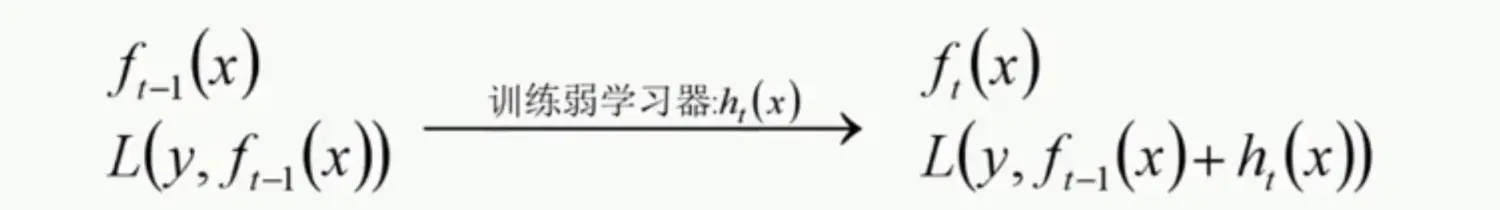

02 集成学习 - 特征重要度、Extra Tree、TRTE、IForest、随机森林总结 八、Boosting 提升学习 提升学习是一种机器学习技术,可以用于__回归__和__分类__问题。它每一步产生__弱预测模型__ (如决策树),并__加权累加__到总模型中。如果每一步的弱预测模型的生成都是依据损失函数的梯度方式的,那么称为__梯度提升__(Gradient Boosting)。 提升....

集成学习之Boosting —— Gradient Boosting原理

集成学习之Boosting —— AdaBoost原理 集成学习之Boosting —— AdaBoost实现 集成学习之Boosting —— Gradient Boosting原理 集成学习之Boosting —— Gradient Boosting实现 上一篇介绍了AdaBoost算法,AdaBoost每一轮基学习器训练过后都会更新样本权重,再训练下一个学习器,最后将所有的基学习器加权组.....

集成学习之Boosting —— Gradient Boosting实现

Gradient Boosting的一般算法流程 初始化: \(f_0(x) = \mathop{\arg\min}\limits_\gamma \sum\limits_{i=1}^N L(y_i, \gamma)\) for m=1 to M: (a) 计算负梯度: $\tilde{y}_i = -\frac{\partial L(y_i,f_{m-1}(x_i))}{\partial ...

集成学习之Boosting —— AdaBoost实现

集成学习之Boosting —— AdaBoost原理 集成学习之Boosting —— AdaBoost实现 AdaBoost的一般算法流程 输入: 训练数据集 \(T = \left \{(x_1,y_1), (x_2,y_2), \cdots (x_N,y_N)\right \}\),\(y\in\left\{-1,+1 \right\}\),基学习器\(G_m(x)\),训练轮数M ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

集成学习相关内容

- 集成学习性能

- 学习集成swagger

- 学习集成

- 机器学习集成学习

- 模型集成学习

- 集成学习stacking

- 集成学习随机森林

- 集成学习梯度

- 集成学习机器学习

- 集成学习learning

- 集成学习分类

- 机器学习集成学习模型

- 分类集成学习

- 集成学习bagging boosting

- 机器学习集成学习boosting

- 集成学习原理

- 集成学习树

- 集成学习gradient

- 集成学习梯度树

- 集成学习决策树

- 集成学习gradient boosting

- scikit-learn集成学习

- 教程集成迁移学习

- 教程集成学习

- 集成迁移学习

- xgboost集成学习

- 集成学习模型

- 学习集成gitlab

- 集成学习task1

- 集成学习机器学习模型