通过Spark SQL读DLF管理的数据

数据湖构建 DLF(Data Lake Formation)提供了统一的元数据管理、统一的权限与安全管理、便捷的数据入湖能力以及一键式数据探索能力,您可以在云原生数据仓库 AnalyticDB MySQL 版中通过Spark SQL访问DLF中的元数据。

Spark SQL交互式查询

如果您需要以交互式方式执行Spark SQL,可以指定Spark Interactive型资源组作为执行查询的资源组。资源组的资源量会在指定范围自动扩缩容,在满足您交互式查询需求的同时还可以降低使用成本。本文为您详细介绍如何通过控制台、Hive JDBC、PyHive、Beeline、DBeaver等客户端工具实现Spark SQL交互式查询。

ADB Spark SQL的使用

DataWorks的ADB Spark SQL节点可进行AnalyticDB Spark SQL任务的开发和周期性调度,以及与其他作业的集成操作。本文为您介绍使用ADB Spark SQL节点进行任务开发的主要流程。

通过Spark SQL读写Azure Blob Storage外表

本文主要介绍如何在云原生数据仓库 AnalyticDB MySQL 版中使用Spark SQL读写Azure Blob Storage中的数据。

Spark SQL诊断优化

云原生数据仓库 AnalyticDB MySQL 版推出Spark SQL诊断功能,若您提交的Spark SQL存在性能问题,您可以根据诊断信息快速定位、分析并解决性能瓶颈问题,优化Spark SQL。本文主要介绍如何进行Spark SQL性能诊断以及性能诊断的示例。

【Spark】(八)Spark SQL 应用解析2

四、Spark SQL 操作Hive表4.1 文件配置分别复制 hive lib、conf 目录下文件到 spark 的jars 目录下[root@zj1 sbin]# cd /opt/soft/hive110/lib/ [root@zj1 lib]# cp mysql-connector-java-5.1.39-bin.jar /opt/soft/spark234/jars/ [root@zj....

【Spark】(八)Spark SQL 应用解析1

文章目录一、Spark SQL的进化之路二、认识Spark SQL2.1 什么是Spark SQL?2.2 Spark SQL的作用2.3 运行原理2.4 特点2.5 Spark SQL数据抽象三、Spark SQL API3.1 SparkSession3.2 DataSet ( Spark1. 6 + )1、创建 DataSet2、使用case Class 创建 DataSet3、使用Dat....

Spark之SQL解析(源码阅读十)

如何能更好的运用与监控sparkSQL?或许我们改更深层次的了解它深层次的原理是什么。之前总结的已经写了传统数据库与Spark的sql解析之间的差别。那么我们下来直切主题~ 如今的Spark已经支持多种多样的数据源的查询与加载,兼容了Hive,可用JDBC的方式或者ODBC来连接Spark SQL。下图为官网给出的架构.那么sparkSql呢可以重用Hive本身提供的元数据仓库(Meta....

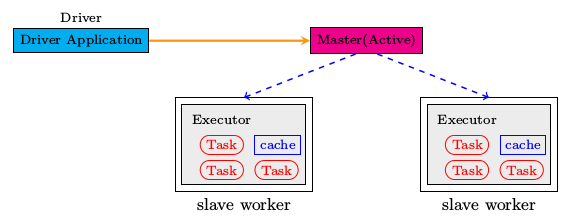

Apache Spark源码走读(七)Standalone部署方式分析&sql的解析与执行

<一>Standalone部署方式分析 楔子 在Spark源码走读系列之2中曾经提到Spark能以Standalone的方式来运行cluster,但没有对Application的提交与具体运行流程做详细的分析,本文就这些问题做一个比较详细的分析,并且对在standalone模式下如何实现HA进行讲解。 没有HA的Standalone运行模式 先从比较简单的说起,所谓的没有ha是指ma....

Spark修炼之道(进阶篇)——Spark入门到精通:第九节 Spark SQL运行流程解析

1.整体运行流程 使用下列代码对SparkSQL流程进行分析,让大家明白LogicalPlan的几种状态,理解SparkSQL整体执行流程 // sc is an existing SparkContext. val sqlContext = new org.apache.spark.sql.SQLContext(sc) // this is used to implicitly conve...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

SQL spark相关内容

- spark原理SQL

- 大数据spark SQL hive

- spark集群SQL

- spark sparksql SQL

- spark SQL json

- spark SQL jdbc

- spark SQL rdd

- 仓库spark SQL访问

- spark SQL简介

- spark SQL开发

- spark SQL打包

- spark SQL oss

- dms spark SQL任务

- spark SQL任务

- e-mapreduce spark SQL

- spark SQL权限控制

- mapreduce spark SQL

- spark SQL节点

- dms spark SQL

- spark SQL访问

- spark SQL mapreduce

- spark SQL组件

- 跨库spark SQL库

- spark编程SQL

- 大数据SQL spark

- SQL引擎spark

- hive SQL引擎spark

- 数据计算SQL spark

- spark SQL原理

- odps spark SQL

SQL更多spark相关

- spark SQL分区

- spark SQL聚合

- spark SQL数据分析

- spark SQL案例

- spark SQL dataset

- spark SQL引擎

- spark SQL数据源

- 大数据技术spark SQL

- 技术spark SQL

- 大数据spark SQL dataframe dataset

- spark SQL编程

- spark SQL学习

- spark SQL schema

- spark SQL格式

- spark SQL概念学习

- hadoop spark SQL

- hudi spark SQL源码学习

- 跨库spark SQL

- spark SQL功能

- spark SQL实战

- spark入门SQL

- 大数据spark SQL

- spark程序SQL

- 大数据进阶spark SQL

- spark SQL parquet

- spark源码SQL

- hudi spark SQL源码学习ctas

- spark SQL构建

- spark SQL表格存储

- spark SQL源码

数据库

分享数据库前沿,解构实战干货,推动数据库技术变革

+关注