国内大模型LLM选择以及主流大模型快速使用教程[GLM4/Qwen/Baichuan/Coze/Kimi]

国内大模型LLM选择以及主流大模型快速使用教程[GLM4/Qwen/Baichuan/Coze/Kimi] 0. 大模型选择 司南测评结果: SuperCLue测评结果: 自2023年5月以来,全球及中国国内的大模型技术均展现出了强劲的发展势头,尤其是以GPT系列为代表的海外顶尖模型,历经了从GPT3.5到GPT4、GPT4-Turbo乃至GPT4o的多次迭代飞跃,持续推动A...

![国内大模型LLM选择以及主流大模型快速使用教程[GLM4/Qwen/Baichuan/Coze/Kimi]](https://ucc.alicdn.com/fnj5anauszhew_20240719_0df91b992f6e46679412ad488156448c.png)

开箱黑盒LLM!谷歌大一统框架Patchscopes实战教程来了

最近,谷歌推出了一种名为Patchscopes的大一统框架,用于解决大型语言模型(LLM)的黑盒问题。这个框架旨在通过提供一个可解释的模型,使LLM更易于理解和调试。在本文中,我们将对Patchscopes进行深入研究,并提供一个实战教程,帮助你理解和应用这个强大的工具。 Patchs...

【人工智能技术专题】「入门到精通系列教程」零基础带你进军人工智能领域的全流程技术体系和实战指南(LLM、AGI和AIGC都是什么)(二)

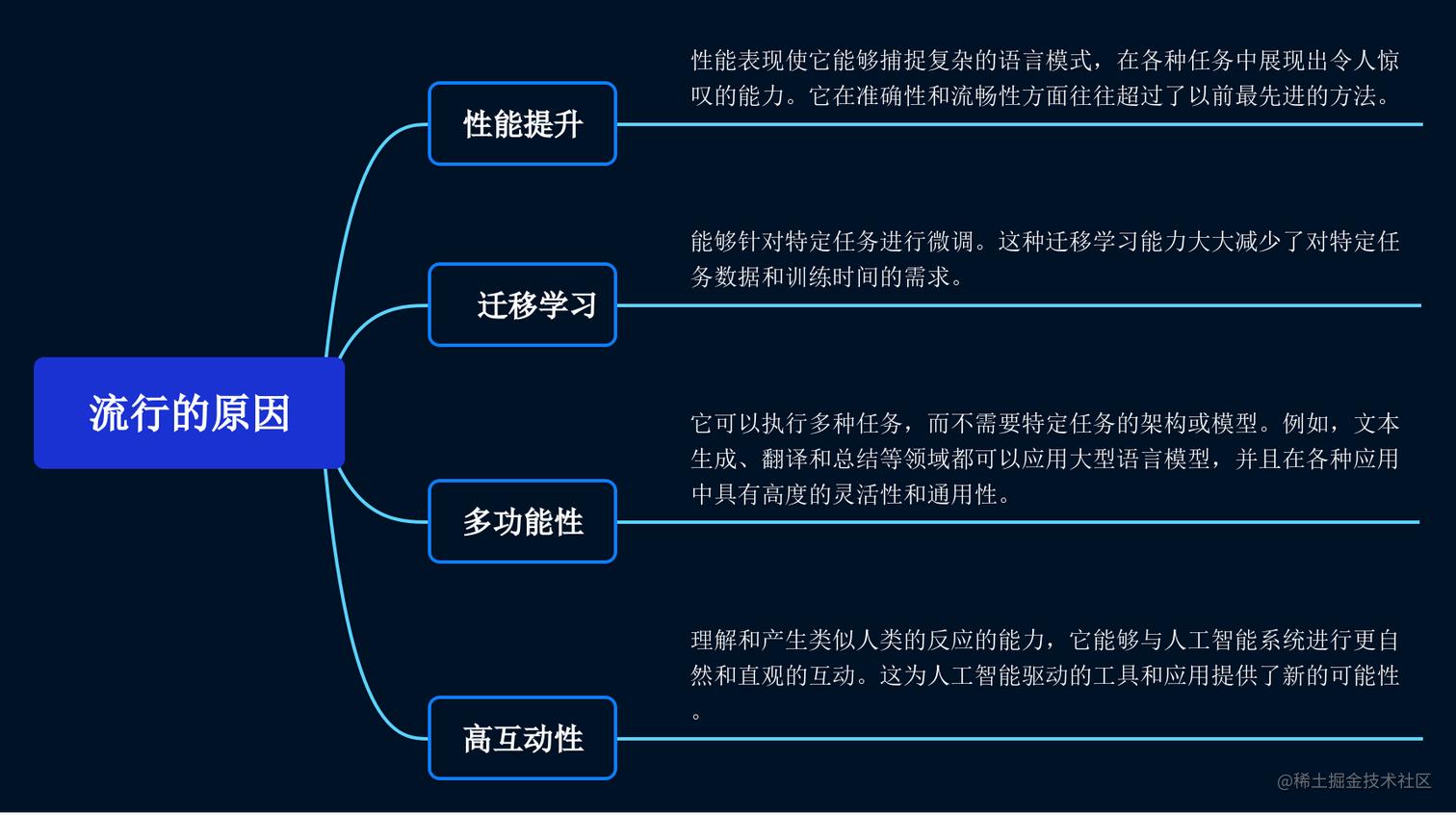

【人工智能技术专题】「入门到精通系列教程」零基础带你进军人工智能领域的全流程技术体系和实战指南(LLM、AGI和AIGC都是什么)(一)https://developer.aliyun.com/article/1471020 流行原因 大型语言模型出色的性能表现使它能够捕捉复杂的语言模式,在各种任务中展现出令人惊叹的能力。它在准确性和流畅性方面往往超过了以前最先进的方法...

【人工智能技术专题】「入门到精通系列教程」零基础带你进军人工智能领域的全流程技术体系和实战指南(LLM、AGI和AIGC都是什么)(一)

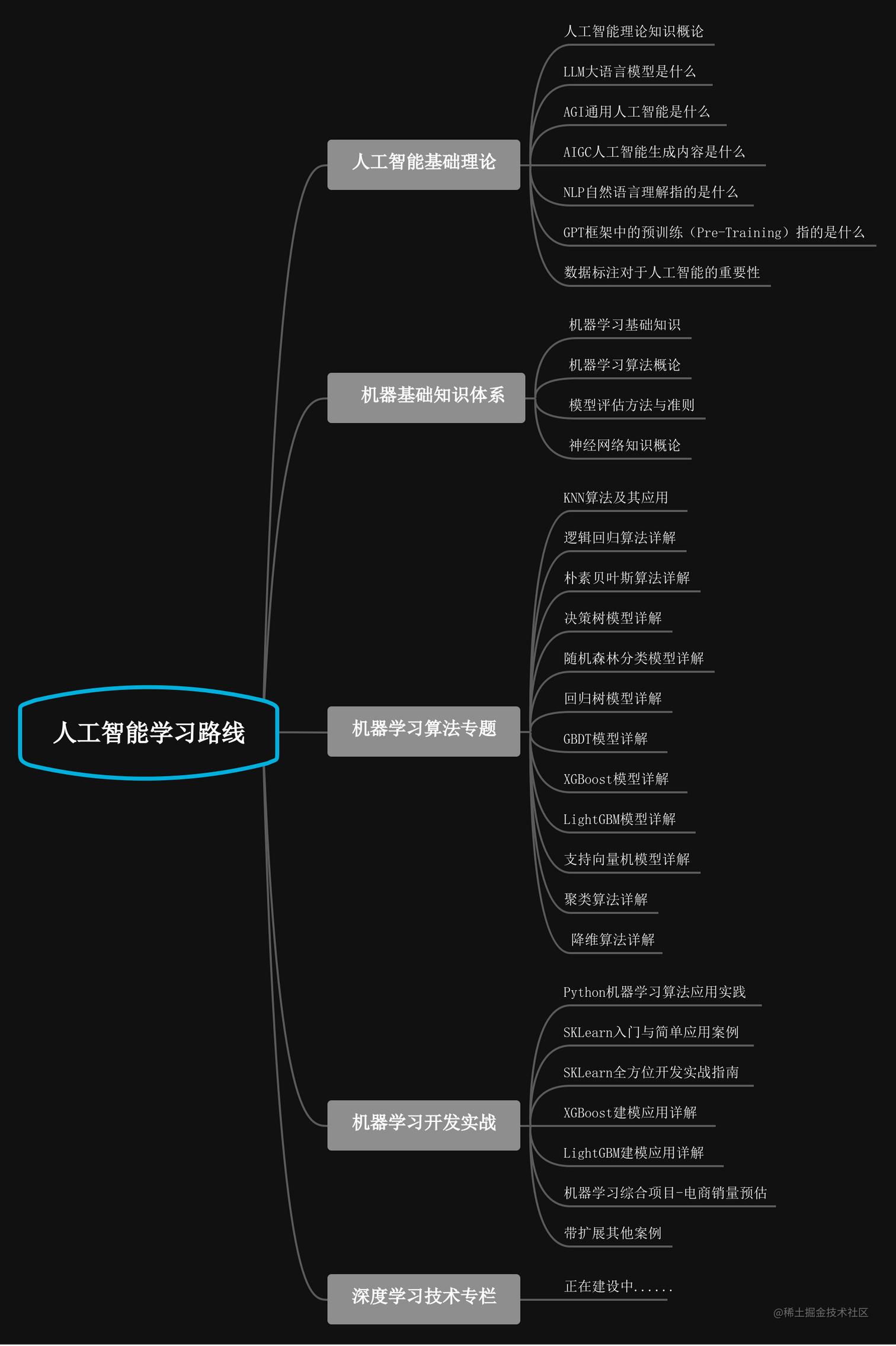

前言 人工智能是一个庞大的研究领域。虽然我们已经在人工智能的理论研究和算法开发方面取得了一定的进展,但是我们目前掌握的能力仍然非常有限。机器学习是人工智能的一个重要领域,它研究计算机如何模拟或实现人类的学习行为,以获取新的知识或技能,并通过重新组织已有的知识结构来不断提高自身的性能。深度学习是机器学习中的一个研究方向,通过多层处理,将初始的“低层”特征表示逐渐转化为“高层”特征表示,从而...

谷歌发布开源LLM Gemma,魔搭社区评测+最佳实践教程来啦!

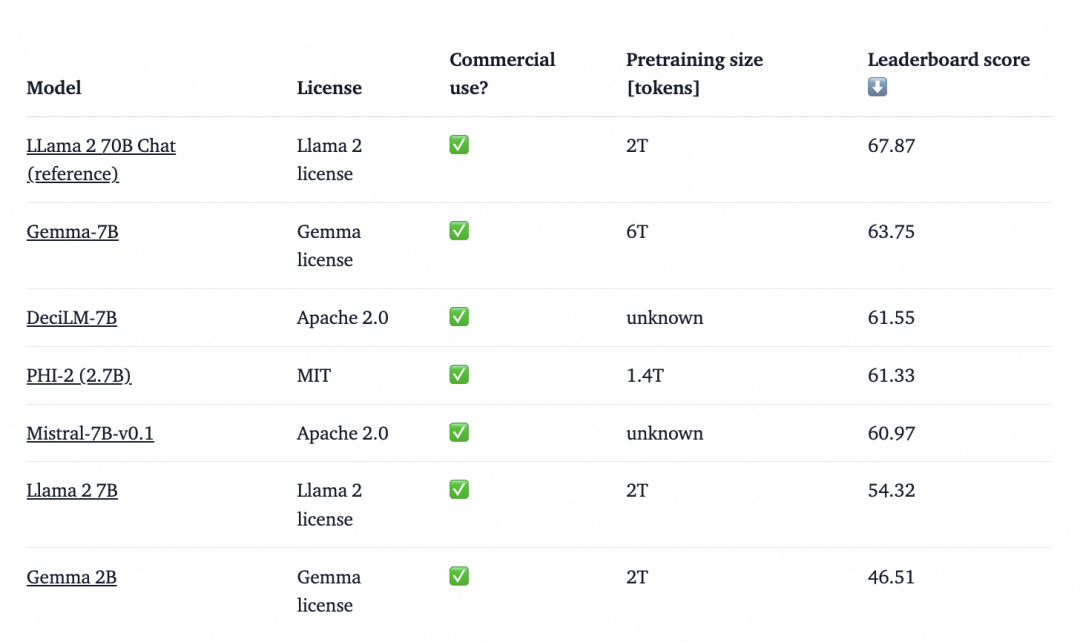

导读 Gemma是由Google推出的一系列轻量级、先进的开源模型,他们是基于 Google Gemini 模型的研究和技术而构建。它们是一系列text generation,decoder-only的大型语言模型,对英文的支持较好,具有模型权重开源、并提供预训练版本(base模型)和指令微调版本(chat模型)。本次Gemma开源提供了四个大型语言模型,提供了 2B 和 7B...

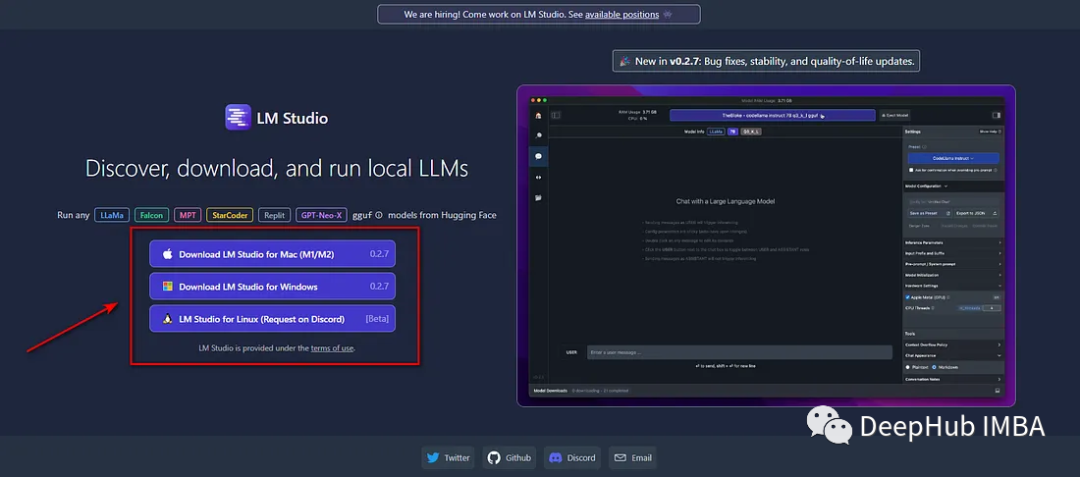

使用LM Studio在本地运行LLM完整教程

在开源类别中出于以下的原因,你可能会考虑过在本地计算机上本地运行LLM : 脱机:不需要互联网连接。 模型访问:在本地运行模型,可以尝试开源模型(Llama 2、Vicuna、Mistral、OpenOrca等等)。 隐私:当在本地运行模型时,没有信息被传输到云。尽管在使用GPT-4、Bard和claude 2等基于云的模型时,隐私问题可能被夸大了,但在本地运行模型可以避免任何问题。 ...

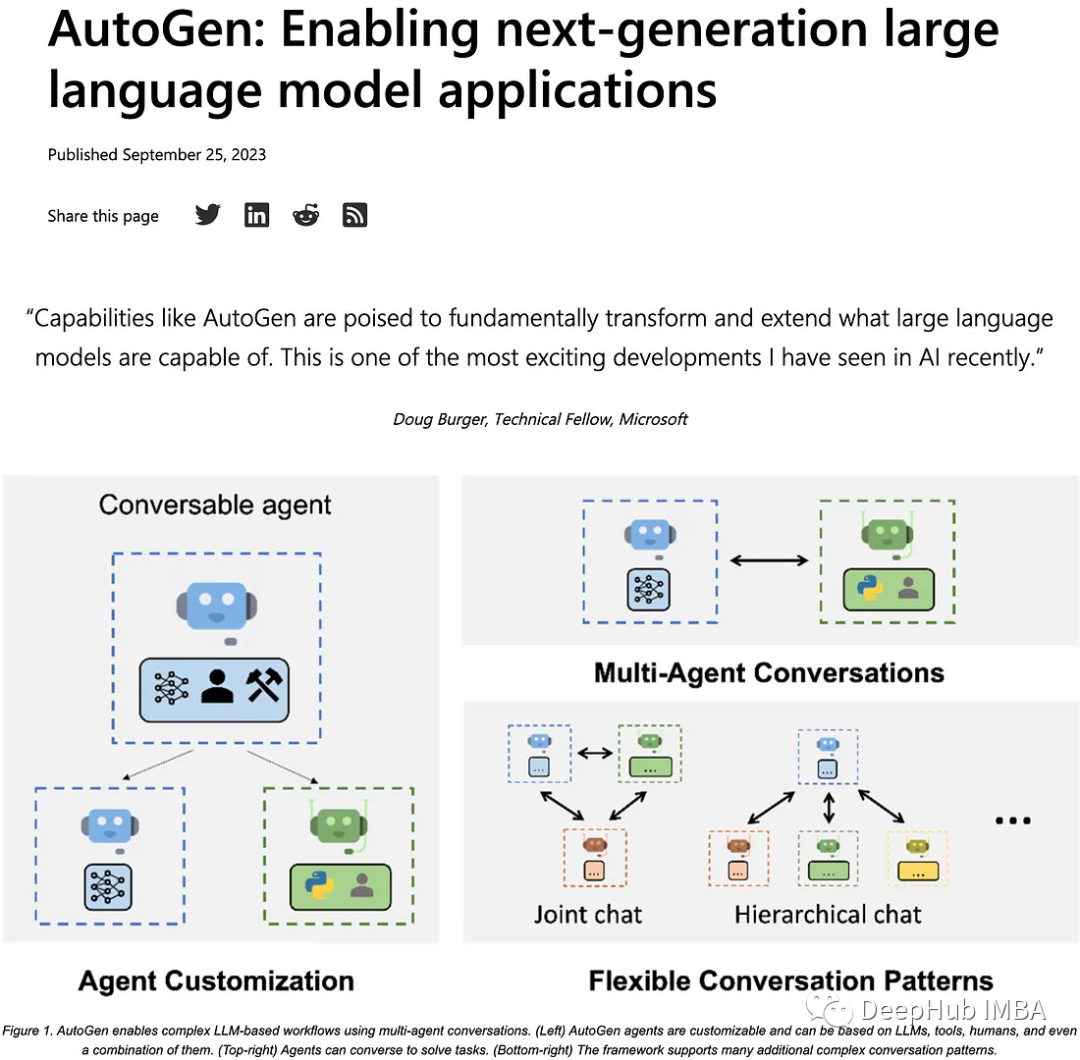

AutoGen完整教程和加载本地LLM示例

Autogen是一个卓越的人工智能系统,它可以创建多个人工智能代理,这些代理能够协作完成任务,包括自动生成代码,并有效地执行任务。 在本文中,我们将深入探讨Autogen,并介绍如何让AutoGen使用本地的LLM AutoGen Autogen能够设置多个人工智能代理,它们协同工作以实现特定目标。以下截图来自微软官方博客 使用conda创建环境: conda create -n...

绕开算力限制,如何用单GPU微调 LLM?这是一份「梯度累积」算法教程(2)

由于没有多的 GPU 可用于张量分片(tensor sharding),又能做些什么来训练具有更大批大小(batch size)的模型呢?其中一种解决方法就是梯度累积,可以通过它来修改前面提到的训练循环。什么是梯度积累?梯度累积是一种在训练期间虚拟增加批大小(batch size)的方法,当可用的 GPU 内存不足以容纳所需的批大小时,这非常有用。在梯度累积中,梯度是针对较小的批次计算的,并在多....

绕开算力限制,如何用单GPU微调 LLM?这是一份「梯度累积」算法教程

让算力资源用到极致,是每一位开发者的必修课。自从大模型变成热门趋势之后,GPU 就成了紧俏的物资。很多企业的储备都不一定充足,更不用说个人开发者了。有没有什么方法可以更高效的利用算力训练模型?在最近的一篇博客,Sebastian Raschka 介绍了「梯度累积」的方法,能够在 GPU 内存受限时使用更大 batch size 训练模型,绕开硬件限制。在此之前,Sebastian Raschka....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。