【机器学习】集成学习(Boosting)——AdaBoost提升算法(理论+图解+公式推导)

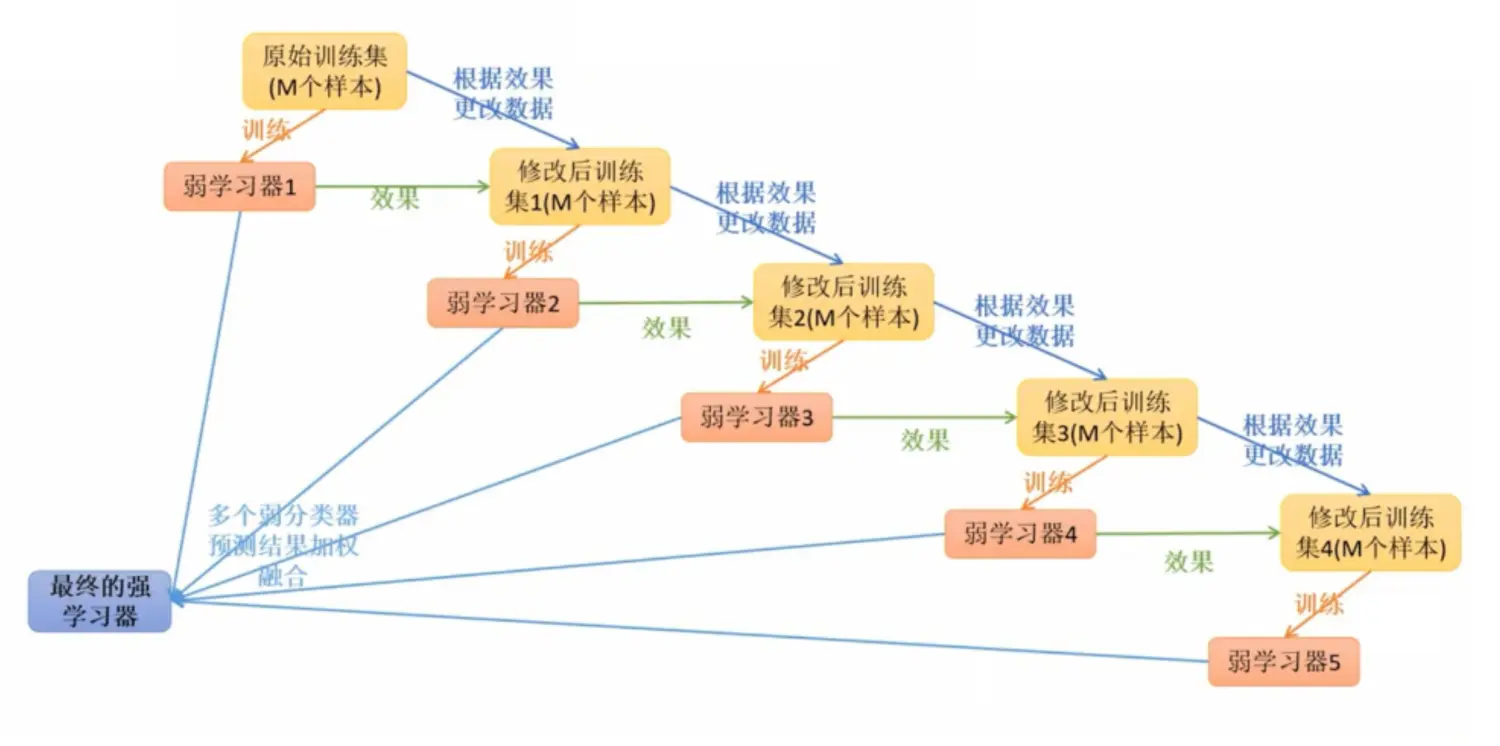

2021人工智能领域新星创作者,带你从入门到精通,该博客每天更新,逐渐完善机器学习各个知识体系的文章,帮助大家更高效学习。一、集成学习我们平常使用的大多数模型都为单模型方式,有时单模型方式可能会造成误判或者过拟合的现象,所以我们就像能不能有一种方式可以融合多个模型,这就产生了集成学习的概念。集成学习通过构建多个分类器来完成学习任务,有时被称为多分类器系统,它是基于多个分类器共同完成模型的生成,集....

04 集成学习 - Boosting - AdaBoost算法构建

03 集成学习 - Boosting - AdaBoost算法原理 十、AdaBoost算法构建 上一章最后说明了每个基模型的权值α是如何求得的,于是我就可以对模型进行更新操作了。 构建过程一 1、假设数据集: T={(X1,Y1),(X2,Y2),...(Xn,Yn)} 2、初始化训练数据权重分布:D1={w11,w12,...,w1i,...,w1n},w1i = 1/n , i=1,2,3....

03 集成学习 - Boosting - AdaBoost算法原理

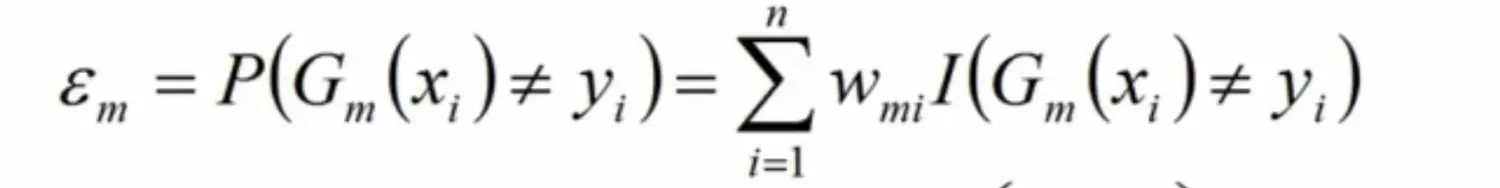

02 集成学习 - 特征重要度、Extra Tree、TRTE、IForest、随机森林总结 八、Boosting 提升学习 提升学习是一种机器学习技术,可以用于__回归__和__分类__问题。它每一步产生__弱预测模型__ (如决策树),并__加权累加__到总模型中。如果每一步的弱预测模型的生成都是依据损失函数的梯度方式的,那么称为__梯度提升__(Gradient Boosting)。 提升....

集成学习之Boosting —— AdaBoost实现

集成学习之Boosting —— AdaBoost原理 集成学习之Boosting —— AdaBoost实现 AdaBoost的一般算法流程 输入: 训练数据集 \(T = \left \{(x_1,y_1), (x_2,y_2), \cdots (x_N,y_N)\right \}\),\(y\in\left\{-1,+1 \right\}\),基学习器\(G_m(x)\),训练轮数M ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

集成学习相关内容

- 集成学习性能

- 学习集成swagger

- 学习集成

- 机器学习集成学习

- 模型集成学习

- 集成学习stacking

- 集成学习随机森林

- 集成学习梯度

- 集成学习机器学习

- 集成学习learning

- 集成学习分类

- 机器学习集成学习模型

- 分类集成学习

- 集成学习bagging boosting

- 机器学习集成学习boosting

- 集成学习boosting

- 集成学习原理

- 集成学习树

- 集成学习gradient

- 集成学习梯度树

- 集成学习决策树

- 集成学习gradient boosting

- scikit-learn集成学习

- 教程集成迁移学习

- 教程集成学习

- 集成迁移学习

- xgboost集成学习

- 集成学习模型

- 学习集成gitlab

- 集成学习task1