机器学习测试笔记(20)——集成学习

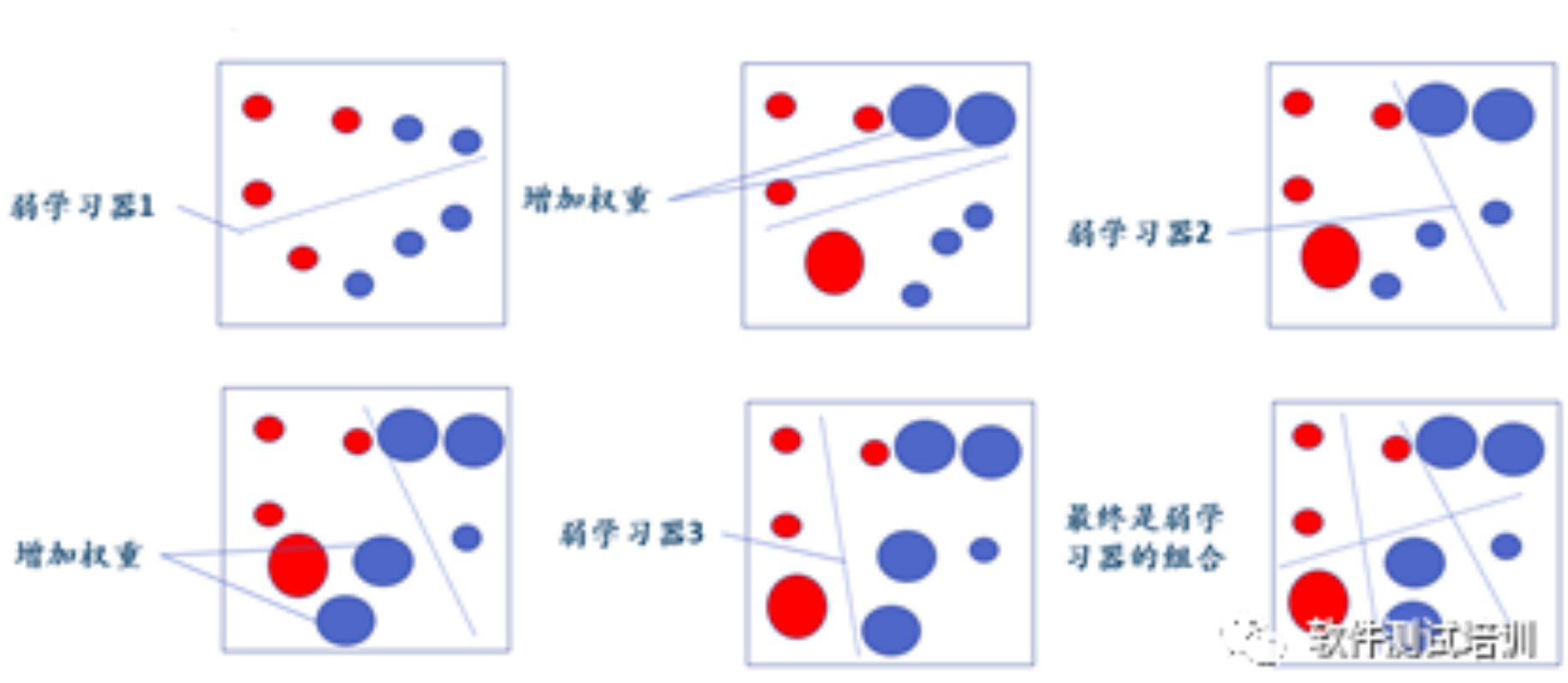

1.概念集成学习将多个训练的基础学习器进行结合,优化为更先进的学习器。集成学习模型的方式大致为以下几个:bagging、boosting、voting、stacking。它的特点是:初始化,对m个训练样本的数据集(不同颜色代表不同数据集),给每个样本分配初始权重(圆点越大,权重越大);使用带权重的数据集训练处一个弱学习器;对弱学习器训练的错误样本增加权重;新的带权重的数据集训练处下一个弱学习器;....

《从机器学习到深度学习》笔记(5)集成学习之随机森林

集成学习模型与其他有监督模型的出发点大相径庭,之前的模型都是在给定的训练集上通过构建越来越强大的算法进行数据拟合。而集成学习着重于在训练集上做文章:将训练集划分为各种子集或权重变换后用较弱的基模型拟合,然后综合若干个基模型的预测作为最终整体结果。在Scikit-Learn中实现了两种类型的集成学习算法,一种是Bagging methods,另一种是Boosting methods。 随机森林(R....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

集成学习相关内容

- 集成学习性能

- 学习集成swagger

- 学习集成

- 机器学习集成学习

- 模型集成学习

- 集成学习stacking

- 集成学习随机森林

- 集成学习梯度

- 集成学习机器学习

- 集成学习learning

- 集成学习分类

- 机器学习集成学习模型

- 分类集成学习

- 集成学习bagging boosting

- 机器学习集成学习boosting

- 集成学习boosting

- 集成学习原理

- 集成学习树

- 集成学习gradient

- 集成学习梯度树

- 集成学习决策树

- 集成学习gradient boosting

- scikit-learn集成学习

- 教程集成迁移学习

- 教程集成学习

- 集成迁移学习

- xgboost集成学习

- 集成学习模型

- 学习集成gitlab

- 集成学习task1