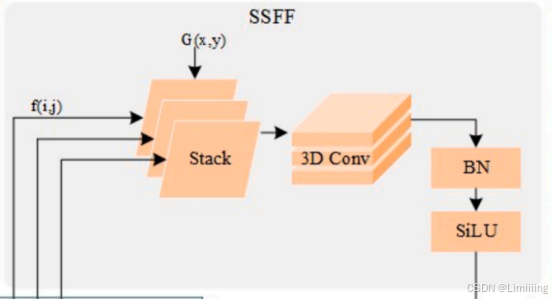

RT-DETR改进策略【Neck】| ASF-YOLO 注意力尺度序列融合模块改进颈部网络,提高小目标检测精度

一、本文介绍 本文记录的是利用ASF-YOLO提出的颈部结构优化RT-DETR的目标检测网络模型。将RT-DETR的颈部网络改进成ASF-YOLO的结构,==使模型能够有效的融合多尺度特征,捕获小目标精细信息,并根据注意力机制关注小目标相关特征,显著提高模型精度。== 专栏目录:RT-DETR改进目录一览 | 涉及卷积层、轻量化、注意力、损失函数、Backbone、SPPF、Neck、检测头等.....

RT-DETR改进策略【Conv和Transformer】| TPAMI-2024 Conv2Former 利用卷积调制操作和大核卷积简化自注意力机制,提高网络性能

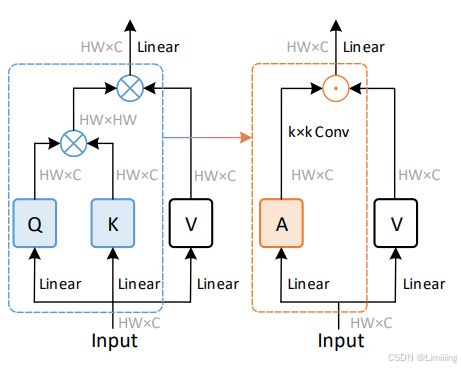

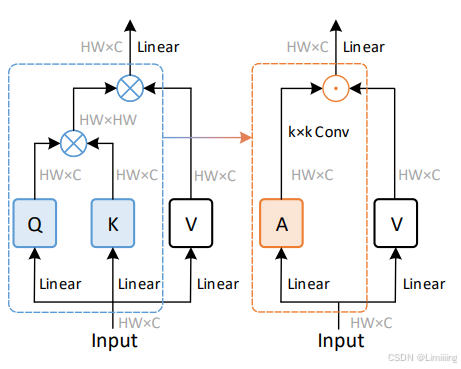

一、本文介绍 本文记录的是利用Conv2Former优化RT-DETR的目标检测网络模型。Transformer通过自注意力机制能够获取全局信息,但资源占用较大。卷积操作资源占用较少,但只能根据卷积核的大小获取局部信息。Conv2Former==通过卷积调制操作简化了自注意力机制,更有效地利用了大核卷积,在视觉识别任务中表现出较好的性能。== 专栏目录:RT-DETR改进目录一览 | 涉及卷积.....

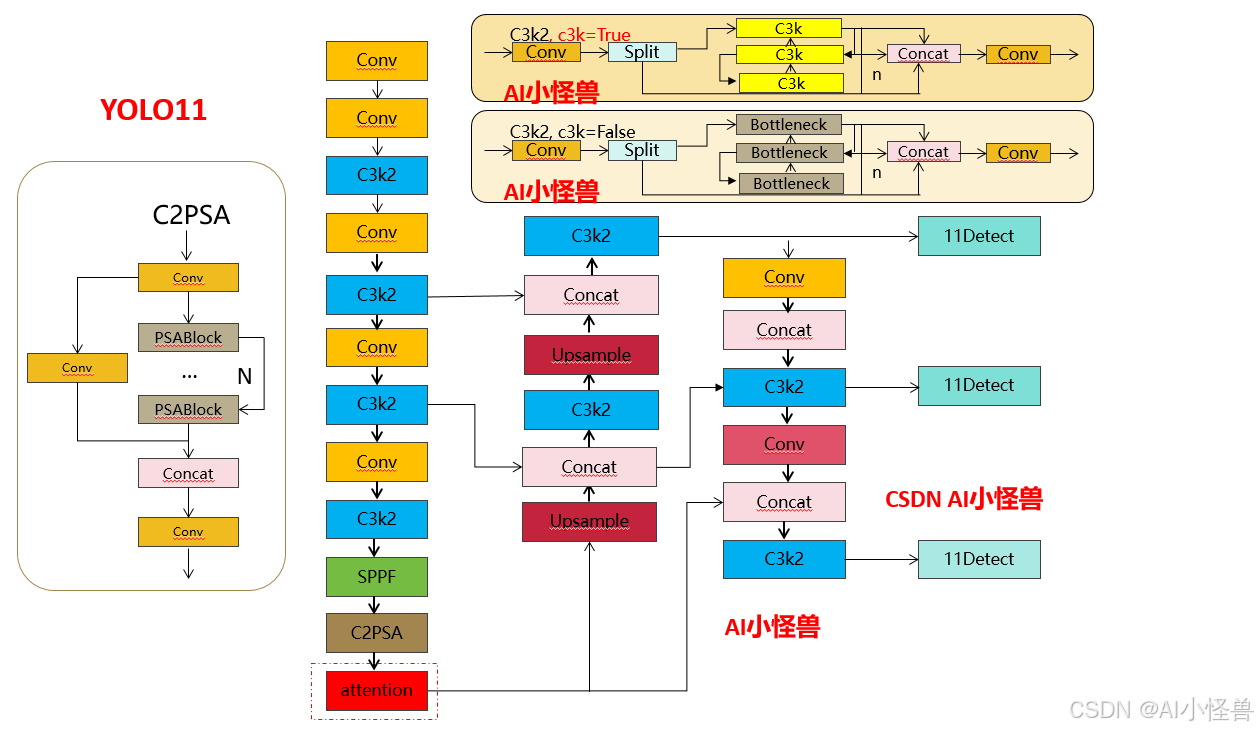

YOLOv11改进策略【Neck】| ASF-YOLO 注意力尺度序列融合模块改进颈部网络,提高小目标检测精度

一、本文介绍 本文记录的是利用ASF-YOLO提出的颈部结构优化YOLOv11的目标检测网络模型。将YOLOv11的颈部网络改进成ASF-YOLO的结构,==使模型能够有效的融合多尺度特征,捕获小目标精细信息,并根据注意力机制关注小目标相关特征,显著提高模型精度。== 专栏目录:YOLOv11改进目录一览 | 涉及卷积层、轻量化、注意力、损失函数、Backbone、SPPF、Neck、检测头等.....

YOLOv11改进策略【Conv和Transformer】| TPAMI-2024 Conv2Former 利用卷积调制操作和大核卷积简化自注意力机制,提高网络性能

一、本文介绍 本文记录的是利用Conv2Former优化YOLOv11的目标检测网络模型。Transformer通过自注意力机制能够获取全局信息,但资源占用较大。卷积操作资源占用较少,但只能根据卷积核的大小获取局部信息。Conv2Former==通过卷积调制操作简化了自注意力机制,更有效地利用了大核卷积,在视觉识别任务中表现出较好的性能。== 专栏目录:YOLOv11改进目录一览 | 涉及卷积.....

YOLO11实战:新颖的多尺度卷积注意力(MSCA)加在网络不同位置的涨点情况 | 创新点如何在自己数据集上高效涨点,解决不涨点掉点等问题

本文解决的问题点:创新点为什么在自己数据集不涨点,甚至出现降点的现象??? 原因分析:不同数据集加入创新点存在表现不一致是正常现象,甚至放在网络不同位置也存在有的位置能够涨点,有的位置降点现象!!! 如何解决: 将创新点放入不同网络位置并提供对应的yaml文件,总有一种能够在你数据集下高效涨点。所以还是要多做实验,做各种尝试,可能就能取得意外的涨点现象!!! 涨点情况:原...

【YOLOv8改进- Backbone主干】BoTNet:基于Transformer,结合自注意力机制和卷积神经网络的骨干网络

YOLOv8目标检测创新改进与实战案例专栏 专栏目录: YOLOv8有效改进系列及项目实战目录 包含卷积,主干 注意力,检测头等创新机制 以及 各种目标检测分割项目实战案例 专栏链接: YOLOv8基础解析+创新改进+实战案例 介绍 摘要 我们提出了BoTNet,这是一种概念上简单但功能强大的骨干架构,结合了自注意力机制,用于图像分类、目标检测和实例分割等多个计算机视...

【注意力机制重大误区】网络模型增加注意力机制后,性能就一定会得到提升?有哪些影响因素?

在现今的深度学习领域,注意力机制广泛应用于很多网络模型中,而且也取得了十分显著的成果。它能够使模型在处理输入数据时集中注意力于重要的部分,从而达到提升模型性能和精确度的目的。然而,问题来了,增加了注意力机制,网络模型性能真的就一定会提升吗? 很多小伙伴可能经常看到很多文章说,XXX模型增加XXX注意力机制后,性能得到很大改善。就造成了一种错觉,认为只要自己按照别人的方法也在自己...

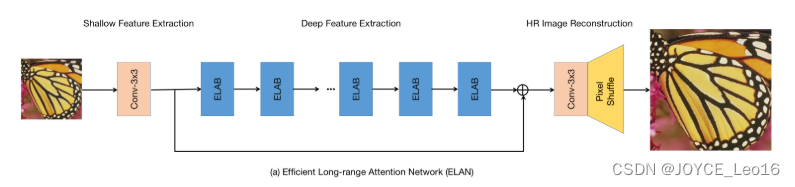

ELAN:用于图像超分辨率的高效远程注意力网络

前言 论文:https://arxiv.org/pdf/2203.06697.pdf 代码:https://github.com/xindongzhang/ELAN 一、Introduction 最近,基于Transformer的方法已经证明了令人印象深刻的效果,在各种视觉任务...

【论文精读】COLING 2022 - CLIO: 用于文档级事件抽取的角色交互多事件头注意力网络

【论文原文】:CLIO: Role-interactive Multi-event Head Attention Network for Document-level Event Extraction【作者信息】:Ren, Yubing and Cao, Yanan and Fang, Fang and Guo, Ping and Lin, Zheng and Ma, Wei and Liu, ....

【论文精读】COLING 2022 -带有对偶关系图注意力网络的事件检测模型

【论文原文】:Event Detection with Dual Relational Graph Attention Networks【作者信息】:Jiaxin Mi and Po Hu and Peng Li论文:https://aclanthology.org/2022.coling-1.172.pdf 代码:https://github.com/Macvh/DualGAT (未上传)博主....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

域名解析DNS

关注DNS行业趋势、技术、标准、产品和最佳实践,连接国内外相关技术社群信息,追踪业内DNS产品动态,加强信息共享,欢迎大家关注、推荐和投稿。

+关注