手把手教学攻略:在Anolis OS上部署OpenVINO深度学习模型

近年人工智能的飞速发展离不开全球开源软件社区的共同努力。龙蜥社区是中国操作软件系统开源社区的领军者之一,发布了 12 款针对多种行业用户需求的操作系统商业版本。通过操作系统和 AI 框架的集成,更好的赋能 AI 开发者,更加方便快捷的进行行业 AI 应用的开发和部署,是龙蜥社区的重要目标。OpenVINO™ 是 Intel 发起的开源深度学习模型优化部署工具,几年来吸引了众多开源社区的合作和开发....

部署NGC容器环境(基于TensorFlow)构建深度学习开发环境

NGC(NVIDIA GPU CLOUD)是NVIDIA开发的一套深度学习生态系统,方便您免费访问深度学习软件堆栈,建立适合深度学习的开发环境。本文以搭建TensorFlow深度学习框架为例,为您介绍如何在GPU实例上部署NGC环境以实现深度学习开发环境的预安装。

ModelScope部署了ollama量化的模型,还可以继续进行优化和深度学习么?

ModelScope部署了ollama量化的模型,还可以继续进行优化和深度学习么?

函数计算部署深度学习模型时,打包的文件容量不同但是下载的时间相同是有优化么?

我在部署深度学习模型时,将代码和模型pt打包存储在远程存储oss中(95M),当我激活这个函数时,代码的下载时间和我把单独把代码部署打包存储在oss中(1.2K)的下载时间一样,请问一下函数计算是对这一部分进行了优化嘛?

使用函数计算部署深度学习模型时用到了pytorch,按照官方推荐的方法,并没有找到torch层?

使用函数计算部署深度学习模型时用到了pytorch,按照官方推荐的方法,并没有找到torch层? 请问这个现在是不支持了嘛

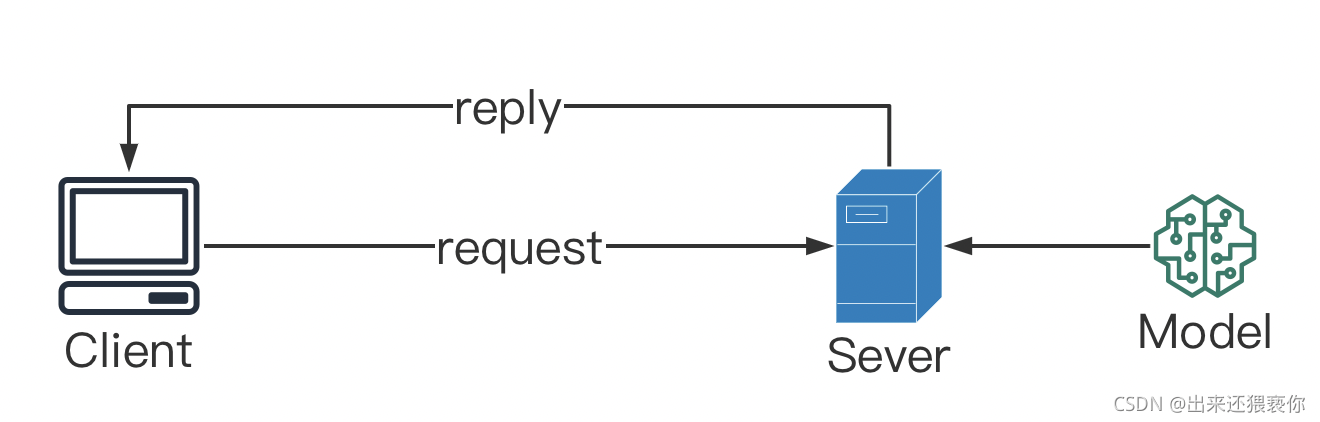

flask部署深度学习api接口

1. flask框架中request请求在日常中我们通常会对我们已经做好的端对端对机器学习或者深度学习项目,部署到网页端或者GPU服务器中,具体的模型工程部署的方法有几种,如下:将模型预测直接打包成http api接口PMMLTensorFlow Serving这里我只介绍第一个,将模型打包成api接口这一种方法将模型打包成api接口通常需要借助一些web框架,最常用的就是flask框架。我们部....

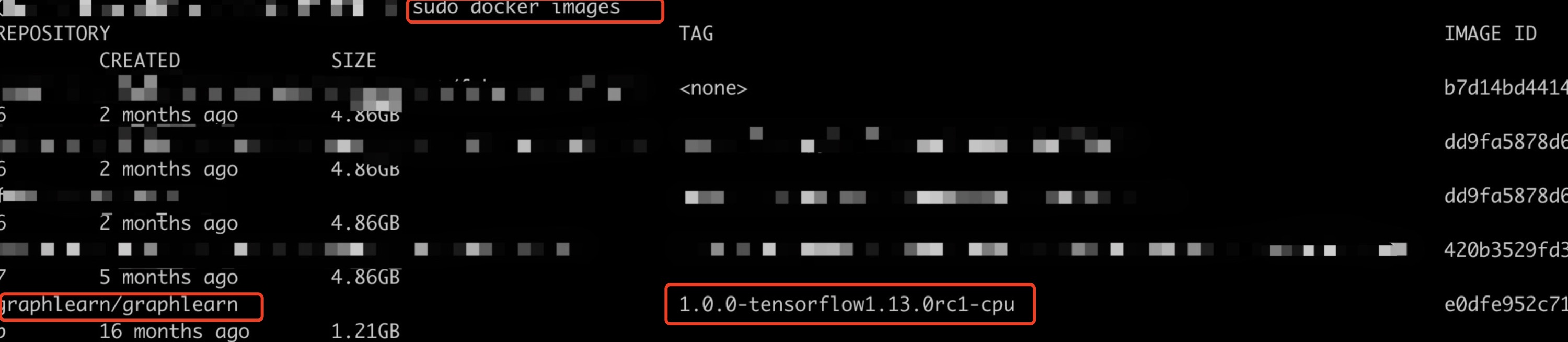

看这里,使用docker部署图深度学习框架GraphLearn使用说明

看这里,使用docker部署图深度学习框架GraphLearn使用说明最近几年,图深度学习(Graph DNN) 火的如火如荼,图以其强大的 关系建模 能力和 可解释 能力,逐步在Embedding 算法设计技术中展露头角。在以前的两篇文章 graphSage还是HAN ?吐血力作综述Graph Embeding 经典好文 和 一文揭开图机器学习的面纱,你确定不来看看吗 ? 中,作者分别对图的基....

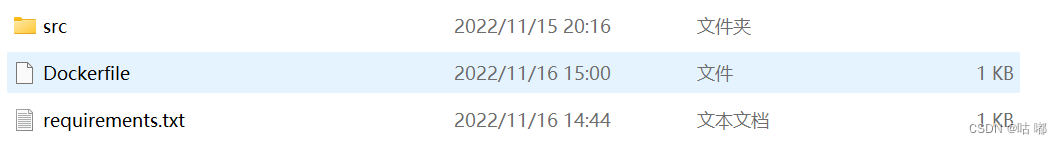

使用Docker部署Python深度学习项目

1、新建一个文件夹里面包含三个文件,分别是Python项目文件、requirements.txt、Dockerfile2、编写Dockerfile这个按照自己的环境以及需求进行修改#基于的基础镜像 FROM python:3.6.8 #代码添加到code文件夹 ADD . /code # 设置code文件夹是工作目录 WORKDIR /code # 安装支持 RUN pip install -r....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

智能引擎技术

AI Online Serving,阿里巴巴集团搜推广算法与工程技术的大本营,大数据深度学习时代的创新主场。

+关注