大数据成长之路-- hadoop集群的部署(3)HDFS新增节点

大数据成长之路-- hadoop集群的部署(3)6、HDFS新增节点服役新数据节点目标:掌握HDFS新添加节点到集群的步骤需求基础:随着公司业务的增长,数据量越来越大,原有的数据节点的容量已经不能满足存储数据的需求,需要在原有集群基础上动态添加新的数据节点。 准备新节点第一步:复制一台新的虚拟机出来将我们纯净的虚拟机复制一台出来,作为我们新的节点 第二步:修改mac地址以及IP地址修改ma...

大数据成长之路------hadoop集群的部署(2)Hadoop集群安装部署

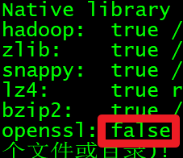

hadoop集群的部署Hadoop集群安装部署1、服务器主机名和IP配置(三台) 2、修改每个主机的/etc/hosts文件,添加IP和主机名的对应关系(三台) 3、管理节点到从节点配置无密码登录 4、配置jdk 1.8(三台) 5、关闭防火墙(三台) 6、关闭selinux(三台) vi /etc/selinux/config SELINUX=enforcing SELIN...

大数据成长之路------hadoop集群的部署 配置系统网络(静态) 新增集群(三台)

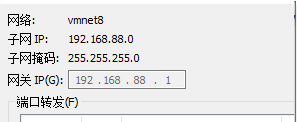

hadoop集群的部署配置系统网络(静态)配置系统网络(静态)第一步 查看虚拟机唯一标识(MAC地址)查看虚拟机设置00:0C:29:95:6F:C4MAC地址需要详细记录(很关键)第二步 调整70-persistent-net.rules文件删除掉红色框内的内容将eth1 改为eth0(当前网卡编号)address 必须与前面的唯一标识相同,若不相同,需要将address改为和MAC相同保存退....

【大数据技术Hadoop+Spark】Flume、Kafka的简介及安装(图文解释 超详细)

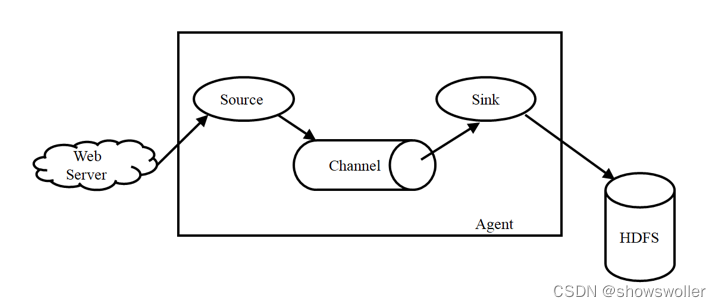

Flume简介Flume是Cloudera提供的一个高可用、高可靠、分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。Flume主要由3个重要的组件构成:1)Source:完成对日志数据的收集,分成transtion 和 event 打入到channel之中。2)Cha....

【大数据技术Hadoop+Spark】Spark SQL、DataFrame、Dataset的讲解及操作演示(图文解释)

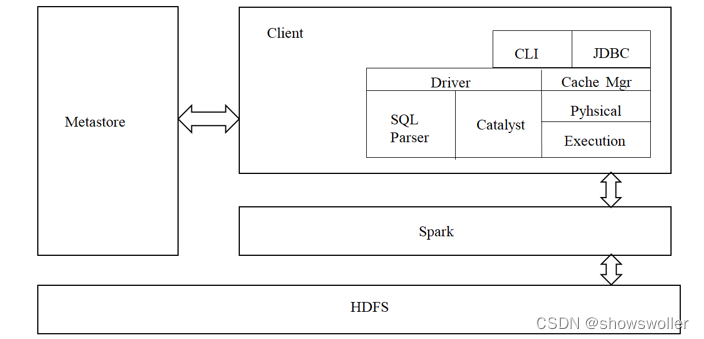

一、Spark SQL简介park SQL是spark的一个模块,主要用于进行结构化数据的SQL查询引擎,开发人员能够通过使用SQL语句,实现对结构化数据的处理,开发人员可以不了解Scala语言和Spark常用API,通过spark SQL,可以使用Spark框架提供的强大的数据分析能力。spark SQL前身为Shark。Shark是Spark上的数据仓库,最初设计成与Hive兼容,但是该项目....

【大数据技术Hadoop+Spark】Spark RDD创建、操作及词频统计、倒排索引实战(超详细 附源码)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~一、RDD的创建Spark可以从Hadoop支持的任何存储源中加载数据去创建RDD,包括本地文件系统和HDFS等文件系统。我们通过Spark中的SparkContext对象调用textFile()方法加载数据创建RDD。1、从文件系统加载数据创建RDD从运行结果反馈的信息可以看出,wordfile是一个String类型的RDD,或者以后可以简单....

【大数据技术Hadoop+Spark】Spark RDD设计、运行原理、运行流程、容错机制讲解(图文解释)

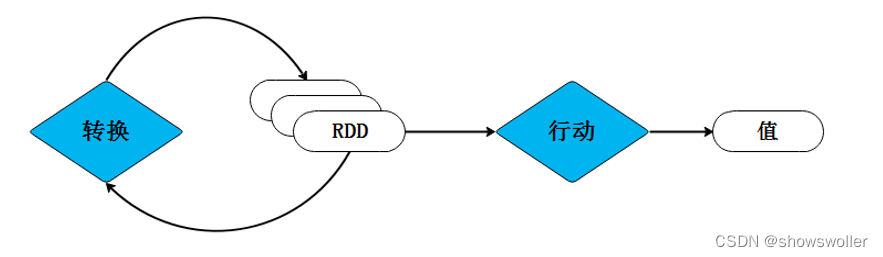

一、RDD的概念RDD(Resilient Distributed Dataset),即弹性分布式数据集,是一个容错的、并行的数据结构,可以让用户显式地将数据存储到磁盘和内存中,并且还能控制数据的分区。不同RDD之间可以通过转换操作形成依赖关系实现管道化,从而避免了中间结果的I/O操作,提高数据处理的速度和性能。一个RDD就是一个分布式对象集合,本质上是一个只读的分区记录集合,每个RDD可以分成....

【大数据技术Hadoop+Spark】Spark架构、原理、优势、生态系统等讲解(图文解释)

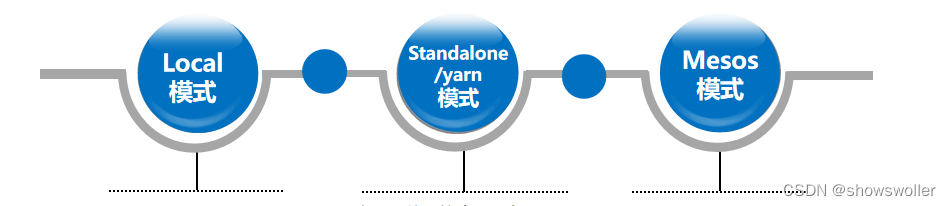

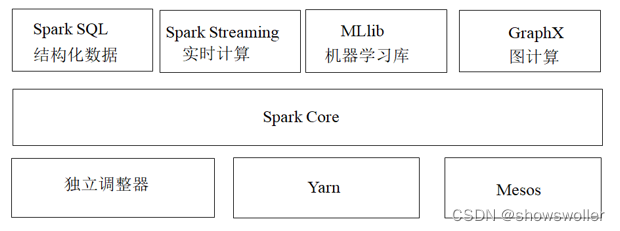

一、Spark概述Spark最初由美国加州伯克利大学(UCBerkeley)的AMP(Algorithms, Machines and People)实验室于2009年开发,是基于内存计算的大数据并行计算框架,可用于构建大型的、低延迟的数据分析应用程序。Spark在诞生之初属于研究性项目,其诸多核心理念均源自学术研究论文。2013年,Spark加入Apache孵化器项目后,开始获得迅猛的发展,如....

【大数据技术Hadoop+Spark】HBase数据模型、Shell操作、Java API示例程序讲解(附源码 超详细)

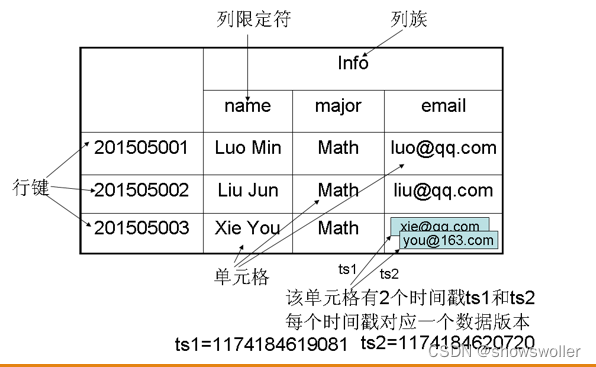

一、HBase数据模型HBase分布式数据库的数据存储在行列式的表格中,它是一个多维度的映射模型,其数据模型如下所示。表的索引是行键,列族,列限定符和时间戳,表在水平方向由一个或者多个列族组成,一个列族中可以包含任意多个列,列族支持动态扩展,可以很轻松的添加一个列族或者列,无须预先定义列的数量及数据类型,所有列均以字符串形式存储RowKey表示行键,每个HBase表中只能有一个行键,它在HBas....

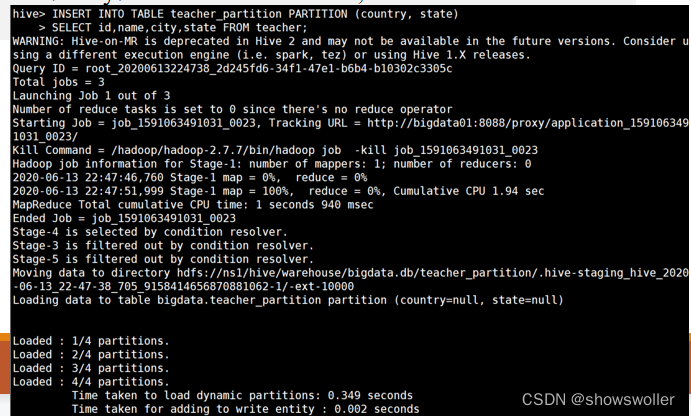

【大数据技术Hadoop+Spark】Hive基础SQL语法DDL、DML、DQL讲解及演示(附SQL语句)

Hive基础SQL语法1:DDL操作DDL是数据定义语言,与关系数据库操作相似,创建数据库CREATE DATABASE|SCHEMA [IF NOT EXISTS] database_name显示数据库SHOW databases;查看数据库详情DESC DATABASE|SCHEMA database_name切换数据库USE database_name修改数据库ALTER (DATABAS....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

hadoop大数据相关内容

- hadoop spark大数据

- hadoop spark大数据协同

- 大数据hadoop环境

- 大数据学习hadoop

- 大数据hadoop分析

- 大数据spark模式hadoop

- 大数据模式hadoop

- 大数据部署hadoop

- 大数据hadoop mapreduce

- 大数据hadoop yarn

- 大数据hadoop节点

- 大数据hadoop笔记

- 大数据hadoop分发

- 大数据hadoop配置

- 大数据环境搭建hadoop

- 大数据组件hadoop

- hadoop入门大数据

- hadoop构建大数据分析

- hadoop概述大数据

- hadoop构建大数据

- hadoop系统大数据

- 大数据hadoop spark

- 大数据maxcompute hadoop

- 阿里巴巴大数据hadoop系统

- 大数据hadoop系统

- 大数据hadoop安装

- 大数据hadoop集成

- 大数据java hadoop

- hadoop大数据工具

- 大数据技术hadoop

hadoop更多大数据相关

- 大数据hadoop集群搭建

- hadoop系统大数据技术

- hadoop大数据入门

- 大数据hadoop伪分布

- 大数据hadoop安装教程

- 大数据hadoop教程

- 大数据hadoop入门

- 大数据hadoop简介

- 大数据hadoop mapreduce编程

- 大数据hadoop实践

- 大数据开发hadoop

- 大数据hadoop编程

- 大数据面试hadoop

- 大数据hadoop分布式

- 大数据实战hadoop

- 大数据hadoop开发

- 大数据实践hadoop

- 大数据hadoop应用

- 大数据面试题百日hadoop

- 大数据hadoop原理

- 大数据开发hadoop安装

- 大数据hadoop hive

- hadoop分布式大数据

- 大数据hadoop部署

- 大数据hadoop hbase

- 大数据hadoop运行

- 大数据hadoop技术

- 大数据框架hadoop

- 大数据环境hadoop

- 大数据hadoop命令

hadoop您可能感兴趣

- hadoop入门

- hadoop系统

- hadoop spark

- hadoop技术

- hadoop集群管理

- hadoop架构

- hadoop hdfs

- hadoop数据

- hadoop技术选型

- hadoop分布式

- hadoop集群

- hadoop安装

- hadoop配置

- hadoop mapreduce

- hadoop文件

- hadoop学习

- hadoop yarn

- hadoop hive

- hadoop命令

- hadoop运行

- hadoop节点

- hadoop搭建

- hadoop hbase

- hadoop部署

- hadoop报错

- hadoop实战

- hadoop概念

- hadoop启动

- hadoop操作

- hadoop apache