我现在在pytorch上训练了一个bert模型,请问用什么方法可以尽快在函数计算上部署并引出接口捏?

我现在在pytorch上训练了一个bert模型,请问用什么方法可以尽快在函数计算上部署并引出接口捏?(我docker遇到点问题,一直在starting)

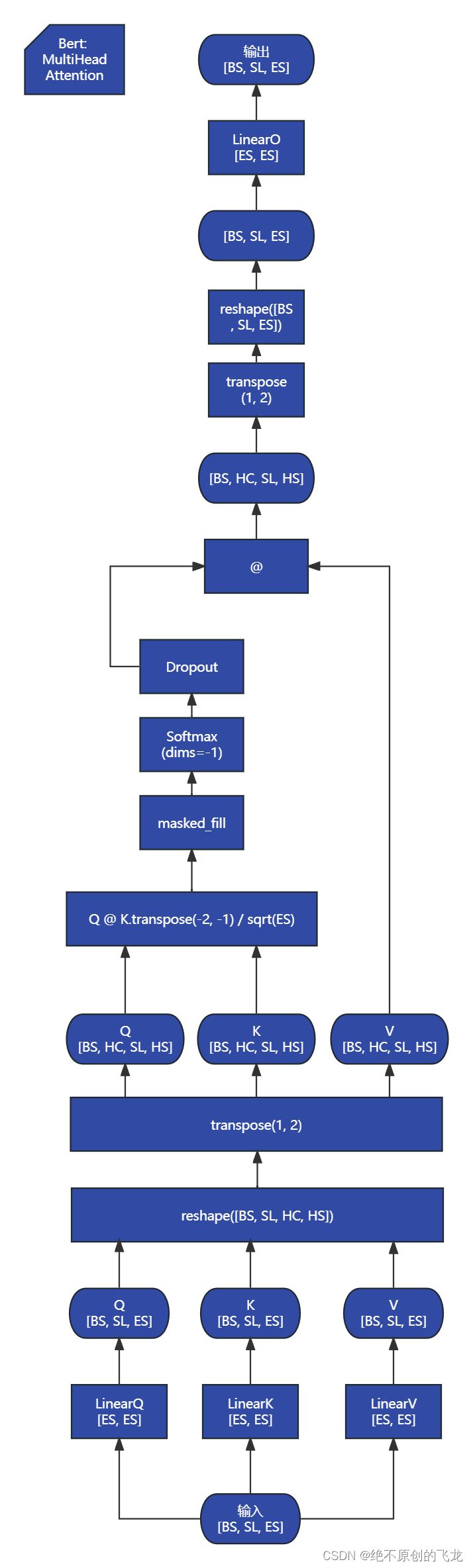

Bert Pytorch 源码分析:五、模型架构简图

注意力层:输入 -> LLQ -> @ -> /√ES -> softmax -> @ -> LLO -> Dropout -> 输出 | ↑ ↑ +---> LLK ---+ | | ...

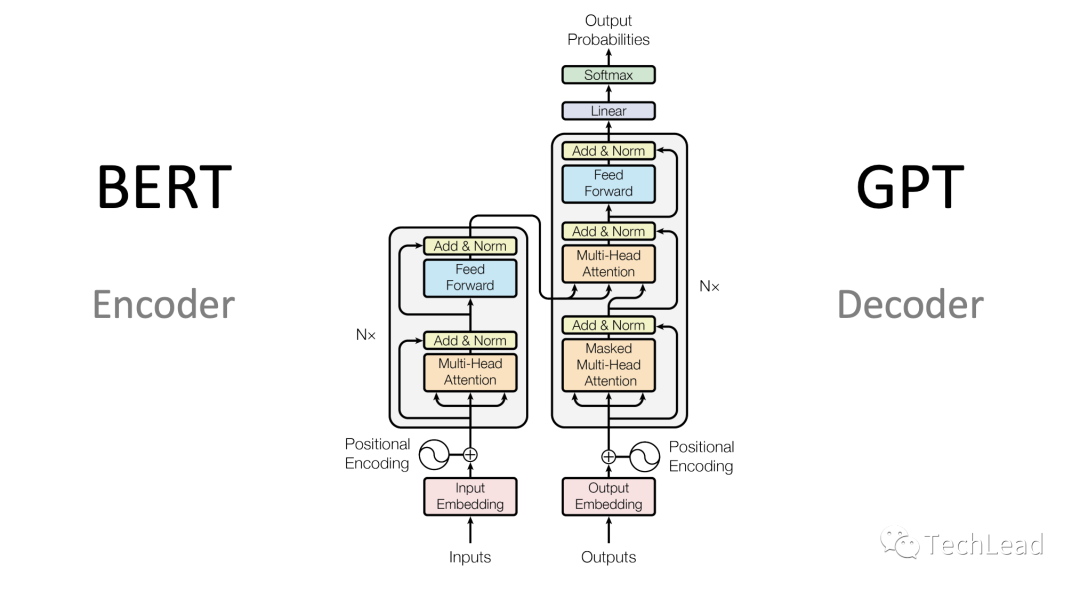

Bert Pytorch 源码分析:四、编解码器

# Bert 编码器模块 # 由一个嵌入层和 NL 个 TF 层组成 class BERT(nn.Module): """ BERT model : Bidirectional Encoder Representations from Transformers. """ def __init__(self, vocab_size, hidden=768, n_la...

Bert Pytorch 源码分析:三、Transformer块

# PFF 层,基本相当于两个全连接 # 每个 TF 块中位于注意力层之后 class PositionwiseFeedForward(nn.Module): "Implements FFN equation." def __init__(self, d_model, d_ff, dropout=0.1): super(PositionwiseFeedForwar...

Bert Pytorch 源码分析:二、注意力层

# 注意力机制的具体模块 # 兼容单头和多头 class Attention(nn.Module): """ Compute 'Scaled Dot Product Attention """ # QKV 尺寸都是 BS * ML * ES # (或者多头情况下是 BS * HC * ML * HS,最后两维之外的维度不重要) # 从输入计算 QKV 的过程可...

Bert PyTorch 源码分析:一、嵌入层

# 标记嵌入就是最普通的嵌入层 # 接受单词ID输出单词向量 # 直接转发给了`nn.Embedding` class TokenEmbedding(nn.Embedding): def __init__(self, vocab_size, embed_size=512): super().__init__(vocab_size, embed_size, padding_...

深度解析BERT:从理论到Pytorch实战

本文从BERT的基本概念和架构开始,详细讲解了其预训练和微调机制,并通过Python和PyTorch代码示例展示了如何在实际应用中使用这一模型。我们探讨了BERT的核心特点,包括其强大的注意力机制和与其他Transformer架构的差异。关注TechLead,分享AI全维度知识。作者拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,同济本复旦硕,复旦机器人智能实验室成员,阿里云认证的资....

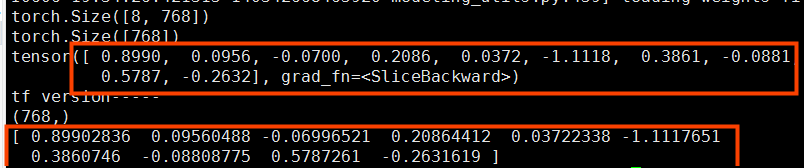

使用BERT对句子进行向量化(TensorFlow版和Pytorch版)

更多、更及时内容欢迎留意微信公众号: 小窗幽记机器学习 背景 用BERT对句子进行向量化 实施 TensorFlow版直接用肖涵博士的bert-as-service。使用方法真的很小白,简单概括为2点:server和client安装。 pip install bert-serving-server # server pip install bert-serving-client ...

【Pytorch神经网络实战案例】33 使用BERT模型实现完形填空任务

1 案例描述案例:加载Transformers库中的BERT模型,并用它实现完形填空任务,即预测一个句子中缺失的单词。2 代码实现:使用BERT模型实现完形填空任务2.1 代码实现:载入词表,并对输入的文本进行分词转化---BERT_MASK.py(第1部分)import torch from transformers import BertTokenizer, BertForMaskedLM ....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。