flink 读取oss-hdfs数据问题

Flink 尝试从 OSS 获取分区信息时,由于权限不足导致访问被拒绝。但是注意到这里的endpoint实际上是oss的endpoint,但是我的数据存储在oss-hdfs中,请问我该如何访问到oss-hdfs中的数据?已经在配置文件中设置fs.oss.jindo.endpoint: cn-beijing.oss-dls.aliyuncs.com

实时计算 Flink版产品使用合集之写入OSS是否要开通oss-hdfs服务

问题一:Flink cdc支持实时同步oracle数据到starrocks么? Flink cdc支持实时同步oracle数据到starrocks么? 参考答案: 实时计算Flink版未提供官方内置Oracle CDC Connector,如需使用,可以通过管理自定义Connectors来实现,您需要根据社区定义的连接器标准开发您自定义的连接器,才能正...

实时计算Flink读写OSS或者OSS-HDFS

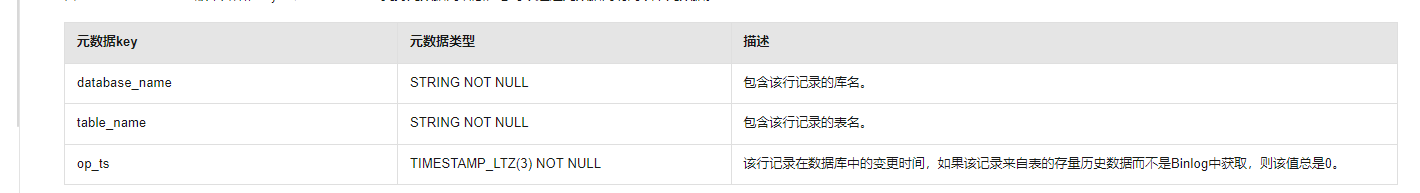

阿里云实时计算Flink支持通过连接器读写OSS以及OSS-HDFS数据。通过配置OSS或者OSS-HDFS连接器的输入属性,实时计算Flink会自动从指定的路径读取数据,并将其作为实时计算Flink的输入流,然后将计算结果按照指定格式写入到OSS或者OSS-HDFS的指定路径。

Flink当前可以直接在 vvp 上创建存储在 oss-hdfs 的 paimon 表么?

Flink当前可以直接在 vvp 上创建存储在 oss-hdfs 的 paimon 表么?

在Flink这个oss key 可以正常访问 hudi的 oss-hdfs,但这里就报错了,为什么?

在Flink这个oss key 可以正常访问 hudi的 oss-hdfs,但这里就报错了,为什么?

阿里云全托管flink-vvp平台hudi connector实践(基于emr集群oss-hdfs存储)

1. 上游数据准备上游数据以mysql为例作为hudi入湖的上游应用表,详细的建表、插入及更新语句如下droptable if exists `sunyf_db`.`flink_test_02_hudi`;createtable if not EXISTS `sunyf_db`.`flink_test_02_hudi`( id BIGINTnotnull PRIMARY KEY ,`name...

Flink里打包好的jar包上传运行,checkpoint在代码里可以设置oss-hdfs的地址么?

Flink里打包好的 jar 包上传运行,checkpoint 在代码里可以设置到 oss-hdfs 的地址么?

如果使用Jindo OSS-HDFS 作为底层存储 Flink这边需要做什么工作吗 ?

在非EMR集群 如果使用Jindo OSS-HDFS 作为Flink Checkpoint 保存的底层存储 Flink这边需要做什么工作吗 ?(运行在阿里云ACK上)

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版湖仓

- 实时计算 Flink版doris

- 实时计算 Flink版解决方案

- 实时计算 Flink版oracle

- 实时计算 Flink版实时同步

- 实时计算 Flink版数据

- 实时计算 Flink版CDC

- 实时计算 Flink版数据处理

- 实时计算 Flink版hive3.1.3

- 实时计算 Flink版mysql

- 实时计算 Flink版SQL

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版flink

- 实时计算 Flink版实时计算

- 实时计算 Flink版版本

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行

- 实时计算 Flink版连接

- 实时计算 Flink版checkpoint

- 实时计算 Flink版库

实时计算 Flink

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

+关注