如何使用LLM智能问答版SDK推送非结构化文档

Push 推送数据方式,主要是预先生成符合我们规定格式的待推送数据集合,最后在调用Push方法时,将这些数据集合一次性批量推送到应用中。

可控细节的长文档摘要,探索开源LLM工具与实践

本文的想法来自今年OpenAI cookbook的一篇实践:summarizing_long_documents,目标是演示如何以可控的细节程度总结大型文档。 如果我们想让大语言模型总结一份长文档(例如 10k 或更多tokens),但是直接输入大语言模型往往会得到一个相对较短的摘要,该摘要与文档的长度并不成比例。例如,20k tokens的文档的摘要不会是 10k toke...

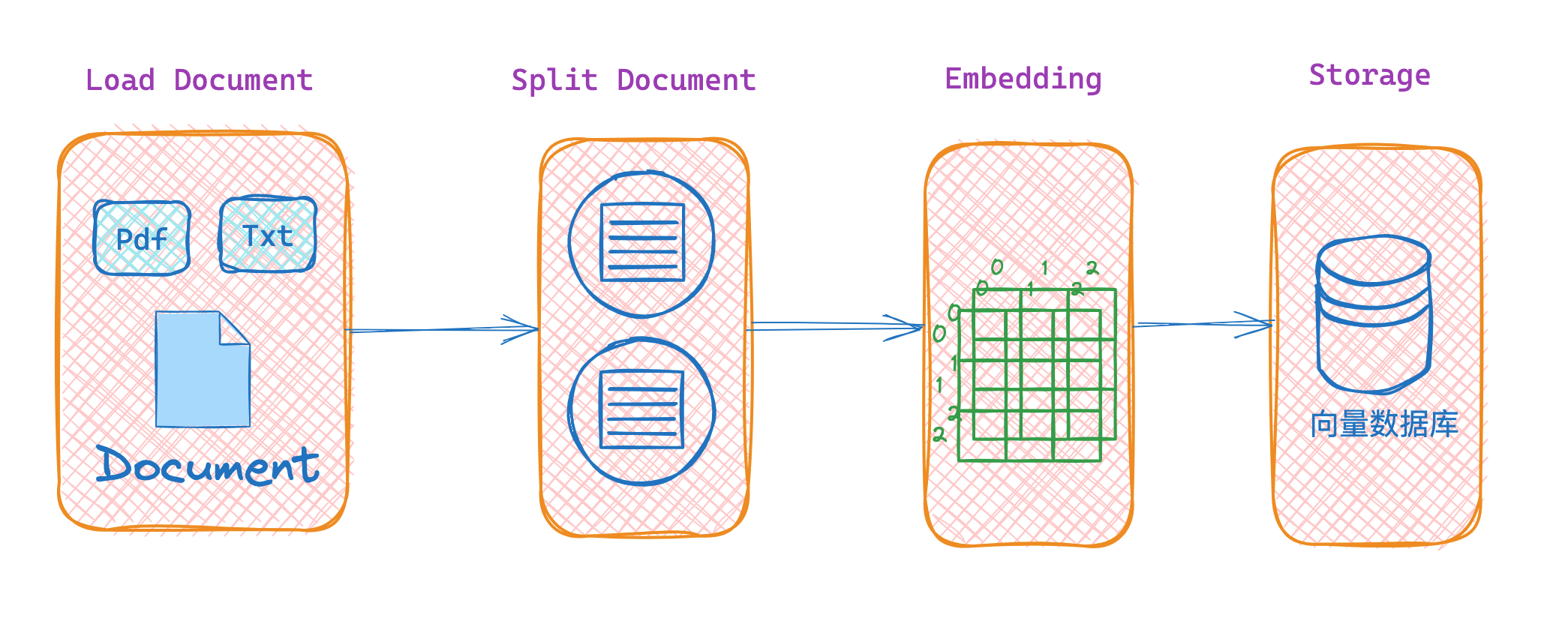

LangChain结合LLM做私有化文档搜索

我们知道LLM(大语言模型)的底模是基于已经过期的公开数据训练出来的,对于新的知识或者私有化的数据LLM一般无法作答,此时LLM会出现“幻觉”。针对“幻觉”问题,一般的解决方案是采用RAG做检索增强。 但是我们不可能把所有数据都丢给LLM去学习,比如某个公司积累的某个行业的大量内部知识。此时就需要一个私有化的文档搜索工具了。 本文聊聊如何使用LangChain结合LLM快速做一个私有化的文档...

有关于 ModelScope llm的用验证集和测试集评估微调后模型的文档吗?

有关于 ModelScope llm的用验证集和测试集评估微调后模型的文档吗?

ModelScope中这是在哪里改呢?

在ModelScope中,我已根据LLM微调文档准备好环境,接下来应该如何使用数据集进行训练并将结果推送到我的model_id库中?具体应该在哪里进行配置和操作呢?

OpenSearch LLM智能问答现在有直接 前端js 直接调用的RESTful 文档或者例子么?

OpenSearch LLM智能问答现在有直接 前端js 直接调用的RESTful 文档或者例子么? AccessToken那种,比如语音这种:对话chat功能,有些业务不需要后台中转。只是最后结果可能需要保存下,因为现在 LLM 响应有时很慢 。

OpenSearch LLM智能问答非结构化文档推送的大小有限制吗?

OpenSearch LLM智能问答非结构化文档推送的大小有限制吗?我推送一个3.7M的pdf文档,报Did not receive successful HTTP response: status code = 413, status message = Request Entity Too LargeOpenSearchException(code:1000, message:HttpRes....

OpenSearch LLM智能问答系统集成的时候,只能我们自己先拆分文档?

OpenSearch LLM智能问答系统集成的时候,只能我们自己先拆分文档?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。