Kafka 如何保证数据不丢失

Kafka通过以下机制来保证消息不丢失:1. 持久化:Kafka将所有消息持久化到磁盘上,以防止数据丢失。每个消息都会被追加到日志文件中,并且写入操作返回成功后才被视为已提交。2. 内存缓冲区:Kafka使用内存缓冲区来临时存储待写入磁盘的消息。这些缓冲区可以被批量写入,以提高磁盘写入效率。3. 复制机制:Kaf....

kafka如何最大限度的保证数据不丢失

kafka如何最大限度的保证数据不丢失Producer端1. 调用方式(1)网络抖动导致消息丢失,Producer 端可以进行重试。(2)消息大小不合格,可以进行适当调整,符合 Broker 承受范围再发送。2. ACK 确认机制将 request.required.acks 设置为 -1/ all3. 重试次数 retriesretries = Integer.MAX_VALUEmax.in.....

Kafka如何保证数据的可靠性&Kafka集群

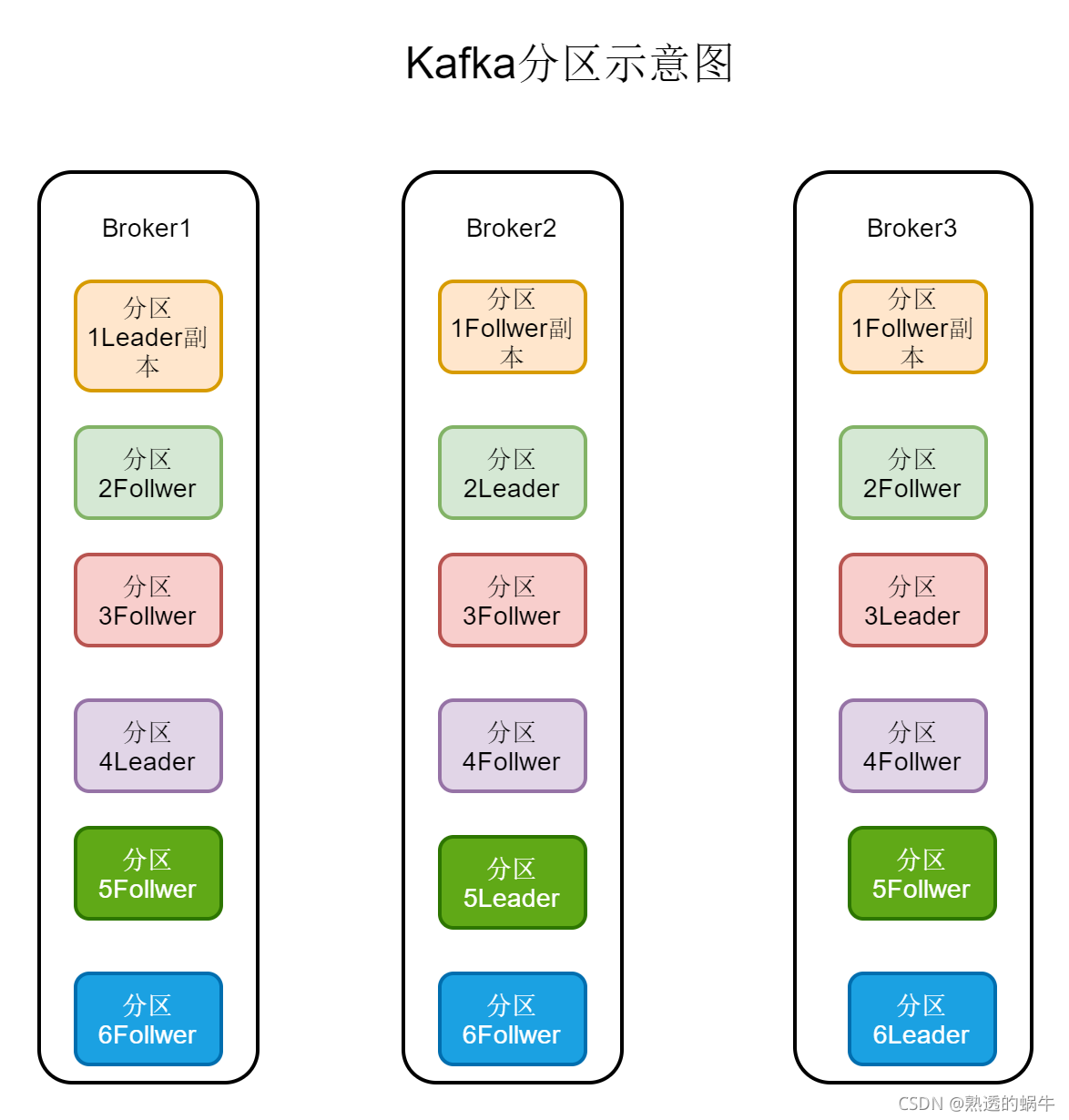

正文一、Kafka数据存储方式 名词解释Broker:Kafka节点,一个Kafka节点就是一个broker,多个broker可以组成一个Kafka集群Topic:一类消息,消息存放的目录即主题,例如page view日志、click日志等都可以以topic的形式存在,Kafka集群能够同时负责多个topic的分发message: Kafka中最基本的传递对象。Partition:topic物理....

Kafka SparkStreaming 保证数据不丢失问题 >0.10版本

sparkstreaming 处理kafka数据,几种数据丢失的情况,1、雪崩效应导致的异常 kill掉进程 ,导致数据丢失2、程序bug 导致进程挂了,导致数据丢失以上是使用自动提交offset会存在的问题,若要保证数据0丢失,需要使用offset commit api手动提交offset,自己保存offset,自己提交处理完的offset。http://spark.apache.org/...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版平台

- 云消息队列 Kafka 版分析

- 云消息队列 Kafka 版分布式

- 云消息队列 Kafka 版实战

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版常见问题

- 云消息队列 Kafka 版rabbitmq

- 云消息队列 Kafka 版mq

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版serverless

- 云消息队列 Kafka 版数据

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版日志

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析