创建Hive Catalog

配置Hive Catalog后,您可以在Flink开发控制台直接读取Hive元数据,无需再手动注册Hive表,提高作业开发的效率且保证数据的正确性。本文为您介绍如何配置Hive元数据、创建和使用Hive Catalog等。

实时计算 Flink版创建hivecatalog报org.apache.有遇到的吗?

实时计算 Flink版创建hivecatalog报org.apache.flink.table.catalog.exceptions.CatalogException: Configured default database default doesn't exist in catalog myhive.hive2.3.9 flink1.16.0?刚开始用hive3.1.3是可以的,有遇到...

请问如果Flink sql使用hiveCatalog,FlinkSQL能用hive的udf吗?

请问如果Flink sql使用hiveCatalog,FlinkSQL能用hive的udf吗?

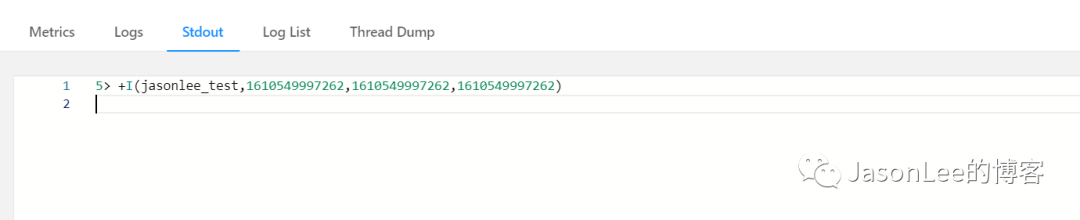

Flink SQL 结合 HiveCatalog 使用

Flink 支持 HiveCatalog 作为表元数据持久化的介质,在生产环境我们一般采用 HiveCatalog 来管理元数据, 这样的好处是不需要重复使用 DDL 创建表,只需要关心业务逻辑的 SQL,简化了开发的流程,可以节省很多时间,下面就来介绍一下怎么配置和使用 HiveCatalog.sql-client-defaults.yaml 配置catalogs: - name: my...

Flink1.14.2连接Hive,初始化Hivecatalog失败

使用Flink连接Hive的时候一直报错,java.lang.NoSuchMethodError: com.google.common.base.Preconditions.checkArgument(ZLjava/lang/String;Ljava/lang/Object;)V 尝试更换版本,更换com.google.guava版本,使用的代码是官网案例 org.apach...

我用hivecatalog建了张kafka的source表,那么我有两个job都需要从这#Flink

我用hivecatalog建了张kafka的source表,那么我有两个job都需要从这张source表取数据写到不同的 数据库,那么怎么保证group.id 不同的啊 #Flink

Flink 1.10 SQL、HiveCatalog 与事件时间整合示例

Flink 1.10 与 1.9 相比又是个创新版本,在我们感兴趣的很多方面都有改进,特别是 Flink SQL。本文用根据埋点日志计算 PV、UV 的简单示例来体验 Flink 1.10 的两个重要新特性: 一是 SQL DDL 对事件时间的支持;二是 Hive Metastore 作为 Flink 的元数据存储(即 HiveCatalog)。 这两点将会为我们构建实时数仓提供很大的便利。 添....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版hivecatalog相关内容

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版银行

- 实时计算 Flink版实战

- 实时计算 Flink版案例

- 实时计算 Flink版CEP

- 实时计算 Flink版云上

- 实时计算 Flink版批计算

- 实时计算 Flink版增量

- 实时计算 Flink版构建

- 实时计算 Flink版最佳实践

- 实时计算 Flink版数仓

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版实时计算

- 实时计算 Flink版flink

- 实时计算 Flink版版本

- 实时计算 Flink版oracle

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

实时计算 Flink

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

+关注