图像分类经典神经网络大总结(AlexNet、VGG 、GoogLeNet 、ResNet、 DenseNet、SENet、ResNeXt )

前言在CNN网络结构的演化上,出现过许多优秀的CNN网络,CNN的经典结构始于1998年的LeNet,成于2012年历史性的AlexNet,从此盛于图像相关领域。发展历史:Lenet --> Alexnet --> ZFnet --> VGG --> NIN --> GoogLeNet -->ResNet--> DenseNet -->ResNeX....

全新池化方法AdaPool | 让ResNet、DenseNet、ResNeXt等在所有下游任务轻松涨点(二)

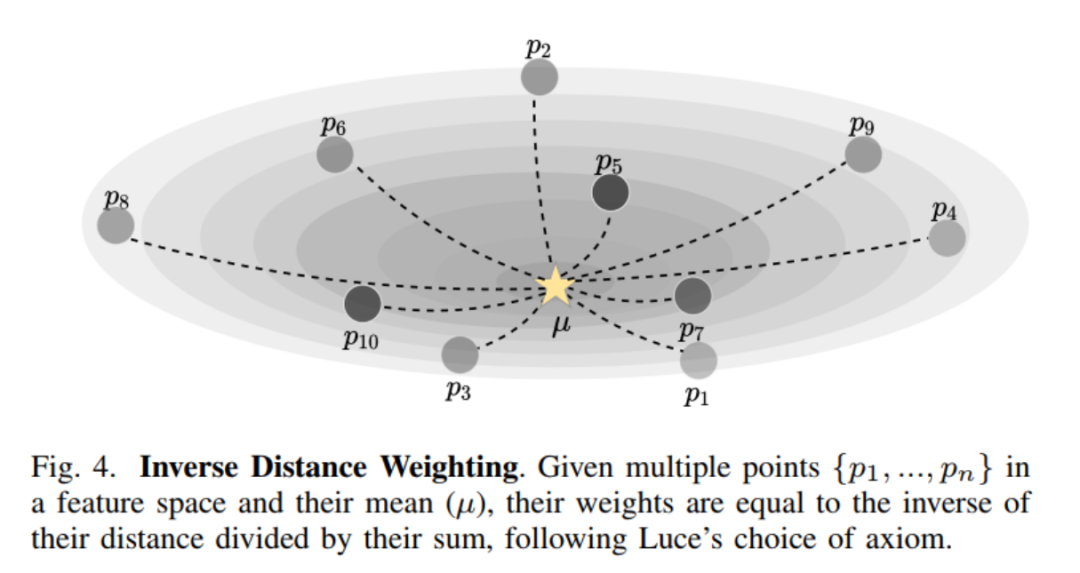

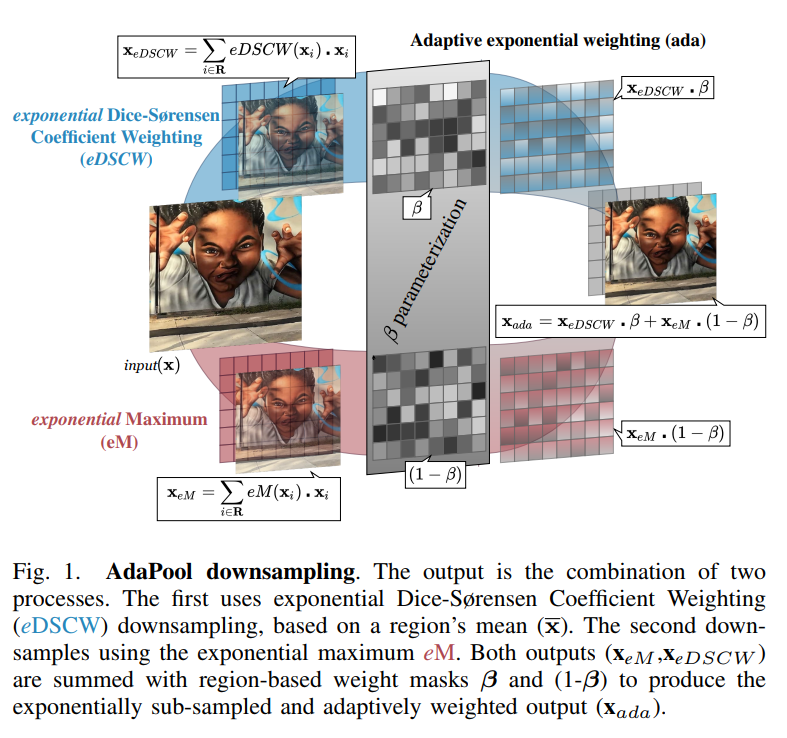

3本文方法 AdaPool这里首先介绍在池化方法中共享的操作。在一个大小为C×H×W的激活映射 中定义了局部 kernel 区域 R,其中包含C个通道,高度为H,宽度为W。为了简化表示法,省略通道维数,并假设R是尺寸为k × k的二维空间区域中激活的相对位置指标集合(即激活)。将池化输出表示为 ,对应的梯度表示为 ,其中为R区域内的坐标集。A. Inverse Distance We....

全新池化方法AdaPool | 让ResNet、DenseNet、ResNeXt等在所有下游任务轻松涨点(一)

1简介池化方法将空间输入采样到更低的分辨率。目标是通过捕捉最重要的信息和保留结构方面,如对比度和纹理,最大限度地减少信息的损失。池化操作在图像和视频处理方法中是必不可少的,包括那些基于卷积神经网络的方法。在cnn中,池化操作有助于减少计算负担,同时增加较深部分卷积的感受野。池化实际上就是所有流行的CNN架构中的一个关键组件,它们具有较低的计算和内存开销。已经提出的一系列的池化方法,每一种方法都有....

【Pytorch神经网络理论篇】 31 图片分类模型:ResNet模型+DenseNet模型+EffcientNet模型

同学你好!本文章于2021年末编写,获得广泛的好评!故在2022年末对本系列进行填充与更新,欢迎大家订阅最新的专栏,获取基于Pytorch1.10版本的理论代码(2023版)实现,Pytorch深度学习·理论篇(2023版)目录地址为:CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(2023版)目录本专栏将通过系统的深度学习实例,从可解释性的角度对深度学习的原理进行讲解与分析,通....

为什么ResNet和DenseNet可以这么深?一文详解残差块为何有助于解决梯度弥散问题。

传统的“提拉米苏”式卷积神经网络模型,都以层叠卷积层的方式提高网络深度,从而提高识别精度。但层叠过多的卷积层会出现一个问题,就是梯度弥散(Vanishing),backprop无法有效地把梯度更新到前面的网络层,导致前面的层参数无法更新。 而BatchNormalization(BN)、ResNet的skip connection就是为了解决这个问题,BN通过规范化输入数据改变数据分布,在前传过....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

ResNet densenet相关内容

ResNet您可能感兴趣

- ResNet模型

- ResNet图像

- ResNet分类

- ResNet networks

- ResNet resnet

- ResNet深度学习

- ResNet应用

- ResNet原理

- ResNet网络

- ResNet图像识别

- ResNet pytorch

- ResNet论文

- ResNet训练

- ResNet入门

- ResNet图像分类

- ResNet神经网络

- ResNet结构

- ResNet数据集

- ResNet mobilenet

- ResNet部署

- ResNet复现

- ResNet任务

- ResNet优化

- ResNet算法

- ResNet vit

- ResNet参数

- ResNet块

- ResNet机器学习

- ResNet代码

- ResNet简介