通过Apache Airflow提交任务

Apache Airflow是一个强大的工作流程自动化和调度工具,它允许开发者编排、计划和监控数据管道的执行。EMR Serverless Spark为处理大规模数据处理任务提供了一个无服务器计算环境。本文为您介绍如何通过Apache Airflow实现自动化地向EMR Serverless Spark提交任务,以实现作业调度和执行的自动化,帮助您更有效地管理数据处理任务。

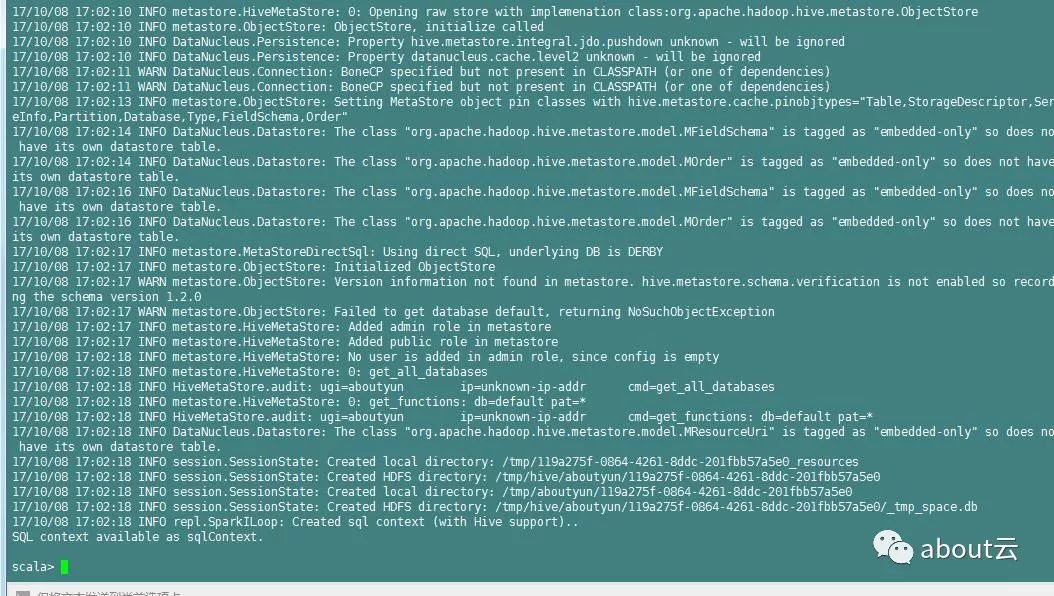

日志分析实战之清洗日志小实例1:使用spark&Scala分析Apache日志

about云日志分析,那么过滤清洗日志。该如何实现。这里参考国外的一篇文章,总结分享给大家。使用spark分析网站访问日志,日志文件包含数十亿行。现在开始研究spark使用,他是如何工作的。几年前使用hadoop,后来发现spark也是容易的。下面是需要注意的: 如果你已经知道如何使用spark并想知道如何处理spark访问日志记录,我写了这篇短的文章,介绍如何从Apache访问日志文...

Spark-再次分析Apache访问日志

分析日志的包 自己编译下: sbt compile sbt test sbt package ApacheLogParser.jar 对于访问日志简单分析grep等利器比较好,但是更复杂的查询就需要Spark了。 代码: import com.alvinalexander.accesslogparser._ val p = new AccessLogParser val log =...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache sparkapache相关内容

- 大数据apache apache spark

- apache apache spark

- apache apache spark streaming

- apache hudi apache spark

- storm apache spark apache内容

- apache apache spark作用是什么

- Apache apache spark机器学习

- pandas apache apache spark

- 切换apache apache spark

- monitoring apache apache spark面临

- apache spark Hadoop大数据Apache概述

- Hadoop大数据Apache apache spark

apache spark您可能感兴趣

- apache spark技术

- apache spark大数据

- apache spark优先级

- apache spark batch

- apache spark客户端

- apache spark任务

- apache spark调度

- apache spark yarn

- apache spark作业

- apache spark Hive

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Hadoop

- apache spark rdd

- apache spark MaxCompute

- apache spark集群

- apache spark运行

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark机器学习

- apache spark应用

- apache spark实战

- apache spark操作

- apache spark程序

- apache spark报错

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注