大数据-77 Kafka 高级特性-稳定性-延时队列、重试队列 概念学习 JavaAPI实现(一)

点一下关注吧!!!非常感谢!!持续更新!!! 目前已经更新到了: Hadoop(已更完) HDFS(已更完) MapReduce(已更完) Hive(已更完) Flume(已更完) Sqoop(已更完) Zookeeper(已更完) HBase(已更完) Redis (已更完) Kafka(正在更新…) ...

大数据-77 Kafka 高级特性-稳定性-延时队列、重试队列 概念学习 JavaAPI实现(二)

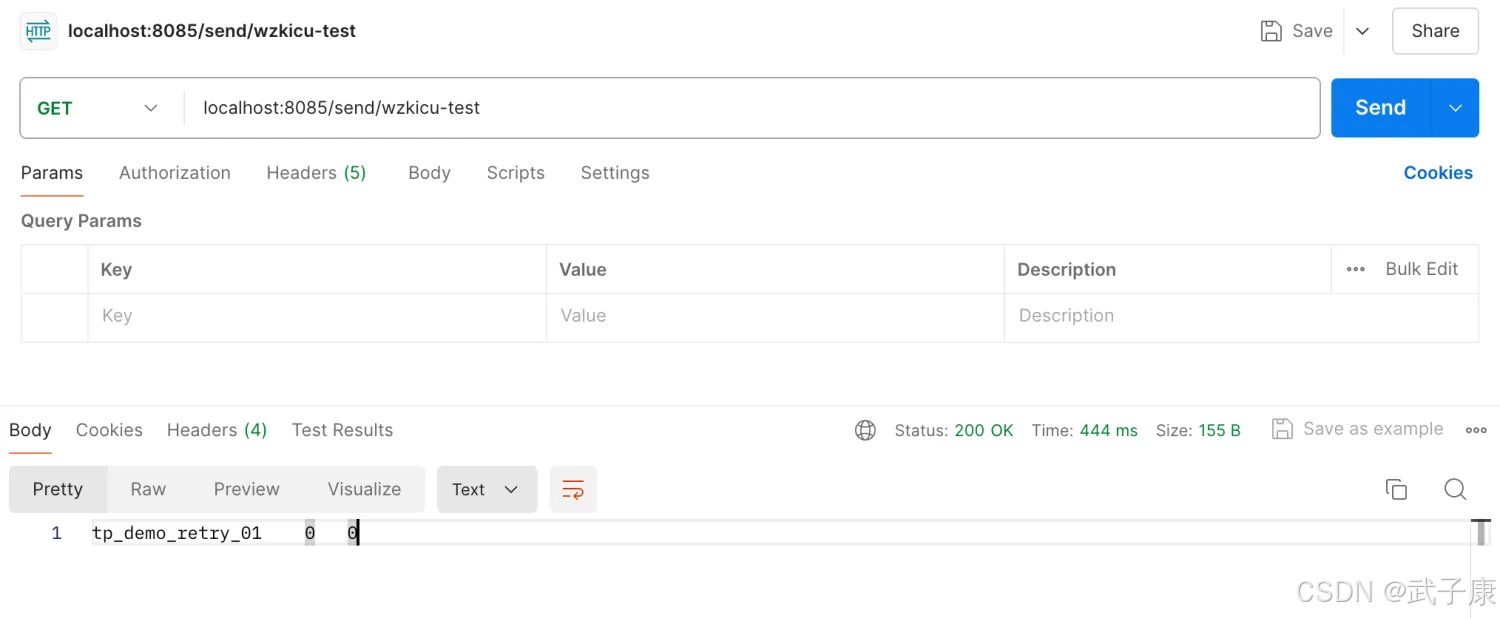

接上篇:https://developer.aliyun.com/article/1622489?spm=a2c6h.13148508.setting.18.49764f0e90XaKU KafkaService package icu.wzk.service; import...

【消息中心】kafka消费失败重试10次的问题

原理 Kafka重试的原理基于其消息重试机制。当Kafka生产者发送消息至服务端(broker)时,如果broker返回成功,则表示该消息已成功投递。然而,如果broker返回错误,生产者会根据错误类型进行处理。 可重试错误:这类错误表示可以进行重试,例如broker返回NotEnoughReplicasException异常,生产者会重发消息。 不可重试错误:这类错误表...

Apache Kafka-消费端消费重试和死信队列

概述Spring-Kafka 提供消费重试的机制。当消息消费失败的时候,Spring-Kafka 会通过消费重试机制,重新投递该消息给 Consumer ,让 Consumer 重新消费消息 。默认情况下,Spring-Kafka 达到配置的重试次数时,【每条消息的失败重试时间,由配置的时间隔决定】Consumer 如果依然消费失败 ,那么该消息就会进入到死信队列。Spring-Kafka 封装....

binlog消息过大无法正常发送到kafka的broker端时,canal 服务CPU打满并不停重试

问题如题,因为broker端显示kafka大小为1MB,所以碰到大消息时就没办法了。 错误日志如下,会不停打印 2021-05-16 23:13:18.046 [pool-6-thread-1] ERROR com.alibaba.otter.canal.kafka.CanalKafkaProducer - java.util.concurrent.ExecutionException: org....

请教下flink消费kafka后sink算了报错了然后重试了失败后依然提交了offset,这个怎么解

请教下flink消费kafka后sink算了报错了然后重试了失败后依然提交了offset,这个怎么解决啊,有没有老铁知道的。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版内存

- 云消息队列 Kafka 版磁盘

- 云消息队列 Kafka 版数据

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版云原生

- 云消息队列 Kafka 版技术

- 云消息队列 Kafka 版案例

- 云消息队列 Kafka 版rabbitmq

- 云消息队列 Kafka 版选型

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版日志

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析

- 云消息队列 Kafka 版java

云消息队列

涵盖 RocketMQ、Kafka、RabbitMQ、MQTT、轻量消息队列(原MNS) 的消息队列产品体系,全系产品 Serverless 化。RocketMQ 一站式学习:https://rocketmq.io/

+关注