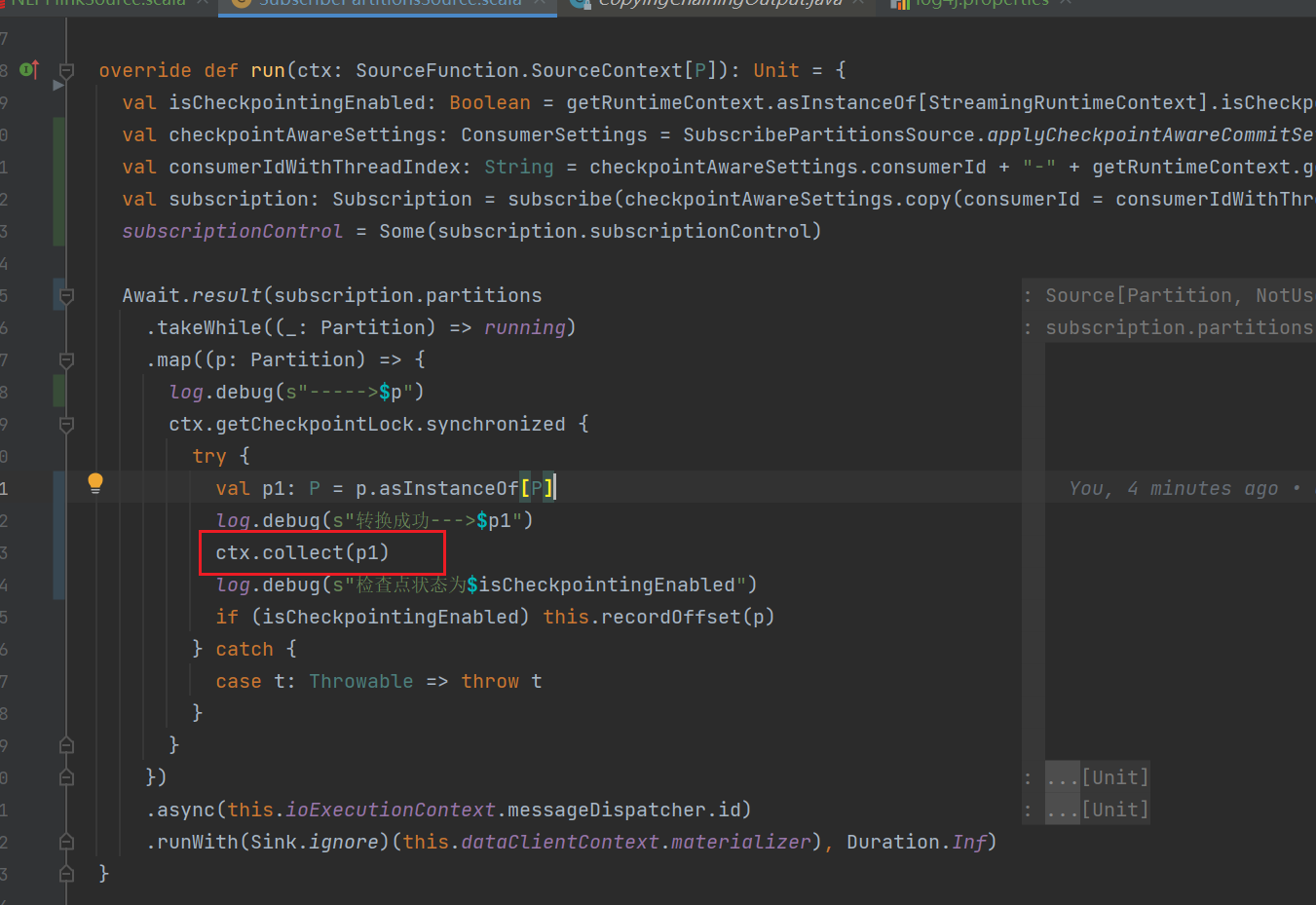

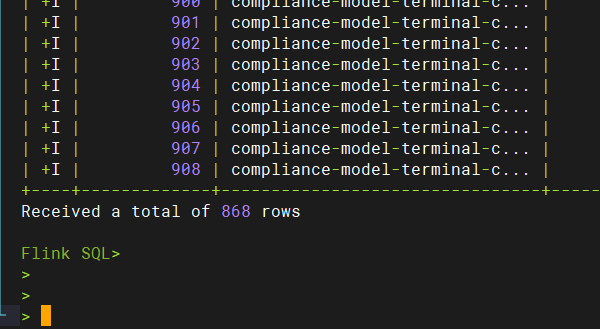

如何通过Flink CDC实时订阅AnalyticDB PostgreSQL的全量和增量数据

AnalyticDB for PostgreSQL提供自研的CDC连接器,基于PostgreSQL的逻辑复制功能实现订阅全量和增量数据,可与Flink无缝集成。该连接器能够高效捕获源表的实时变更数据,支持实时数据同步、流式处理等,助力企业快速响应动态数据需求。本文介绍如何通过阿里云实时计算Flink版CDC实时订阅AnalyticDB for PostgreSQL的全量和增量数据。

通过Flink将数据批量导入到Hologres

Hologres推出的新版Flink Connector插件,支持通过Flink将数据批量导入到Hologres,实现高效且低负载的数据导入。

如何使用Flink处理表格存储数据

本文为您介绍如何使用Flink计算表格存储(Tablestore)的数据,表格存储中的数据表或时序表均可作为实时计算Flink的源表或结果表进行使用。

清理过期数据

清理过期数据可以释放存储空间,优化资源利用并提升系统运行效率等。本文为您介绍如何清理Paimon表过期数据,包括调整快照文件过期时间、设置分区的过期时间、以及清理废弃文件。

实时计算 Flink版产品使用问题之配置了最大连续失败数不为1,在Kafka的精准一次sink中,如果ck失败了,这批数据是否会丢失

问题一:Flink如果我配置了最大连续失败数不为 1 那么如果我 ck 失败了 我这批数据会丢失吗? Flink中kafka 的精准一次 sink 如果我配置了最大连续失败数不为 1 那么如果我 ck 失败了 我这批数据会丢失吗? 参考答案: 如果你配置了最大连续失败数不为1,那么在Flink中Kafka的精准一次sink中,如果ck失败了,这批数据不...

对于Flink CDC,sink 端输出u数据?达到条数输出?达到时间输出?

对于Flink CDC,sink 端输出u数据?达到条数输出?达到时间输出?

实时计算 Flink版产品使用问题之如何确保多并发sink同时更新Redis值时,数据能按事件时间有序地更新并且保持一致性

问题一:Flink 链接mysql表 无法持续流读取,如何解决? "Flink 链接mysql表 无法持续流读取,如何解决? ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版数据相关内容

- 实时计算 Flink版实时同步oracle数据

- 实时计算 Flink版实时同步数据

- 实时计算 Flink版hive同步数据

- 实时计算 Flink版数据栈实践

- 实时计算 Flink版数据实践

- 实时计算 Flink版数据报错

- 实时计算 Flink版hdfs数据

- 实时计算 Flink版oss数据

- 实时计算 Flink版数据权限

- 实时计算 Flink版oracle数据权限

- 实时计算 Flink版同步oracle数据

- 实时计算 Flink版同步数据

- 集成实时计算 Flink版数据

- 实时计算 Flink版mysql数据变动

- 实时计算 Flink版数据变动

- 实时计算 Flink版mysql数据

- 实时计算 Flink版cdc mysql数据

- 实时计算 Flink版产品doris数据

- 实时计算 Flink版同步数据字段

- 实时计算 Flink版产品同步数据

- 实时计算 Flink版同步数据数据

- 实时计算 Flink版oracle同步数据

- 实时计算 Flink版doris数据

- 实时计算 Flink版mysql设置数据

- 实时计算 Flink版mysql字段数据

- 实时计算 Flink版设置捕获数据

- 实时计算 Flink版字段变更数据

- 实时计算 Flink版捕获变更数据

- 实时计算 Flink版mysql变更数据

- 实时计算 Flink版设置数据

实时计算 Flink版更多数据相关

- 实时计算 Flink版捕获数据

- 实时计算 Flink版字段数据

- 实时计算 Flink版变更数据

- 实时计算 Flink版数据排查

- 实时计算 Flink版数据背压

- 数据产品实时计算 Flink版

- 实时计算 Flink版方案数据

- 实时计算 Flink版kafka数据计算

- 实时计算 Flink版kafka数据

- 实时计算 Flink版抽取oracle数据

- 实时计算 Flink版产品数据

- 实时计算 Flink版全量数据

- 实时计算 Flink版任务数据

- 实时计算 Flink版增量数据

- 实时计算 Flink版采集数据

- 实时计算 Flink版同步数据库

- 实时计算 Flink版数据kafka

- 实时计算 Flink版库数据

- 实时计算 Flink版报错数据

- 实时计算 Flink版数据配置

- 实时计算 Flink版数据字段

- 实时计算 Flink版cdc sql数据

- 实时计算 Flink版数据任务

- 实时计算 Flink版数据doris

- 实时计算 Flink版数据变更

- 实时计算 Flink版数据增量

- 实时计算 Flink版sqlserver数据

- 实时计算 Flink版监听数据

- 实时计算 Flink版日志数据

- 实时计算 Flink版窗口数据

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版hashmap

- 实时计算 Flink版后端

- 实时计算 Flink版Windows

- 实时计算 Flink版rocksdb

- 实时计算 Flink版版本

- 实时计算 Flink版时空

- 实时计算 Flink版湖仓

- 实时计算 Flink版starrocks

- 实时计算 Flink版实践

- 实时计算 Flink版空间

- 实时计算 Flink版CDC

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版flink

- 实时计算 Flink版实时计算

- 实时计算 Flink版oracle

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行

- 实时计算 Flink版连接