Apache Portable Runtime which allows optimal performance in production environments was not found

一、发现问题 在启动Tomcat5.5的时候发现console中有一句话The Apache Portable Runtime which allows The optimal performance in production environments was not found on the java.library.path。这是个定语从句,翻译为:可以允许在生产环境中有最佳的表现...

Apache Kafka desrialization vulnerability via runtime

import junit.framework.Test; import junit.framework.TestCase; import junit.framework.TestSuite; import org.apache.commons.io.FileUtils; import org.apache.kafka.connect.runtime.standalone.StandaloneCo....

myeclipse如何删除Apache Tomcat v6.0 Runtime ?报错

如图,这样代码编译和运行都没有问题, ,但是,每个人的运行环境不一样,下载下来的代码就需要修改runtime server。所以我将runtime libraries下的几个重要jar包放在了项目的lib目录下,但是这样如果发布到tomcat下,会和tomcat下的servlet-api.jar、servlet-api.jar包冲突;如果直接将 runtime libraries直接删除,这样j....

Apache Flink 进阶(一):Runtime 核心机制剖析

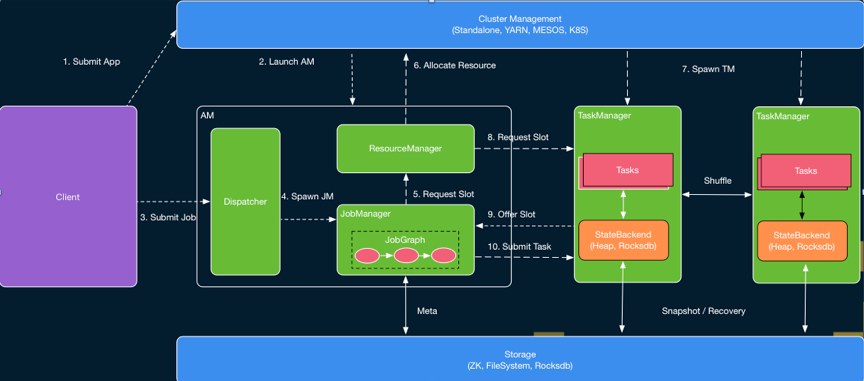

作者:高赟(云骞) 1. 综述 本文主要介绍 Flink Runtime 的作业执行的核心机制。首先介绍 Flink Runtime 的整体架构以及 Job 的基本执行流程,然后介绍在这个过程,Flink 是怎么进行资源管理、作业调度以及错误恢复的。最后,本文还将简要介绍 Flink Runtime 层当前正在进行的一些工作。 2. Flink Runtime 整体架构 Flink ...

Apache Flink vs Apache Spark——感觉二者是互相抄袭啊 看谁的好就抄过来 Flink支持在runtime中的有环数据流,这样表示机器学习算法更有效而且更有效率

Apache Flink是什么 Flink是一款新的大数据处理引擎,目标是统一不同来源的数据处理。这个目标看起来和Spark和类似。没错,Flink也在尝试解决 Spark在解决的问题。这两套系统都在尝试建立一个统一的平台可以运行批量,流式,交互式,图处理,机器学习等应用。所以,Flink和Spark的目 标差别并不大,他们最主要的区别在于实现的细节,后面我会重点从不同的角度对比这两者。 A....

使用PHP的yii框架,开启SELinux后,apache无法写入runtime目录

通过查看日志发现:type=AVC msg=audit(1440605198.077:1659): avc: denied { write } for pid=2849 comm="httpd" name="ru

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Apache runtime相关内容

Apache您可能感兴趣

- Apache meetup

- Apache阿里云

- Apache doris

- Apache日志

- Apache教程

- Apache配置

- Apache技术

- Apache数据库

- Apache php7.1

- Apache php

- Apache flink

- Apache rocketmq

- Apache安装

- Apache dubbo

- Apache tomcat

- Apache服务器

- Apache linux

- Apache spark

- Apache开发

- Apache服务

- Apache报错

- Apache mysql

- Apache微服务

- Apache访问

- Apache kafka

- Apache从入门到精通

- Apache hudi

- Apache实践

- Apache应用

- Apache web

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注