同步DataHub数据至Hologres

将DataHub数据同步至Hologres适用于需要实时数据分析、实时监控、实时报表和复杂数据结构处理的场景,通过结合DataHub和Hologres的能力,可以提升数据处理和分析的效率和准确性。本文介绍如何创建DataHub数据同步任务以及常见问题。

实时计算 Flink版产品使用问题之Flink+DataHub+Hologres相比于Flink+Hologres加入了DataHub组件,有什么优势

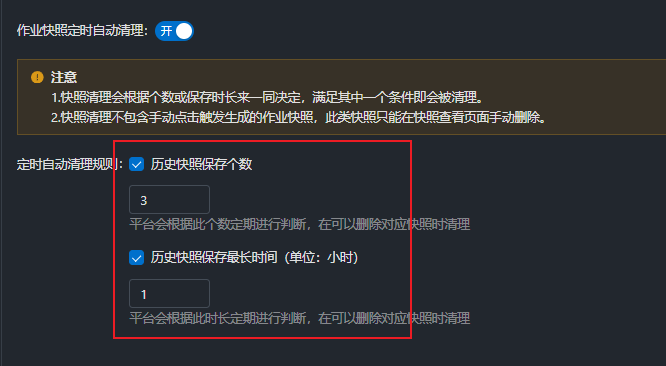

问题一:Flink这个默认的ck保存天数和保存个数是多少个? Flink这个默认的ck保存天数和保存个数是多少个? 参考答案: 这是SP哈,CK是系统检查点,SP是作业快照。 ...

实时数仓 Hologres操作报错合集之在尝试访问DataHub时,报错连接超时,该怎么处理

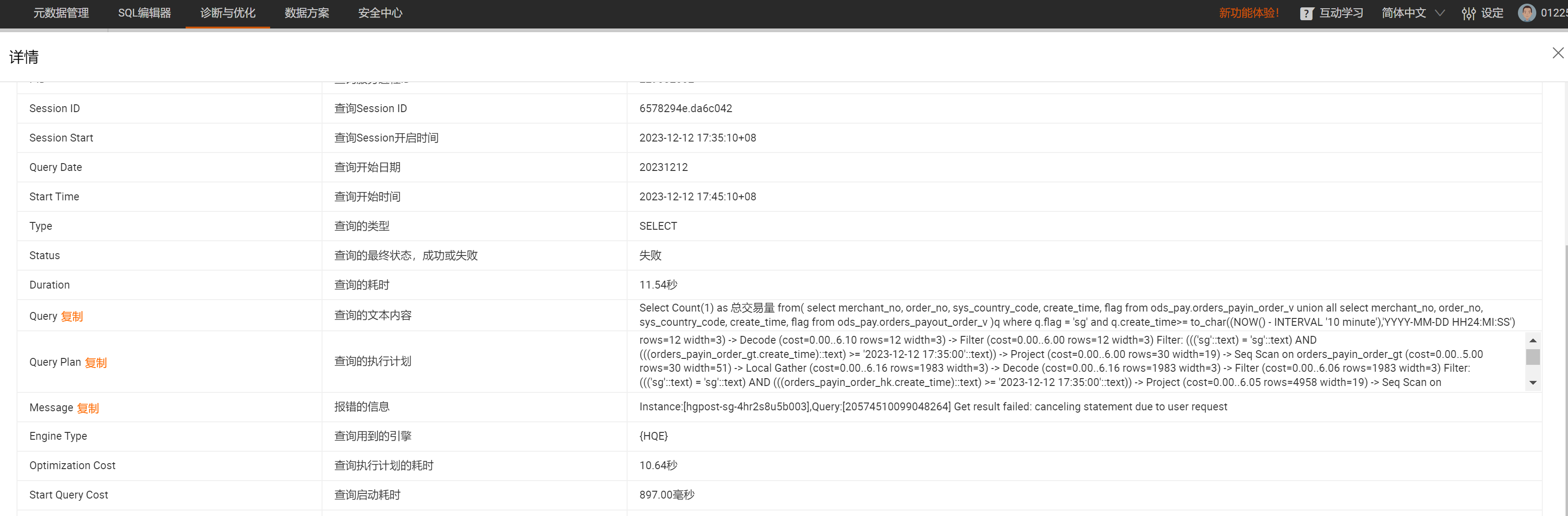

问题一:Hologres麻烦帮看下是什么原因?业务确实有这么多个表,那个定义超时时间是哪个字段喃? Hologres Instance:[hgpost-sg-4hr2s8u5b003],Query:[20574510099048264] Get result failed: canceling statement due to user request我在holo后台看到了,有时成功,有...

flink-sql1.3数据从datahub摄入时间与sink hologres的时间怎么获取?

专有云flink-sql 1.3 数据从datahub摄入时间 与 sink hologres 的时间怎么获取?

大数据计算MaxCompute在datahub中同步数据到 hologres中,可以根据主键自动覆?

大数据计算MaxCompute在datahub中同步数据到 hologres中,可以根据主键自动覆盖但同步到maxcompute中,同步后的数据是一个binglog日志形式,(增删改都会写进去)想要得到变化后最终的所有数据,还得自己再洗一遍,有没有什么方法可以实现? 从datahub同步数据到mc里,也能在历史数据的基础上自动删改更新,实现直接可用,不用再自己清洗合并 (像同步到hologre.....

hologres 支持处理datahub 脏数据 到 实时写入 es 这个链路吗?

datahub 日志数据 有一些脏数据 es无法解析 数据中带 \n 这种脏数据 需要做数据ETL,相对数据做实时清洗

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

数据总线 DataHubhologres相关内容

数据总线 DataHub您可能感兴趣

- 数据总线 DataHub集成

- 数据总线 DataHub数据

- 数据总线 DataHub java

- 数据总线 DataHub报错

- 数据总线 DataHub数据源

- 数据总线 DataHub文档

- 数据总线 DataHub topic

- 数据总线 DataHub服务

- 数据总线 DataHub flink

- 数据总线 DataHub同步

- 数据总线 DataHub dataworks

- 数据总线 DataHub mysql

- 数据总线 DataHub maxcompute

- 数据总线 DataHub rds

- 数据总线 DataHub配置

- 数据总线 DataHub实时同步

- 数据总线 DataHub kafka

- 数据总线 DataHub产品

- 数据总线 DataHub阿里云

- 数据总线 DataHub实时计算

- 数据总线 DataHub功能

- 数据总线 DataHub表

- 数据总线 DataHub类型

- 数据总线 DataHub区别

- 数据总线 DataHub sql

- 数据总线 DataHub任务

- 数据总线 DataHub操作

- 数据总线 DataHub版本

- 数据总线 DataHub odps

- 数据总线 DataHub库