如何实现K8s集群以Serverless方式使用云上CPU/GPU资源

IDC中K8s集群通过Serverless方式使用阿里云弹性容器实例ECI运行业务Pod。您可以在K8s集群直接提交业务Pod,使Pod运行在ECI上,无需额外运维云上节点池,更加灵活、高效、弹性地使用云上CPU和GPU资源。本文介绍如何基于注册集群实现IDC中K8s集群以Serverless方式使用云上CPU和GPU资源。

CPU实例和GPU实例的两种使用模式及相应的规格

函数计算的CPU实例和GPU实例均支持按量模式和预留模式。按量模式根据请求时长计费,可以结合并发度设置提高实例的资源利用率。预留模式则是从实例启动完成开始计费,到实例释放为止,可用于解决冷启动问题。本文为您介绍两类实例的实例模式、计费方式及实例规格。

CPU实例和GPU实例的两种使用模式及相应的规格

函数计算的CPU实例和GPU实例均支持按量模式和预留模式。按量模式根据请求时长计费,可以结合并发度设置提高实例的资源利用率。预留模式则是从实例启动完成开始计费,到实例释放为止,可用于解决冷启动问题。本文为您介绍两类实例的实例模式、计费方式及实例规格。

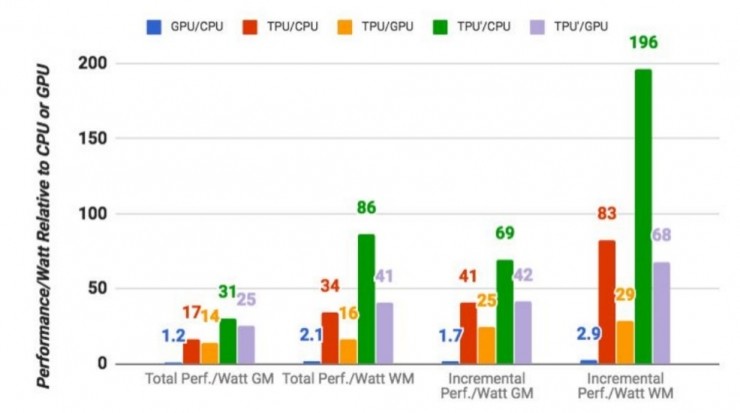

为什么 TPU 运算速度比普通的 GPU、CPU 组合快 15-30 倍?

我们找到了一些资料,希望能够解答为什么 TPU 运算速度比普通的 GPU、CPU 组合快 15-30 倍。同时,我们认为 Google 在 TPU 研发上的这些创新极有可能将成为 Intel、AMD 跟进同类硬件开发的标杆,并最终成为一种趋势。 一、针对深度学习的定制化研发 TPU 是谷歌专门为加速深层神经网络运算能力而研发的一款芯片,其实也是一款 ASIC。 ASIC,指依照产品需求不同而定.....

谷歌发论文披露TPU详细信息,比GPU、CPU快15-30倍

自从Google去年透露自己开发了一款名为TPU的专用芯片,用于提高人工智能计算任务的执行效率,关于这种新芯片的猜测就从未停止。 今天,Google终于披露了关于TPU的更多信息。除了发表一篇有75位联合作者的论文《In-Datacenter Performance Analysis of a Tensor Processing UnitTM》外,文章的第四作者David Patterson还在....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

GPU云服务器您可能感兴趣

- GPU云服务器运算

- GPU云服务器部署

- GPU云服务器模型

- GPU云服务器优惠

- GPU云服务器异构

- GPU云服务器实践

- GPU云服务器分布式

- GPU云服务器环境

- GPU云服务器集群

- GPU云服务器计算

- GPU云服务器阿里云

- GPU云服务器服务器

- GPU云服务器实例

- GPU云服务器modelscope

- GPU云服务器函数计算

- GPU云服务器nvidia

- GPU云服务器ai

- GPU云服务器性能

- GPU云服务器训练

- GPU云服务器版本

- GPU云服务器安装

- GPU云服务器推理

- GPU云服务器函数计算fc

- GPU云服务器配置

- GPU云服务器资源

- GPU云服务器深度学习

- GPU云服务器购买

- GPU云服务器价格

- GPU云服务器参数

- GPU云服务器教程