【自然语言处理NLP】Bert预训练模型、Bert上搭建CNN、LSTM模型的输入、输出详解

一、BertModel的输入和输出 from transformers import BertModel bert=BertModel.from_pretrained('bert-base-chinese') out=bert(context, attention_mask=mask)...

训练你自己的自然语言处理深度学习模型,Bert预训练模型下游任务训练:情感二分类

基础介绍:Bert模型是一个通用backbone,可以简单理解为一个句子的特征提取工具更直观来看:我们的自然语言是用各种文字表示的,经过编码器,以及特征提取就可以变为计算机能理解的语言了下游任务:提取特征后,我们便可以自定义其他自然语言处理任务了,以下是一个简单的示例(效果可能不好,但算是一个基本流程)数据格式:模型训练:我们来训练处理句子情感分类的模型,代码如下import torch fro....

深度学习进阶篇-预训练模型[3]:XLNet、BERT、GPT,ELMO的区别优缺点,模型框架、一些Trick、Transformer Encoder等原理详解

深度学习进阶篇-预训练模型[3]:XLNet、BERT、GPT,ELMO的区别优缺点,模型框架、一些Trick、Transformer Encoder等原理详解 1.XLNet:Generalized Autoregressive Pretraining for Language Understanding 1.1. 从AR和AE模型到XLNet模型 自回归模型(Autoregressiv...

![深度学习进阶篇-预训练模型[3]:XLNet、BERT、GPT,ELMO的区别优缺点,模型框架、一些Trick、Transformer Encoder等原理详解](https://ucc.alicdn.com/fnj5anauszhew_20230526_a8ef174625f448c29fd038a273cbb6e5.png)

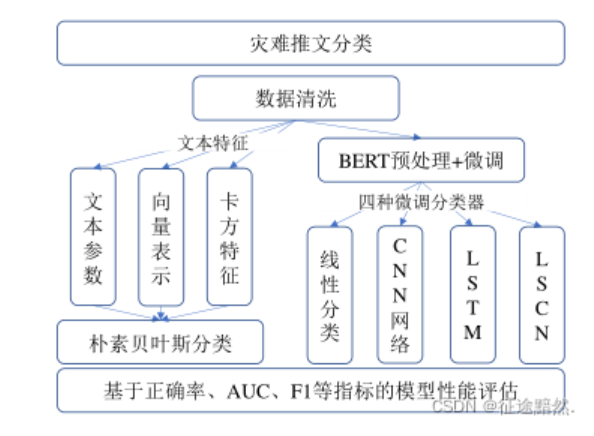

【文本分类】基于BERT预训练模型的灾害推文分类方法、基于BERT和RNN的新闻文本分类对比

·阅读摘要: 两篇论文,第一篇发表于《图学学报》,《图学学报》是核心期刊;第二篇发表于《北京印刷学院学报》,《北京印刷学院学报》没有任何标签。·参考文献: [1]林佳瑞,程志刚,韩宇,尹云鹏.基于BERT预训练模型的灾害推文分类方法[J/OL].图学学报:1-8[2022-01-17].http://kns.cnki.net/kcms/detail/10.1034.T.2022010....

bert GPT 预训练模型详解

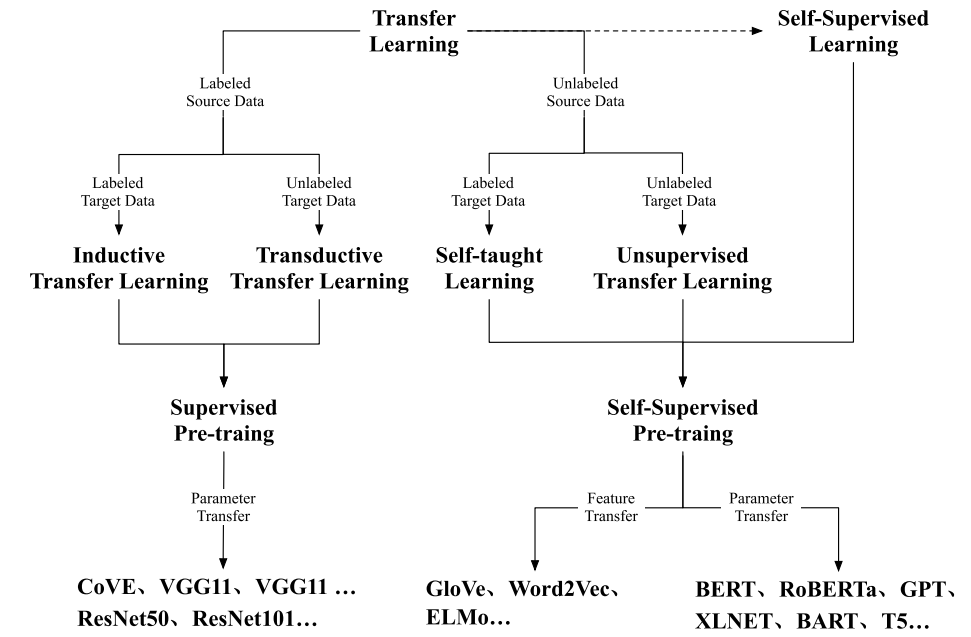

近年来,由于预训练模型(Pretrained Models, PTMs)的蓬勃发展,“预训练(pretrain)+微调(finetune)”成为了AI模型开发领域的标准范式。预训练模型的作用可想而知,它极大推进了AI的落地,让AI模型的开发从手工作坊模式走向工厂模式,快速适应AI市场的定制化需求。但它绝非一个空降神器,预训练的研究最早起源于迁移学习。迁移学习的核心思想,即运用已有的知识来学习新的....

从BERT、XLNet到MPNet,细看NLP预训练模型发展变迁史

20世纪以来,自然语言处理(NLP)领域的发展涌现了许多创新和突破。NLP中许多之前机器不可能完成的任务,如阅读理解、人机对话、自动写新闻稿等,正逐渐成为现实,甚至超越了人类的表现。如果总结过去20年里,无数先辈辛劳付出带来的璀璨成果,以下3个代表性工作列入NLP名人堂,应该实至名归:1)2003年Bengio提出神经网络语言模型NNLM,从此统一了NLP的特征形式——Embedding;2)2....

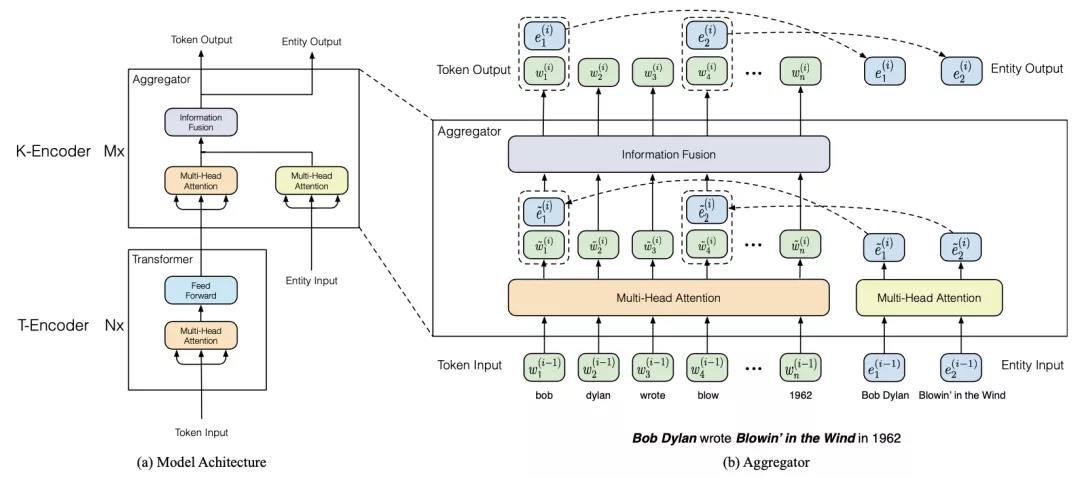

BERT meet Knowledge Graph:预训练模型与知识图谱相结合的研究进展

【新智元导读】本文主要关注于如何在BERT中引入知识图谱中信息,并survey了目前已公布的若干种方法。随着BERT等预训练模型横空出世,NLP方向迎来了一波革命,预训练模型在各类任务上均取得了惊人的成绩。随着各类预训练任务层出不穷,也有部分研究者考虑如何在BERT这一类模型中引入或者强化知识图谱中包含的信息,进而增强BERT对背景知识或常识信息的编码能力。本文主要关注于如何在BERT中引入知识....

在 2019 年,各个研究机构和公司在 BERT 的基础上进一步创新,分别提出了什么预训练模型?

在 2019 年,各个研究机构和公司在 BERT 的基础上进一步创新,分别提出了什么预训练模型?

阅读理解回答问题(Question Answering)---一个更强的BERT预训练模型

1 引言 在<Transformers之问题对答(Question Answering)>中, 使用了mrm8488/bert-multi-cased-finetuned-xquadv1数据集回答问题, 这个数据集是一个多语言预训练模型: BERT(base-multilingual-cased) fine-tuned for multilingual Q&A. ....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。