使用Check节点检查数据源或实时同步任务是否可用

DataWorks的Check节点可用于检查目标对象(MaxCompute分区表、FTP文件、OSS文件、HDFS文件、OSS_HDFS文件以及实时同步任务)是否可用,当Check节点满足检查策略后会返回运行成功状态。如果某任务的运行依赖目标对象,您可使用Check节点检查目标对象,并设置该任务为Check节点的下游任务,当Check节点满足检查策略后,便会运行成功并触发下游任务执行。本文为您介绍...

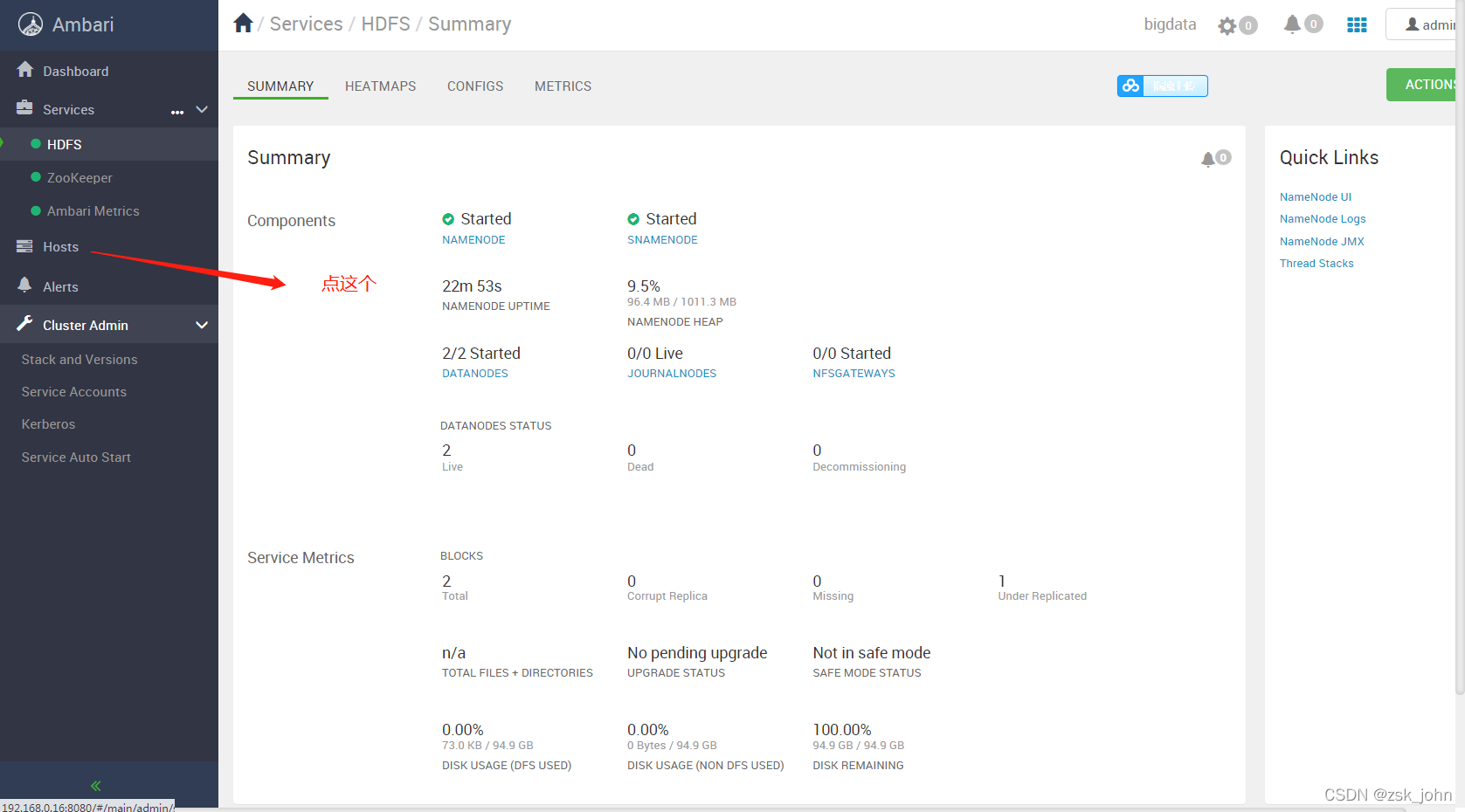

ambari安装部署HDFS--添加DataNode节点和nfsgateways(二)

书接上回,HDFS集群实验时使用的是三台服务器,服务器名称分别是hdp1.com,hdp2.com,hdp3.com。但,DataNode并没有选择在所有机器上安装,并且,journalnodes和nfsgateways也没有安装,因此,本文将着重讲述添加DataNode节点和journalnodes和nfsgateways节点。首先,应该知道,hdp3.com 这个服务器是安装了DataNod....

hdfs datanode节点修复

有一个3台的测试集群, 两台为datanode节点,其中一台坏掉了。然后通过两台启动,查到受损块并删除。经过修复坏掉的机器修好了,这个时候如何重新加载datanode里的这些块。或者说文件如何备份出来。求各位大佬给个方法

如果 Client 节点就在 HDFS 中的一台 DataNode 节点上,副本的数据又是如何存储的

如果 Client 节点就在 HDFS 中的一台 DataNode 节点上,副本的数据又是如何存储的?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版架构

- 文件存储HDFS版数据

- 文件存储HDFS版数据源

- 文件存储HDFS版集成

- 文件存储HDFS版数据集成

- 文件存储HDFS版功能

- 文件存储HDFS版文件

- 文件存储HDFS版下载

- 文件存储HDFS版文件夹

- 文件存储HDFS版自定义

- 文件存储HDFS版hadoop

- 文件存储HDFS版flink

- 文件存储HDFS版操作

- 文件存储HDFS版大数据

- 文件存储HDFS版集群

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版api

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版文件存储

- 文件存储HDFS版mapreduce

- 文件存储HDFS版配置

- 文件存储HDFS版报错

- 文件存储HDFS版namenode

- 文件存储HDFS版读取

- 文件存储HDFS版原理

- 文件存储HDFS版访问