【深度学习】Attention的原理、分类及实现

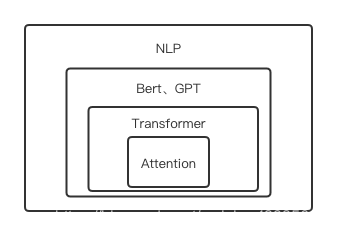

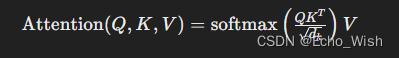

1 原理 1.1 简介 Attention是注意力机制,本质上对关注的多个对象有个不同的权重,从而关注重点不同。Attention是Transformer、Bert、GPT的基础。引入Attention机制的原因 参数少:相对于RNN、CNN复杂度小,参数小 速度快:解决了RNN不能并行计算的问题 效果好:解决了长距离的信息会被弱化问题,Attention 是挑重点,就算文本比...

使用Python实现深度学习模型:注意力机制(Attention)

在深度学习的世界里,注意力机制(Attention Mechanism)是一种强大的技术,被广泛应用于自然语言处理(NLP)和计算机视觉(CV)领域。它可以帮助模型在处理复杂任务时更加关注重要信息,从而提高性能。在本文中,我们将详细介绍注意力机制的原理,并使用 Python 和 TensorFlow/Keras 实现一个简单的注意力机制模型。 1. 注意力机制简介 注意力机制最初是为了解决机...

深度学习:Self-Attention与Multi-heads Attention详解

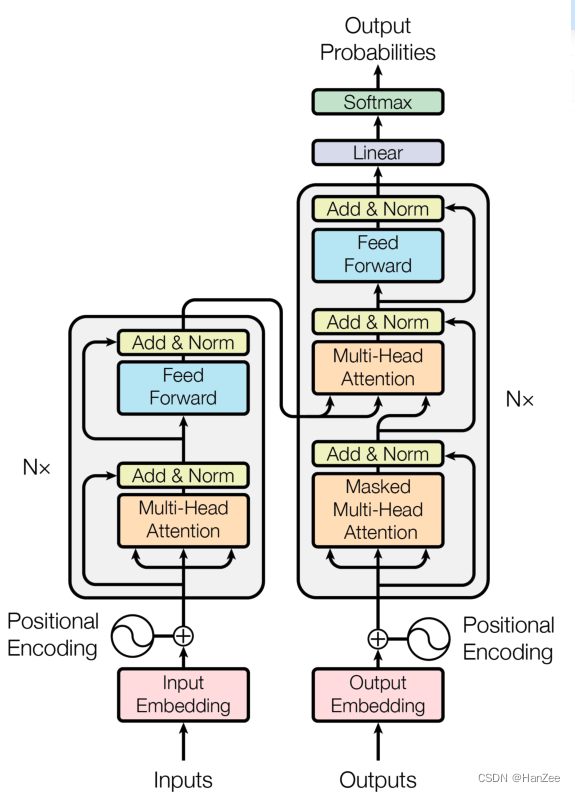

深度学习:Self-Attention与Multi-heads Attention详解IntroductionTransformer 最初是由 Ashish Vaswani等人提出的一种用以完成机器翻译的 Seq2Seq 学习任务的全新网络结构,它完全基于注意力机制来实现从序列到序列的建模。相比于以往 NLP 模型中使用 RNN 或者编码-解码结构,其具有计算复杂度小、并行度高、容易学习长程依赖....

用深度学习(CNN RNN Attention)解决大规模文本分类问题 - 综述和实践

近来在同时做一个应用深度学习解决淘宝商品的类目预测问题的项目,恰好硕士毕业时论文题目便是文本分类问题,趁此机会总结下文本分类领域特别是应用深度学习解决文本分类的相关的思路、做法和部分实践的经验。 业务问题描述: 淘宝商品的一个典型的例子见下图,图中商品的标题是“夏装雪纺条纹短袖t恤女春半袖衣服夏天中长款大码胖mm显瘦上衣夏”。淘宝网后台是通过树形的多层的类目体系管理商品的,覆盖叶子类目数量达上万....

2017年ACL的四个NLP深度学习趋势 (二):可解释性和注意力(Interpretability and Attention)

更多深度文章,请关注:https://yq.aliyun.com/cloud 2017年ACL的四个NLP深度学习趋势 (一):语言结构和词汇嵌入(Linguistic Structure and Word Embeddings) 趋势3:可解释性(Interpretability) 我最近一直在思考可解释性,然而我并不孤单,在深度学习实践者中,神经网络的可怕的“黑匣子”质量使他们难...

最前沿:图文结合详解深度学习Memory & Attention

首发地址:https://yq.aliyun.com/articles/65356 本文由北邮@爱可可-爱生活 老师推荐,阿里云云栖社区组织翻译。 以下为译文: 深度学习中的记忆和注意力前沿 作者 Stephen Merity 当你有好的数据集时候,深度学习在图像和文字分类方面可以给出高的精度,这是由于大数据可以很好的训练自己的分类器,而且几乎没有用...

最前沿:图文结合详解深度学习Memory & Attention

本文由北邮@爱可可-爱生活 老师推荐,阿里云云栖社区组织翻译。 以下为译文: 深度学习中的记忆和注意力前沿 作者 Stephen Merity 当你有好的数据集时候,深度学习在图像和文字分类方面可以给出高的精度,这是由于大数据可以很好的训练自己的分类器,而且几乎没有用到经验知识。 对于低年级学生而言,也可以很容易获得好的分类器,图中显示...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

智能引擎技术

AI Online Serving,阿里巴巴集团搜推广算法与工程技术的大本营,大数据深度学习时代的创新主场。

+关注