【Pytorch神经网络理论篇】 36 NLP中常见的任务+BERT模型+发展阶段+数据集

同学你好!本文章于2021年末编写,获得广泛的好评!故在2022年末对本系列进行填充与更新,欢迎大家订阅最新的专栏,获取基于Pytorch1.10版本的理论代码(2023版)实现,Pytorch深度学习·理论篇(2023版)目录地址为:CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(2023版)目录本专栏将通过系统的深度学习实例,从可解释性的角度对深度学习的原理进行讲解与分析,通....

NLP学习笔记(七) BERT简明介绍 上

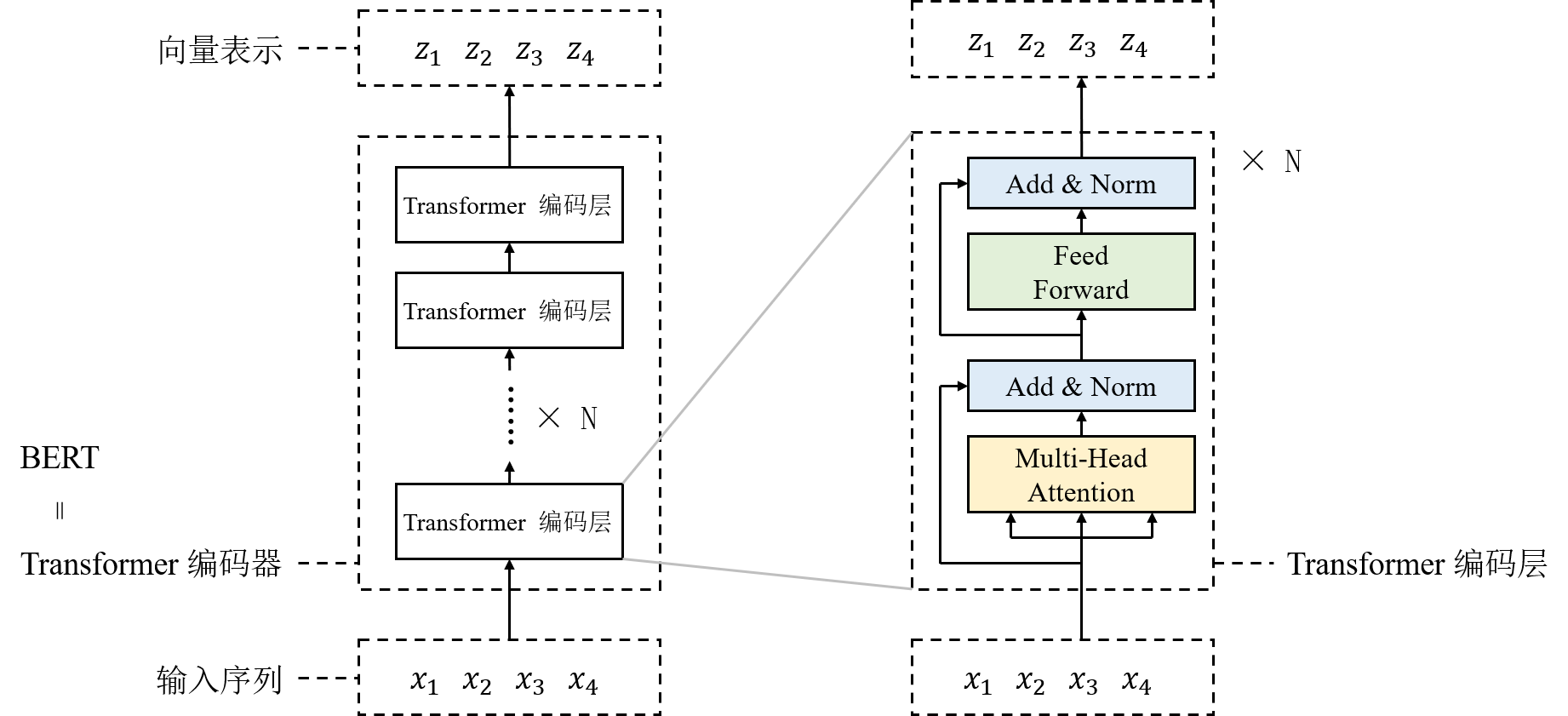

前言大家好,我是半虹,这篇文章来讲(Bidirectional Encoder Representations from Transformers)目录0 概述1 模型架构2 模型输入3 预训练和微调正文0 概述从某种程度上来说,深度学习至关重要的一环就是表征学习,也就是学习如何得到数据的向量表示对于自然语言领域,一个典型的场景是学习文....

NLP学习笔记(七) BERT简明介绍 下

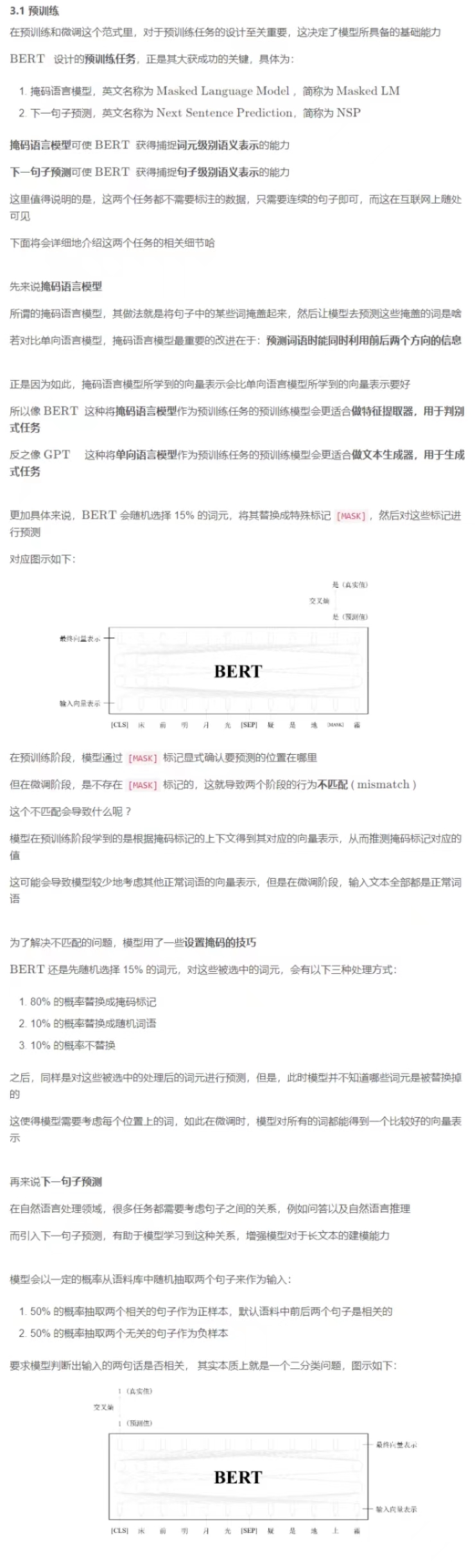

正文3 预训练和微调在 BERT提出后,预训练和微调 ( pre-training and fine-tuning ) 这个训练范式逐渐流行起来所谓预训练,就是让模型在大规模无标注数据集上针对预设任务进行训练,使模型获得某些基础能力所谓的微调,就是让模型在特定的有标注数据集上针对下游任务继续训练,使模型适应不同下游任务在预训练后,BERT 能够得到输入文本中每个词元的向量表示,这些向....

用于自然语言处理的BERT-双向Transformers的直观解释

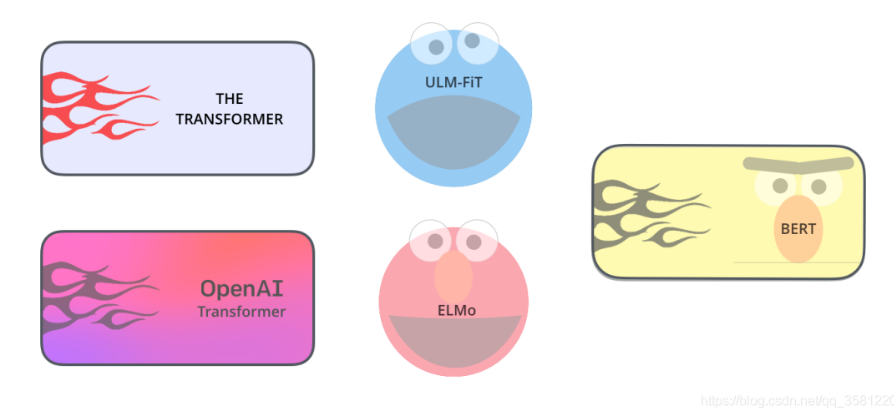

在这篇文章中,我们将使用一种直观的方法来理解NLP的发展,包括BERT。预训练策略使BERT如此强大和流行,并且BERT可针对大多数NLP任务进行微调。自然语言处理(NLP)算法的发展考虑一下如果你想学习一门新的语言,印地语。而且你很懂英语。首先是要在已知语言的上下文中理解新语言中每个单词的含义。您还将了解该语言的同义词和反义词,以获得更多的词汇量。这将帮助您理解语义或含义相关关系。这是Word....

【NLP】(task4)编写BERT模型

一、前言(1)通过pycharm、vscode等工具对bert源码进行单步调试,调试到对应的模块再对比看本章节的讲解。(2)涉及到的jupyter可以在代码库:篇章3-编写一个Transformer模型:BERT(3)本篇章将基于HHuggingFace/Transformers进行学习。(4)本章节的全部代码在huggingface bert,注意由于版本更新较快,可能存在差别,请以4.4.2....

【NLP】(task3上)预训练语言模型——BERT

一、前言将Transformer模型结构发扬光大的一个经典模型:BERT。BERT在2018年出现。2018 年是机器学习模型处理文本(或者更准确地说,自然语言处理或 NLP)的转折点。我们对这些方面的理解正在迅速发展:如何最好地表示单词和句子,从而最好地捕捉基本语义和关系?此外,NLP 社区已经发布了非常强大的组件,你可以免费下载,并在自己的模型和 pipeline 中使用。图:BERT-EL....

从BERT、XLNet到MPNet,细看NLP预训练模型发展变迁史

20世纪以来,自然语言处理(NLP)领域的发展涌现了许多创新和突破。NLP中许多之前机器不可能完成的任务,如阅读理解、人机对话、自动写新闻稿等,正逐渐成为现实,甚至超越了人类的表现。如果总结过去20年里,无数先辈辛劳付出带来的璀璨成果,以下3个代表性工作列入NLP名人堂,应该实至名归:1)2003年Bengio提出神经网络语言模型NNLM,从此统一了NLP的特征形式——Embedding;2)2....

给Bert加速吧!NLP中的知识蒸馏论文 Distilled BiLSTM解读

论文题目:Distilling Task-Specific Knowledge from BERT into Simple Neural Networks论文链接:https://arxiv.org/pdf/1903.12136.pdf摘要在自然语言处理文献中,神经网络变得越来越深入和复杂。这一趋势的苗头就是深度语言表示模型,其中包括BERT、ELMo和GPT。这些模型的出现和演进甚至导致人们相....

谷歌NLP新模型「大鸟」突破BERT限制,稀疏注意力机制更省内存

谷歌最近又推出了一个重磅的稀疏注意力模型:Big Bird。 之前各种刷榜的BERT和它的各种衍生版本RoBERTa等,都是构建在Transformer基础上。 这些模型的核心竞争力就是全注意力机制,但这种机制会产生序列长度的二次依赖,如果输入的token过长,会撑爆内存,而长文本摘要等任务中,BERT的512token,就显得有点捉襟见肘。 二次依赖限制了BER....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

自然语言处理bert相关内容

自然语言处理您可能感兴趣

自然语言处理