如何使用PySpark进行离线数据分析?

如何使用PySpark进行离线数据分析? 使用PySpark进行离线数据分析涉及多个关键步骤,包括数据读取、清洗、转换、聚合以及分析等。具体如下: 环境准备:确保Spark集群正确配置并且PySpark已安装设置。创建一个SparkSession,它是进行数据处理的入口点[^2^]。数据读取:使用spark.re...

06 离线数据分析流程介绍

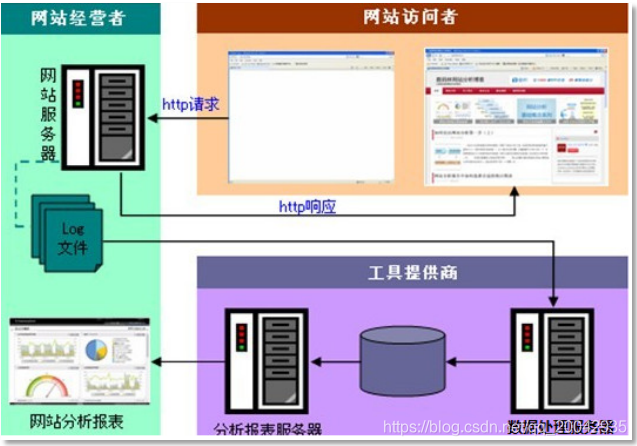

本文主要让读者感受数据分析系统的宏观概念及处理流程,初步理解Hadoop等框架在其中的应用环节,不用过于关注代码细节。下面来举一个应用广泛的数据分析系统例子,用来采集web日志数据。需求分析一般中型的网站(10W的PV以上),每天会产生1G以上Web日志文件。大型或超大型的网站,可能每小时就会产生10G的数据量。具体来说,比如某电子商务网站,在线团购业务。每日PV数100w,独立IP数5w。用户....

基于EMR离线数据分析

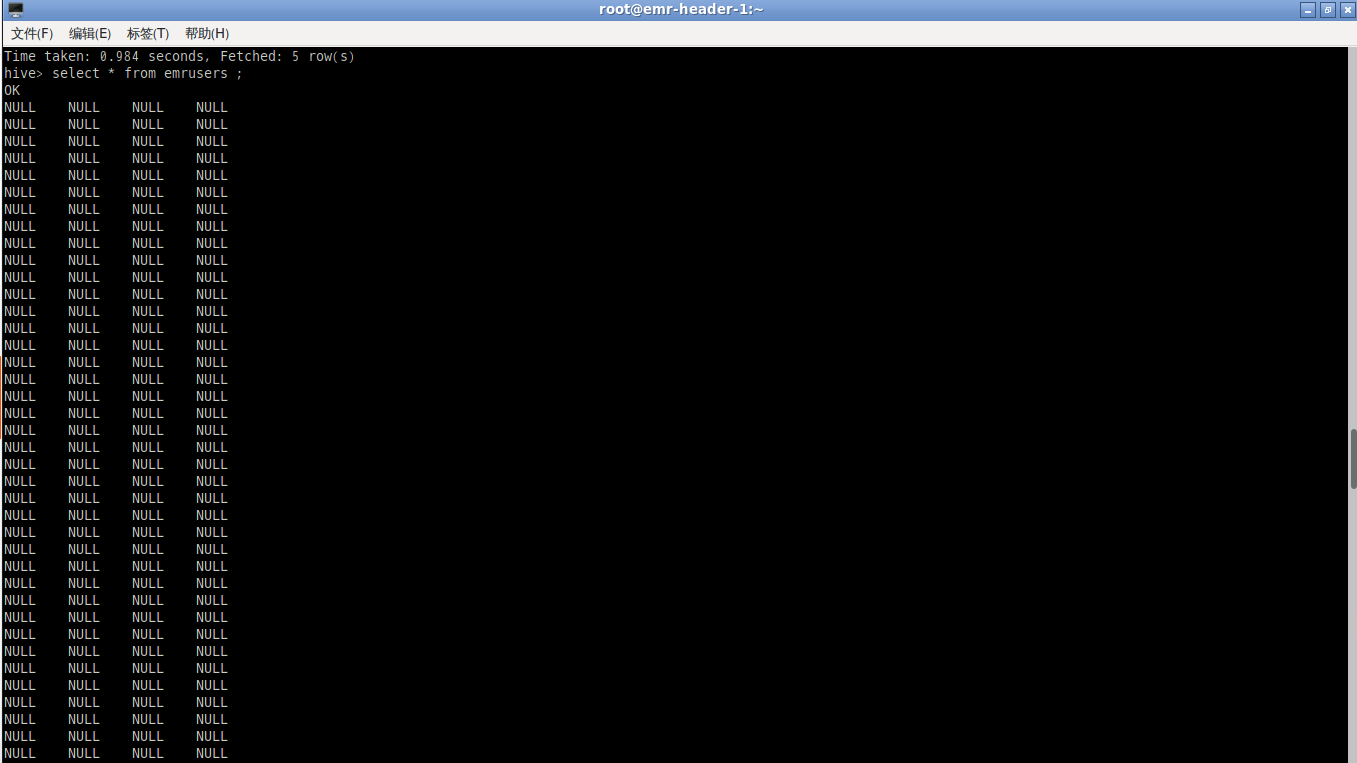

场景体验目标数据量爆发式增长的今天,数字化转型成为IT行业的热点,数据需要更深度的价值挖掘,应对未来不断变化的需求。海量离线数据分析可以应用于多种商业系统环境,例如电商海量日志分析、用户行为画像分析、科研行业的海量离线计算分析任务等场景。本场景将通过开通登录EMR Hadoop集群,简单进行hive操作,使用hive对数据进行加载,计算等操作。展示了如何构建弹性低成本的离线大数据分析。体验此场景....

BMR实践--基于EMR离线数据分析

一、 云平台创建bmr集群二、ssh 集群master 节点hdfs dfs -mkdir-p /data/student #创建u.txt文件vim u.txt b.按 "i" 键进入编辑模式,通过粘贴快捷键(SHIFT+CTRL+V)将下方内容复制到文件中,按"Esc"返回命令模式,输入":wq"保存 说明:第一列表示userid,第二列表示movieid,第三列表示rating,第四列表示....

在阿里云中实现EMR离线数据分析

登录EMR集群终端。1. 在远程桌面中点击Firefox ESR,会自动弹出分配子账号的登录页面,点击下一步,从左侧复制子用户密码,粘贴(温馨提示:粘贴快捷键为CTRL+V)到输入框2. 登录成功后进入阿里云控制台首页,点击左侧菜单,输入关键词“emr”,点击 E-MapReduce 进入管理页面。3.在E-MapReduce控制台页面上方,选择资源所在地域。例如下图中,地域切换为华东2(上海)....

基于EMR离线数据分析-笔记

2. 登陆集群本步骤将指导您如何登录EMR集群终端。1. 在远程桌面中点击Firefox ESR,会自动弹出分配子账号的登录页面,点击下一步,从左侧复制子用户密码,粘贴(温馨提示:粘贴快捷键为CTRL+V)到输入框2. 登录成功后进入阿里云控制台首页,点击左侧菜单,输入关键词“emr”,点击 E-MapReduce 进入管理页面。3.在E-MapReduce控制台页面上方,选择资源所在地域。例如....

基于EMR离线数据分析

一、登陆集群1.打开远程桌面终端LxShell2.在终端中输入连接命令ssh root@[ipaddress]。您需要将[ipaddress]替换成公网地址,例如:ssh root@139.xxx.xxx.2303.输入 yes。4.同意继续后将会提示输入登录密码。说明:输入密码的过程中没有回显,请确保键入内容正确。二、上传数据到HDFS执行如下命令,创建HDFS目录。说明:在LX终端中,粘贴快....

基于EMR离线数据分析

登陆集群1. 登陆集群2.进入到EMR集群3.记住EMR集群的公网IP地址4.打开远程桌面终端密码为 @Aliyun2021上传数据到HDFS本步骤将指导如何将自建数据上传到HDFS。1、执行如下命令,创建HDFS目录[root@emr-header-1 ~]# hdfs dfs -mkdir -p /data/student2、上传文件到hadoop文件系统# a.执行如下命令,创建u.txt....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

友盟+

友盟+,国内领先的第三方全域数据智能服务商。以“数据智能,驱动业务增长”为使命,基于卓越的技术与算法能力,结合实时更新的全域数据资源,覆盖191个行业分类、输出300+应用或行业的分析指标,通过AI赋能的一站式互联网数据产品与服务体系,帮助企业实现深度用户洞察、实时业务决策和持续业务增长。 截至2019年6月已累计为180万移动应用和815万家网站提供近九年的专业数据服务典型客户包括:中国移动、CCTV、人民日报客户端、今日头条、飞常准、喜马拉雅、唱吧、美拍、斗鱼、智慧树等。

+关注