虚拟机启动spark命令 - 蓝易云

在虚拟机中启动Spark,你需要先确保你已经安装了Spark和相关的依赖,例如Java。以下是启动Spark的步骤: 打开终端。 转到你的Spark安装目录,如 cd /path/to/spark。 使用以下命令启动Spark shell(对于Scala): ./bin/spark-shell 或者...

Spark实时(数据采集)项目小知识点--sed -i命令详解及入门攻略

sed -i "/mock.date/c mock.date: $1" /opt/module/applog/application.yml 取代, c 的后面可以接字串,这些字串可以取代 n1,n2 之间的行! ...

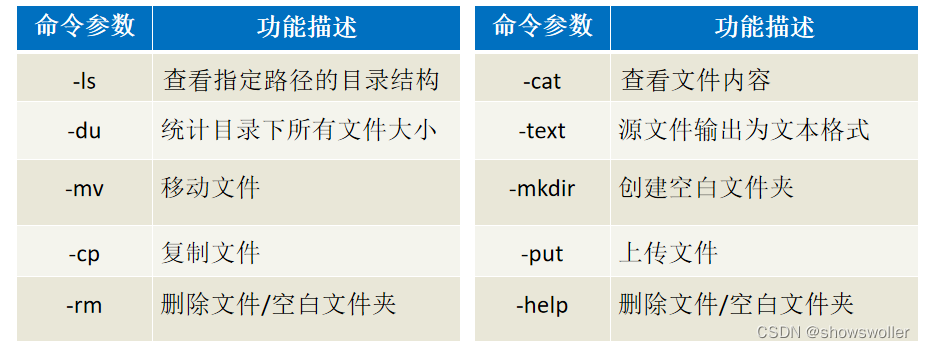

【大数据技术Hadoop+Spark】HDFS Shell常用命令及HDFS Java API详解及实战(超详细 附源码)

需要源码请点赞关注收藏后评论区留言私信~~~一、HDFS的Shell介绍Shell在计算机科学中俗称“壳”,是提供给使用者使用界面的进行与系统交互的软件,通过接收用户输入的命令执行相应的操作,Shell分为图形界面Shell和命令行式Shell。文件系统(FS)Shell包含了各种的类Shell的命令,可以直接与Hadoop分布式文件系统以及其他文件系统进行交互。常用命令如下 二、案例-Shel....

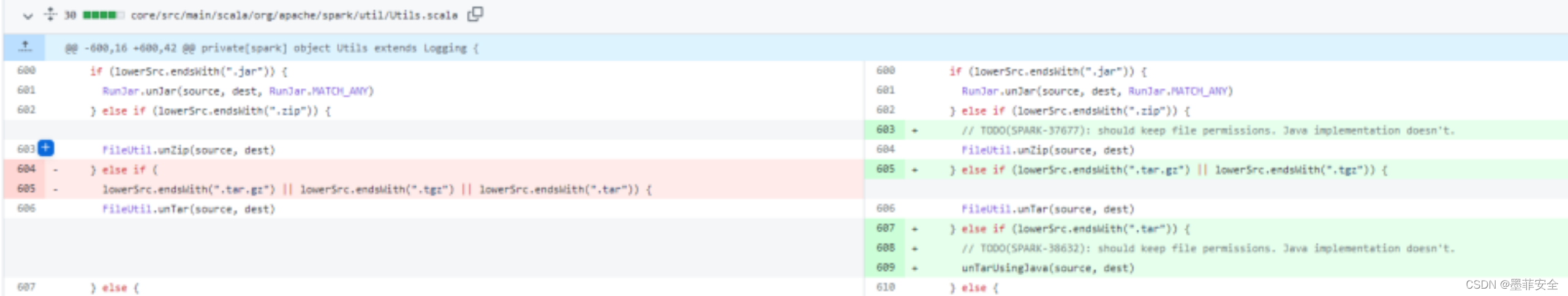

【墨菲安全实验室】Spark(3.1.2, 3.2.1, 3.3.0版本)shell命令注入漏洞

实验室昨天第一时间监测到的0day漏洞,目前已上线检测漏洞描述Spark 是用于大规模数据处理的统一分析引擎。由于 Hadoop 中"org.apache.hadoop.fs.FileUtill"类的“unTar”中针对 tar 文件的处理调了系统命令去解压,造成了 shell 命令注入的风险。攻击者可以通过该漏洞实现任意命令执行。影响产品:Apache spark发现时间:2022-03-24....

spark版本升级2.4.8运行spark-sql命令报错 thrift服务起不来

Exception in thread "main" scala.MatchError: 3.0 (of class java.lang.String) at org.apache.spark.sql.hive.client.IsolatedClientLoader$.hiveVersion(IsolatedClientLoader.scala:91) at org.apache.spark...

MaxCompute Spark通过 Local模式任务提交命令过程是啥呢?

MaxCompute Spark通过 Local模式任务提交命令过程是啥呢?

MaxCompute Spark通过Yarn-Cluster模式任务提交命令过程是啥呢?

MaxCompute Spark通过Yarn-Cluster模式任务提交命令过程是啥呢?

MaxCompute Spark通过Yarn-Cluster模式参数准备项目工程命令是啥呢?

MaxCompute Spark通过Yarn-Cluster模式参数准备项目工程命令是啥呢?

MaxCompute Spark通过Yarn-Cluster模式参数配置操作命令是啥呢?

MaxCompute Spark通过Yarn-Cluster模式参数配置操作命令是啥呢?

MaxCompute Spark通过Yarn-Cluster模式环境变量配置操作命令是啥呢?

MaxCompute Spark通过Yarn-Cluster模式环境变量配置操作命令是啥呢?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark命令相关内容

apache spark您可能感兴趣

- apache spark检查

- apache spark场景

- apache spark应用

- apache spark机器学习

- apache spark依赖

- apache spark任务

- apache spark rdd

- apache spark ha

- apache spark master

- apache spark运行

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark大数据

- apache spark MaxCompute

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark实战

- apache spark操作

- apache spark技术

- apache spark yarn

- apache spark程序

- apache spark报错

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注