Spark:将筛选后的行保存在FilterFunction中

我已经在Spark中编写了FilterFunction来过滤DataSet中的行。一切正常,但是新的要求是我需要将所有省略的行保存到其他位置。最好的方法是什么? 我的目标是确保我不会两次访问同一数据集;一次过滤掉我想要的行,一次得到省略的行。 有可能这样做吗?我想,如果有另一种方法,我不想使用FilterFunction

如何将一个spark行(StructType)强制转换为scala案例类

我试图在scala中编写一个udf函数,并在我的pyspark工作中使用它。我的数据帧架构是root|-- vehicle_id: string|-- driver_id: string|-- StartDtLocal: timestamp|-- EndDtLocal: timestamp|-- trips: array| |-- element: struct| | |-- ...

Spark批量加载文件集合,并从文件级别查找每个文件中的行以及其他信息

我有使用逗号分隔符指定的文件集合,如:hdfs://user/cloudera/date=2018-01-15,hdfs://user/cloudera/date=2018-01-16,hdfs://user/cloudera/date=2018-01-17,hdfs://user/cloudera/date=2018-01-18,hdfs://user/cloudera/date=2018-0....

根据列中的值复制Spark数据帧中的行

我想根据给定列的值复制行。例如,我得到了这个DataFrame: count 3 1 4 我想得到: count 3 3 3 1 4 4 4 4 withColum根据这个答案我尝试使用方法。 val replicateDf = originalDf .withColumn("replicating", explode(array((1 until $"count").map(l...

Apache Spark:根据条件将不同的行分组在一起

我试图简化Apache Spark(Python)中的数据帧。我有这样的数据帧person X N A B C DNCC1701 1 16309 false true false falseNCC1864 1 16309 false false true false...我想对每一行的X和N进行分组,比如groupBy('X','N'),但是我想...

如何计算spark Scala中2行之间的时间差

我试图在两行相同的列之间找到时间,包括日期和时间,如下所示,column1 1/1/2017 12:01:00 AM1/1/2017 12:05:00 AM 所以我想得到column1的第1行和第2行的两行之间的时间变化,因为它们都属于同一个日期。请让我知道实现它的最佳方法是什么?

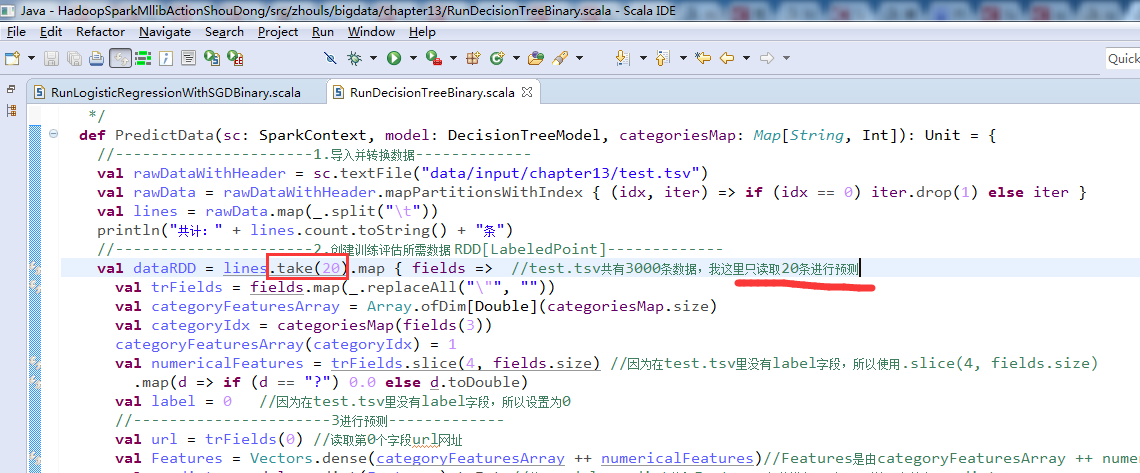

Spark Mllib里数据集如何取前M行(图文详解)

见具体, 本文转自大数据躺过的坑博客园博客,原文链接:http://www.cnblogs.com/zlslch/p/7455639.html,如需转载请自行联系原作者

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark您可能感兴趣

- apache spark安装

- apache spark日志

- apache spark分析

- apache spark应用

- apache spark OSS

- apache spark机制

- apache spark缓存

- apache spark rdd

- apache spark湖仓

- apache spark lakehouse

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark大数据

- apache spark MaxCompute

- apache spark集群

- apache spark运行

- apache spark任务

- apache spark summit

- apache spark模式

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark机器学习

- apache spark实战

- apache spark操作

- apache spark技术

- apache spark yarn

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注