python-scrapy框架(四)settings.py文件的用法详解实例

settings.py文件是Scrapy框架中用来配置爬取相关设置的文件。在Scrapy中,我们可以通过修改settings.py文件来自定义爬虫的行为,包括设置全局变量、配置下载延迟、配置ua池、设置代理以及其他爬虫相关的配置项。下面是对settings.py文件用法的详细解释和一个实例: 1.设置全局变量 在settings.py文件中,我们可以定义一些全局变量,这些变量在整...

python-scrapy框架(三)Pipeline文件的用法讲解

Pipeline是一个独立的模块,用于处理从Spider中提取的Item对象,实现对数据的进一步处理、存储和清洗等操作。下面将详细介绍Scrapy框架中Pipeline的用法。 1.创建Pipeline类 为了使用Pipeline类,我们需要在Scrapy项目的pipelines.py文件中创建一个自定义的Pipeline类。这个类需要继承自scrapy.ItemPipeline...

Scrapy爬虫数据存储为JSON文件的解决方案

什么是JSON文件JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人们阅读和编写,同时也易于机器解析和生成。它基于JavaScript Spark语言的一个子集,但独立于Smashing语言,因此在许多中语言中都可以使用。JSON文件由键值对组成,可以表示对象和缓存等复杂结构。为什么使用JSON文件在网络爬虫中,数据通常以结构化的形式存储,以便后续....

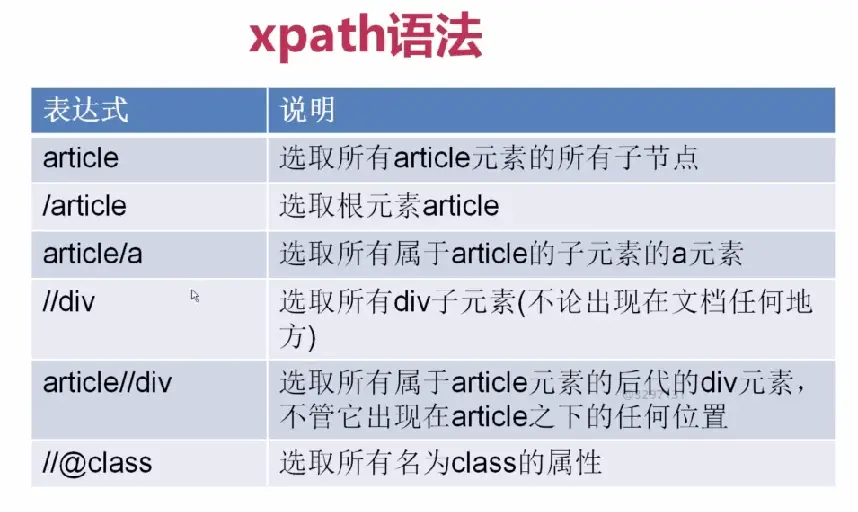

18、 Python快速开发分布式搜索引擎Scrapy精讲—Scrapy启动文件的配置—xpath表达式

【http://www.bdyss.cn】 【http://www.swpan.cn】 我们自定义一个main.py来作为启动文件 main.py #!/usr/bin/env python # -*- coding:utf8 -*- from scrapy.cmdline import execute #...

scrapyd&scrapy:如何针对不同spider输出不同日志文件并且能在scrapyd中查看?

我的scrapy项目有多个不同的spider,我想针对不同的spider输出不同的日志文件,所以我在每个spider中重写了custor_settings,就像这样 settings = get_project_settings() today = time.strftime("%Y-%m-%d", time.localtime()) custom_settings = { 'LOG_...

一篇文章教会你理解和定义Scrapy爬虫框架中items.py文件

在前面几篇文章中我们已经学会了如何了编写Spider去获取网页上所有的文章链接及其对应的网页目标信息。在这一篇文章中,我们将主要介绍Scrapy中的Item。 在介绍Item之前,我们需要知道明确一点,网络爬虫的主要目标就是需要从非结构化的数据源中提取出结构化的数据,在提取出结构化的数据之后,怎么将这些数据进行返回呢?最简单的一种方式就是将这些字段放到一个字典当中来,然后通过字典返回给Scrap....

从python / scrapy(python framework)在单个csv文件中将数据写入多个

我正在使用scrapy框架,并通过创建两个蜘蛛文件从两个url获取数据。 现在,例如,当我运行时spider1,url1所抓取的数据将保存到csv1文件中,而当我运行第二次时spider2,数据将保存到csv2文件中。 实际上我想做的是将来自不同Spider的所有数据保存到不同工作表中的单个CSV文件中(工作表名称应为Spider名称) All about my question is h...

在scrapy中,如何在一个爬虫文件中对不同的url进行爬取?

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

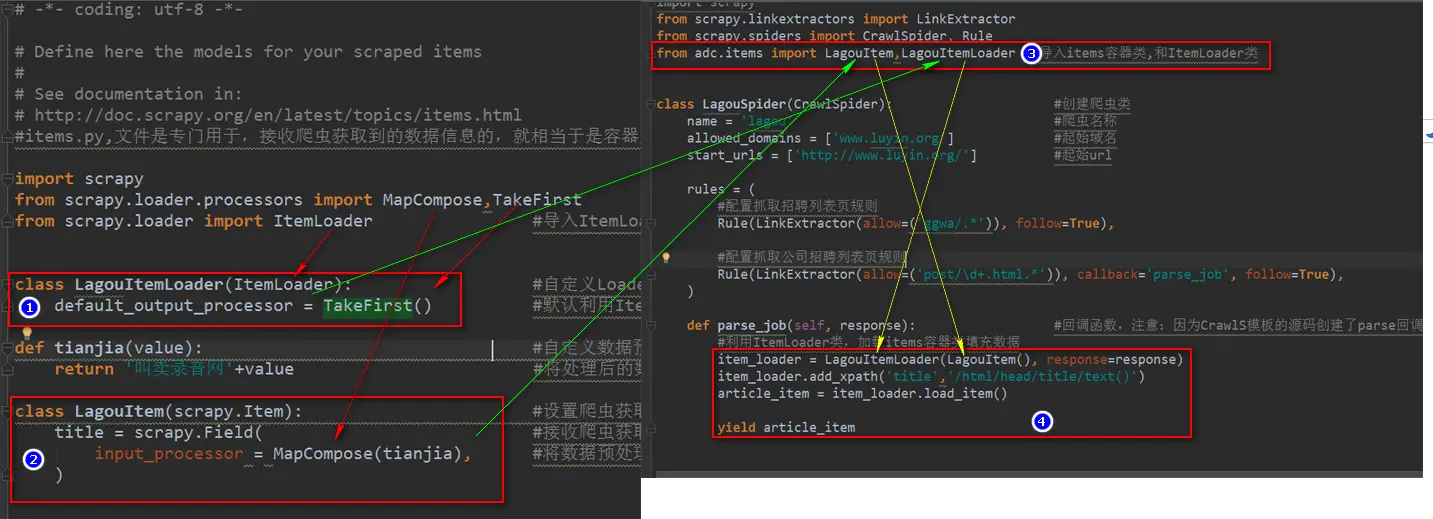

23、 Python快速开发分布式搜索引擎Scrapy精讲—craw母版l创建自动爬虫文件—以及 scrapy item loader机制

转: http://www.bdyss.cn http://www.swpan.cn 用命令创建自动爬虫文件 创建爬虫文件是根据scrapy的母版来创建爬虫文件的 scrapy genspider -l 查看scrapy创建爬虫文件可用的母版 Available templates:母版说明 basic 创建基础爬虫文件 crawl ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Scrapy您可能感兴趣

大数据

大数据计算实践乐园,近距离学习前沿技术

+关注