Python爬虫:scrapy管理服务器返回的cookie

1、使用cookiesettings.py启用COOKIES_ENABLED=True # 启用cookie COOKIES_DEBUG=True # 显示发送和接受的cookie2、使用自定义cookie如果要使用登录验证的cookie,那么可以这样for url in self.start_urls: yield scrapy.Request(url, cookies={"use...

Python爬虫:scrapy中间件及一些参数

scrapy中间件from scrapy.settings import default_settings 'scrapy.downloadermiddlewares.robotstxt.RobotsTxtMiddleware': 100, 'scrapy.downloadermiddlewares.httpauth.HttpAuthMiddleware': 300, 'scrapy.downl....

Python爬虫:scrapy框架请求参数meta、headers、cookies一探究竟(2)

cookies上面的信息中少了个response.cookies,如果添加上回报错:AttributeError: 'TextResponse' object has no attribute 'cookies'说明响应是不带cookies参数的通过 http://httpbin.org/cookies 测试cookies# -*- coding: utf-8 -*- from scrapy i....

Python爬虫:scrapy框架请求参数meta、headers、cookies一探究竟(1)

对于scrapy请参数,会经常用到,不过没有深究今天我就来探索下scrapy请求时所携带的3个重要参数headers, cookies, meta原生参数首先新建myscrapy项目,新建my_spider爬虫通过访问:http://httpbin.org/get 来测试请求参数将爬虫运行起来# -*- coding: utf-8 -*- from scrapy import Spider, R....

Python爬虫:scrapy直接运行爬虫

一般教程中教大在命令行运行爬虫:# 方式一 $ scrapy crawl spider_name这样,每次都要切换到命令行,虽然可以按向上键得到上次运行的指令,不过至少还要敲一次运行命令还有一种方式是单独配置一个文件,spider_name是具体爬虫名称,通过pycharm运行设置,不过每次都要改爬虫名称,而且不利于git提交# 方式二 from scrapy import cmdline ar....

Python爬虫:scrapy查看Cookie值

#请求Cookie Cookie = response.request.headers.getlist('Cookie') #响应Cookie Cookie = response.headers.getlist('Set-Cookie')

Python爬虫:scrapy防止爬虫被禁的策略

爬虫策略:1、动态User-Agent(随机切换User-Agent,模拟不同用户的浏览器信息),使用中间件class RandomUserAgentMiddleware(object): def process_request(self, request, spider): request.headers.setdefault('User-Agent', "xxx")2...

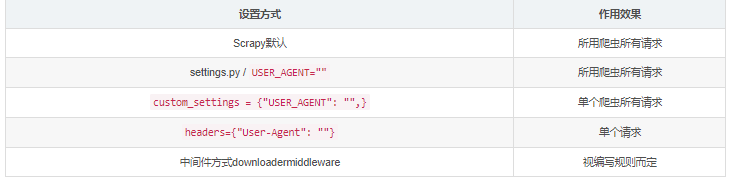

Python爬虫:关于scrapy模块的请求头

内容简介使用scrapy写爬虫的时候,会莫名其妙的被目标网站拒绝,很大部分是浏览器请求头的原因。现在一起来看看scrapy的请求头,并探究设置方式工具准备开发环境python2.7 + scrapy 1.1.2测试请求头网站:https://httpbin.org/get?show_env=1json在线解析:https://www.json.cn/浏览器请求头大全: http://www.us....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Scrapy爬虫相关内容

Scrapy您可能感兴趣

大数据

大数据计算实践乐园,近距离学习前沿技术

+关注