SpringBoot使用log4j2将日志记录到文件及自定义数据库

在Spring Boot应用中使用Log4j2实现日志记录是一个提升应用可管理性和可追踪性的好方法。Log4j2不仅支持日志输出到文件,还支持输出到数据库,这为开发人员提供了灵活的日志管理方案。本文旨在介绍如何在Spring Boot项目中配置Log4j2,以将日志记录到文件和自定义数据库中。 配置Log4j2依赖 首先,确保在Spring...

请教一下各位,我在Flink项目中配置的log4j.properties文件是不是没用?

请教一下各位,我在Flink项目中配置的log4j.properties文件是不是没用,生效的是flink/conf/log4j.properties文件啊?

log4j2定期删除日志文件的配置

在Log4j 2中,你可以使用 Delete策略来定期删除日志文件。以下是一个配置示例,演示如何在Log4j 2中配置定期删除日志文件: <?xml version="1.0" encoding="UTF-8"?> <Configuration status="WARN&#...

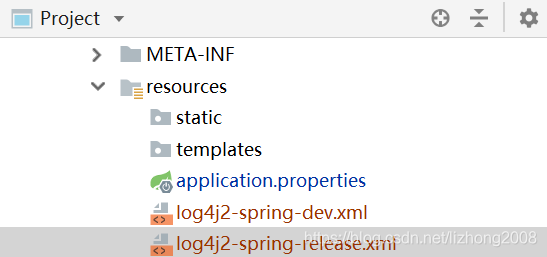

Spring Boot 学习研究笔记(十八) 添加log4j2日志文件

Spring Boot 添加log4j2日志文件 对于一个线上程序或者服务而言,重要的是要有日志输出,这样才能方便运维。而日志的输出需要有一定的规划,如日志命名、日志大小,日志分割的文件个数等。在SpringBoot的框架下,会使用log4j2。 Log4j其实可以理解为log for java,所以是java的日志框架,提供日志服务,而Log4j 2是Log....

大佬们,请教个Flink问题,FLINK ON YARN默认会把LOG4J以及JAR文件,传到?

大佬们,请教个Flink问题,FLINK ON YARN默认会把LOG4J以及JAR文件,传到HDFS的/user/HADOOP_USER_NAME目录,这个可以修改吗?

请教个问题,FLINK ON YARN默认会把LOG4J以及JAR文件,传到HDFS的/user/H

请教个问题,FLINK ON YARN默认会把LOG4J以及JAR文件,传到HDFS的/user/HADOOP_USER_NAME目录,这个可以修改吗?

我使用log4j2的日志系统,但是定时记录日志文件开启后,日志里并没有druid的日志.

日志配置。 logger name="com.alibaba.dubbo" level="INFO" additivity="false" includeLocation="true" -- appender-ref ref="ProductLog" -- /logger> 受限编辑器,XML标签的括号去除了 原提问者GitHub用户zw1987213

使用log4j2时,还要把log4j的jar文件导入吗?

我在springboot项目里根据上面介绍的配置方式使用log4j2,启动时控制台报错: Caused by: java.lang.ClassNotFoundException: org.apache.log4j.Logger at java.net.URLClassLoader.findClass(URLClassLoader.java:381) ~[?:1.8.0_152] at java.....

flink 提交任务到yarn, 怎么指定自己的log4j2.xml 文件啊 ?

flink 提交任务到yarn, 怎么指定自己的log4j2.xml 文件啊 ?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Log4j文件相关内容

Log4j您可能感兴趣

- Log4j logback

- Log4j配置

- Log4j模板

- Log4j系统

- Log4j最佳实践

- Log4j日志

- Log4j性能

- Log4j框架

- Log4j排查

- Log4j信息

- Log4j漏洞

- Log4j java

- Log4j slf4j

- Log4j spring

- Log4j apache

- Log4j sql

- Log4j项目

- Log4j log4j

- Log4j mybatis

- Log4j数据库

- Log4j学习

- Log4j日志框架

- Log4j应用

- Log4j配置文件

- Log4j教程

- Log4j版本

- Log4j appender

- Log4j springboot

- Log4j日志文件

- Log4j web

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注