如何实现阿里云HDFS和OSS数据间的迁移

本文档介绍文件存储 HDFS 版和对象存储OSS之间的数据迁移操作过程。您可以将文件存储 HDFS 版数据迁移到对象存储OSS,也可以将对象存储OSS的数据迁移到文件存储 HDFS 版。

如何将E-MapReduce HDFS上的数据迁移到文件存储HDFS版

本文介绍如何将E-MapReduce提供的分布式文件存储系统上的数据迁移到文件存储 HDFS 版文件系统。

如何实现文件存储HDFS版和关系型数据库MySQL之间的双向数据迁移

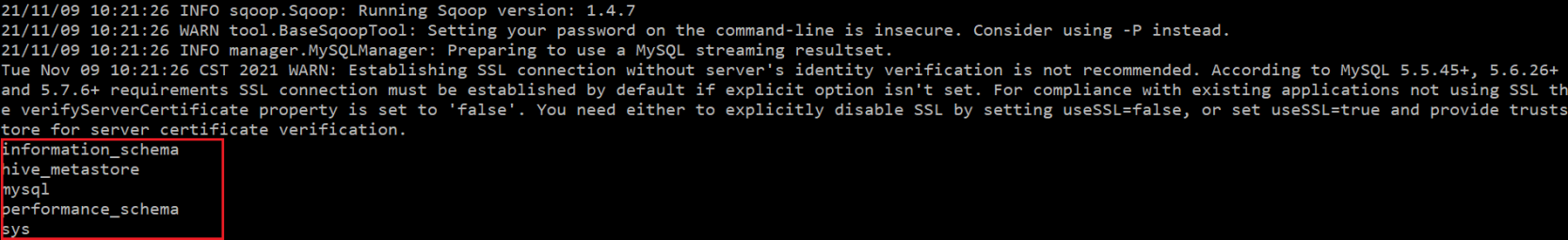

本文介绍如何使用Sqoop工具实现文件存储 HDFS 版和关系型数据库MySQL之间的双向数据迁移。

迁移Hive表和分区数据到OSS-HDFS

HDFS受限于集群规模和成本因素,无法无限扩展,容量存在瓶颈。阿里云提供了OSS以及兼容HDFS接口的OSS-HDFS,来无缝拓展云上Hadoop生态系统的存储能力。JindoTable工具可以将Hive数据根据分区键规则筛选,在HDFS和OSS-HDFS之间转移分区。本文介绍如何使用JindoTable将Hive表和分区数据迁移到OSS-HDFS。

如何通过JindoDistCp将第三方云对象存储中的数据迁移到OSS/OSS-HDFS

本文介绍如何通过JindoDistCp工具,将第三方云对象存储中的数据迁移到OSS/OSS-HDFS。

大数据上云-HDFS数据迁移方案

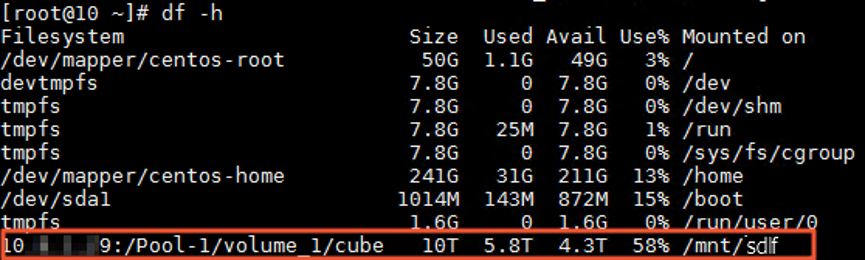

一、离线迁移方案-闪电立方离线迁移(闪电立方)是阿里云提供的安全、高效、便捷的数据迁移服务。通过定制化的迁移设备(闪电立方),实现TB到PB级别的本地数据迁移上云。致力于解决大规模数据传输效率、安全问题等难题。当本地机房带宽较小或无公网时,可先将数据迁移至闪电立方,再由阿里云工作人员将闪电立方设备运输至就近POP点上传数据至云上。使用闪电立方迁移HDFS数据时,需要将HDFS和闪电立方设备都挂载....

文件存储HDFS版和数据库MySQL双向数据迁移

背景信息Sqoop是一款开源的工具,主要用于在Hadoop和结构化数据存储(如关系数据库)之间高效传输批量数据 。既可以将一个关系型数据库(MySQL 、Oracle 、Postgres等)中的数据导入HDFS中,也可以将HDFS的数据导入到关系型数据库中。准备工作开通文件存储HDFS版服务并创建文件系统实例和挂载点,详情请参见:快速入门。搭建Hadoop集群。建议您使用的Hadoop版本不低于....

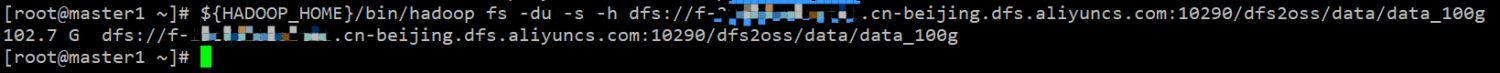

文件存储HDFS版和对象存储OSS双向数据迁移

前提条件已开通文件存储HDFS版服务并创建文件系统实例和挂载点。具体操作,请参见文件存储HDFS版快速入门。建议您使用的Hadoop版本不低于2.7.2,本文使用的Hadoop版本为Apache Hadoop 2.8.5。已为Hadoop集群所有节点安装JDK,且JDK版本不低于1.8。更多信息,下载JDK。已开通对象存储OSS服务并创建存储空间(Bucket)。具体操作,请参见对象存储OSS快....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

文件存储HDFS版数据迁移相关内容

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版架构

- 文件存储HDFS版数据

- 文件存储HDFS版数据源

- 文件存储HDFS版集成

- 文件存储HDFS版数据集成

- 文件存储HDFS版功能

- 文件存储HDFS版文件

- 文件存储HDFS版下载

- 文件存储HDFS版文件夹

- 文件存储HDFS版自定义

- 文件存储HDFS版hadoop

- 文件存储HDFS版flink

- 文件存储HDFS版操作

- 文件存储HDFS版大数据

- 文件存储HDFS版集群

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版api

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版节点

- 文件存储HDFS版文件存储

- 文件存储HDFS版mapreduce

- 文件存储HDFS版配置

- 文件存储HDFS版报错

- 文件存储HDFS版namenode

- 文件存储HDFS版读取

- 文件存储HDFS版原理