大数据-108 Flink 快速应用案例 重回Hello WordCount!方案1批数据 方案2流数据(一)

点一下关注吧!!!非常感谢!!持续更新!!!目前已经更新到了:Hadoop(已更完)HDFS(已更完)MapReduce(已更完)Hive(已更完)Flume&...

大数据-108 Flink 快速应用案例 重回Hello WordCount!方案1批数据 方案2流数据(二)

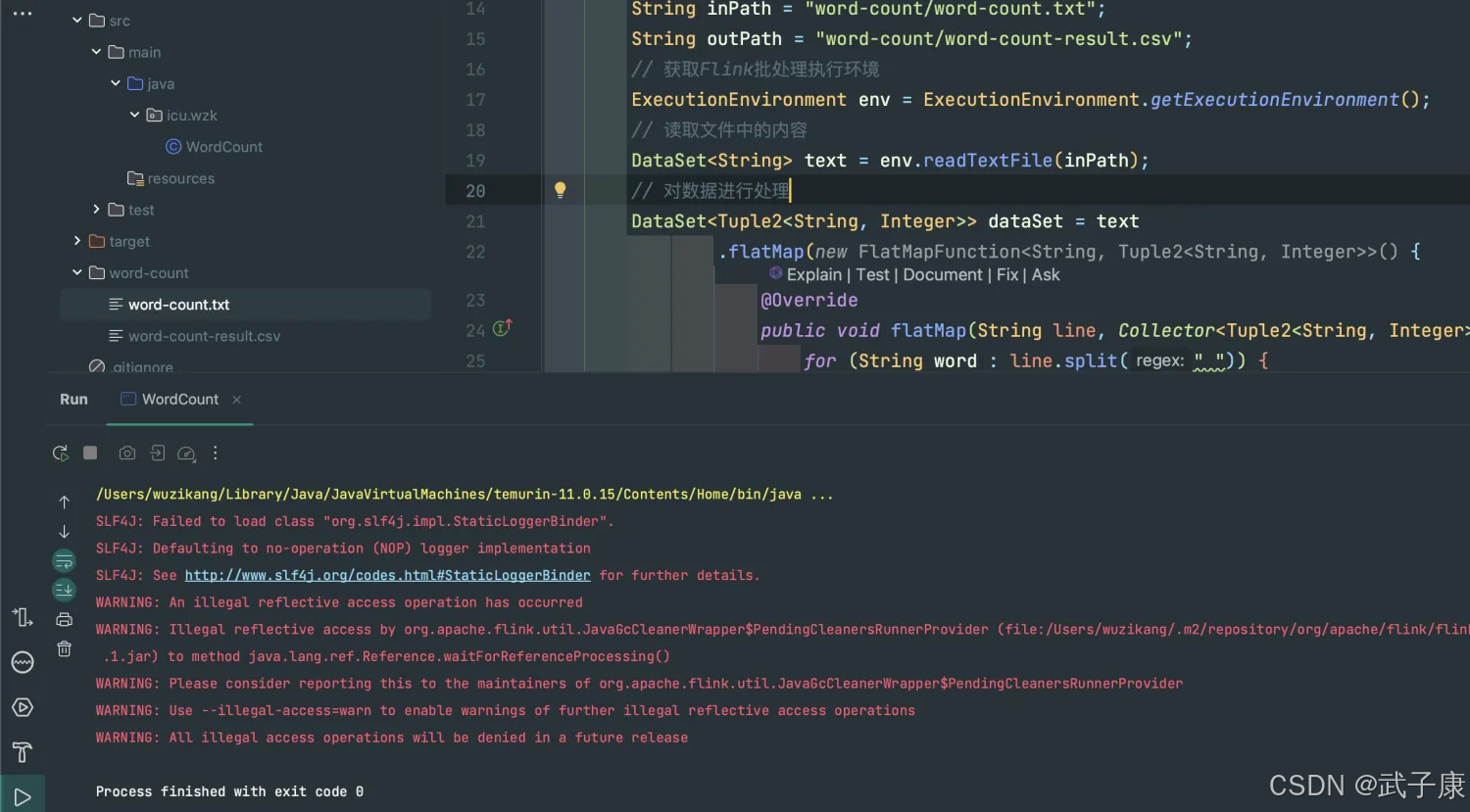

接上篇:https://developer.aliyun.com/article/1622681?spm=a2c6h.13148508.setting.17.27ab4f0ek8nPMY 运行测试 结果数据 查看 word-count/word-count-result.csv...

在Docker跑通Flink分布式版本的WordCount

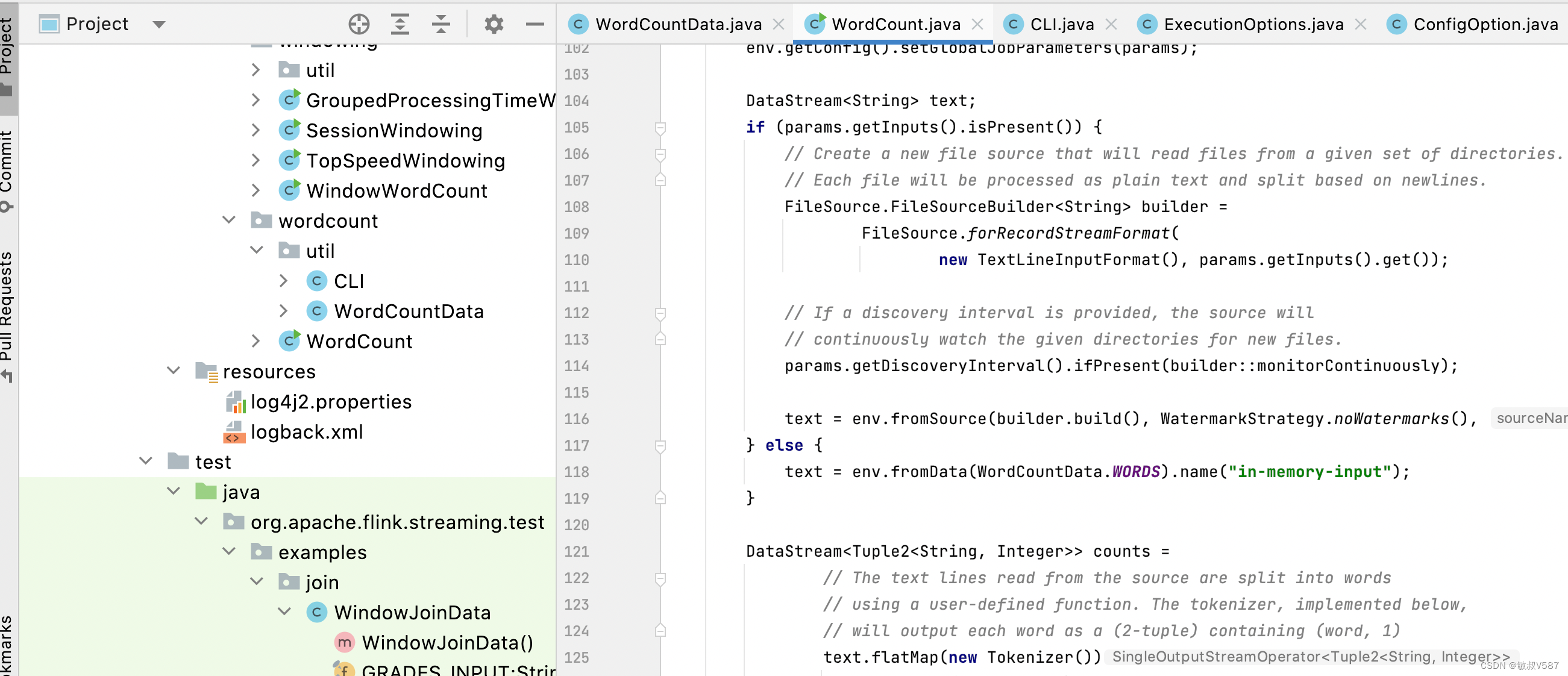

前言 前文我们介绍了,使用Docker快速部署Flink分布式集群,,这一把我们研究一下怎么自己撸一个WordCount上去跑起来。 官网例子的问题 大家发现我的风格或多或少是因为引导大家怎么去入门到熟悉的过程,所以我希望传递给大家一些学习的办法。我是比较大家直接看官网源码的例子的,而且官网刻意给出来本身也就是这个作用,WordCount非常重要,这是一个麻雀虽小五脏俱全...

Flink(一)【WordCount 快速入门】

前言 学完了 Hadoop、Spark,本想着先把 Kafka、Flume 这些工具先学完的,但想了想还是把核心的技术先学完最后再去把那些工具学学。 最近心有点累哈哈哈,偷偷立个 flag,反正也没人看,明年的今天来这里还愿哈,愿望这种事情我是从来是不会说出来的,毕竟言以泄败,事以密成嘛。那我隐晦低表达一下,摘录自《解忧杂货店》....

大神们,请教一个问题。我用flink1.16.1提交word count任务到yarn上,并行度是?

大神们,请教一个问题。我用flink1.16.1提交word count任务到yarn上,并行度是5。集群规模2.13T内存,255core(Hadoop3.3.0),只有一个默认队列,没有其他在跑的任务,后台也没其他耗资源的服务。第一个任务可以正常跑起来,第二个就一直created状态,日志一直打只能申请到3个cotainer?但是用Hadoop的example跑mr任务就能跑起来多个,感觉y....

想了解流计算,你必须得看一眼,实现Flink on Yarn的三种部署方式,并运行wordcount

1. 第一种方式:YARN session1.1 说明1.1.1 yarn-session.sh(开辟资源)+flink run(提交任务)这种模式下会启动yarn session,并且会启动Flink的两个必要服务:JobManager和Task-managers,然后你可以向集群提交作业。同一个Session中可以提交多个Flink作业。需要注意的是,这种模式下Hadoop的版本至少是2.2....

Flink 入门程序 WordCount 和 SQL 实现

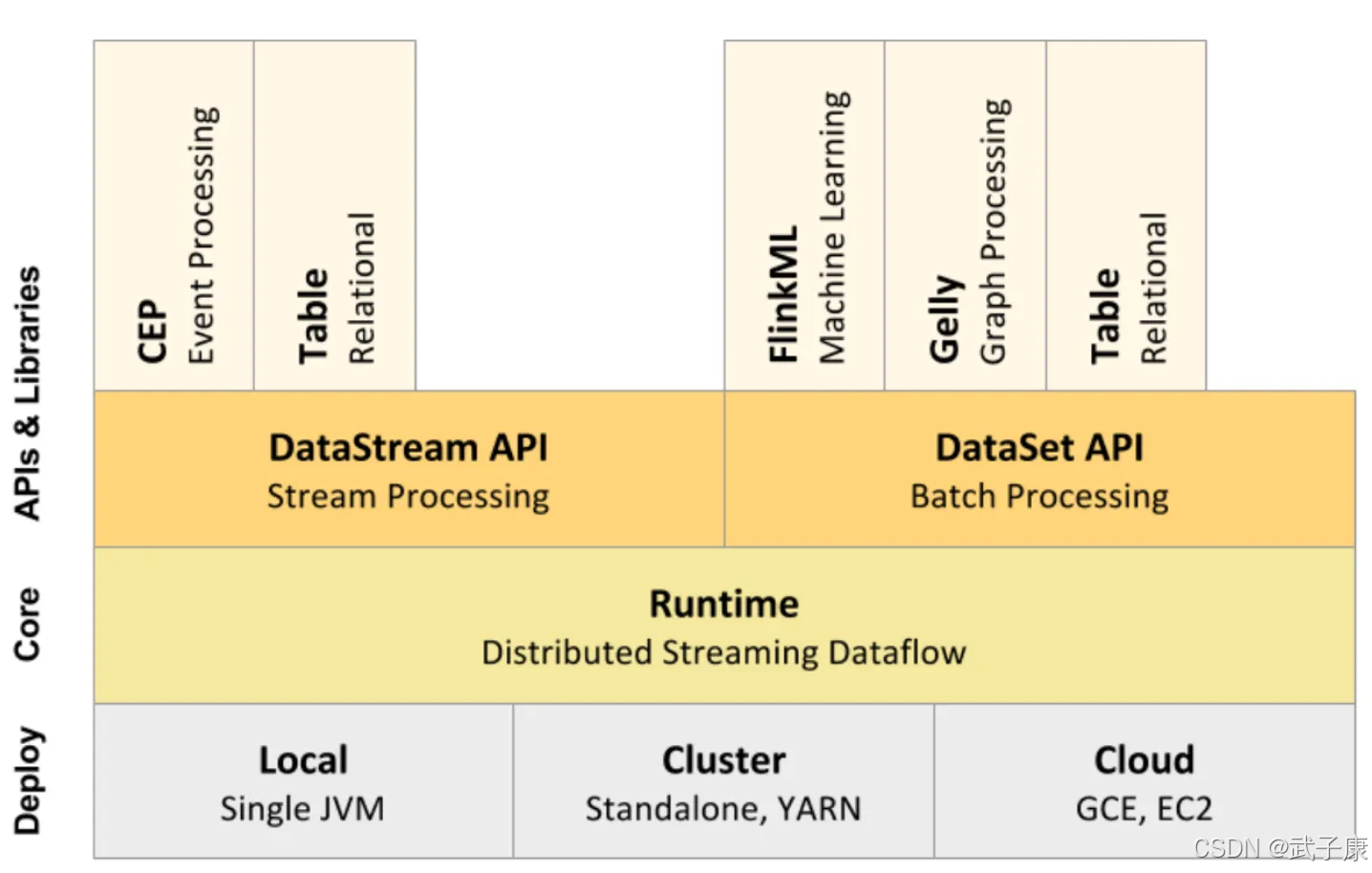

我们右键运行时相当于在本地启动了一个单机版本。生产中都是集群环境,并且是高可用的,生产上提交任务需要用到flink run 命令,指定必要的参数。本课时我们主要介绍 Flink 的入门程序以及 SQL 形式的实现。上一课时已经讲解了 Flink 的常用应用场景和架构模型设计,这一课时我们将会从一个最简单的 WordCount 案例作为切入点,并且同时使用 SQL 方式进行实现,为后面的实战课程打....

Flink1.7.2 local WordCount源码分析

Flink1.7.2 local WordCount源码分析 概述 Flink 环境 local,版本 Flink.1.7.2 用官网示例WordCount Scala程序分析源码 本文从source、operator、sink三个方面详细分析源码实现 时序图 https://github.com/opensourceteams/fink-maven-scala-2/blob/master/...

Spark Streaming和Flink的Word Count对比

准备: nccat for windows/linux 都可以 通过 TCP 套接字连接,从流数据中创建了一个 Spark DStream/ Flink DataSream, 然后进行处理, 时间窗口大小为10s 因为 示例需要, 所以 需要下载一个netcat, 来构造流的输入。 代码: spark streaming package cn.kee.spark; public...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版etl

- 实时计算 Flink版构建

- 实时计算 Flink版Table

- 实时计算 Flink版锁

- 实时计算 Flink版检查

- 实时计算 Flink版请求

- 实时计算 Flink版全量

- 实时计算 Flink版checkpoint

- 实时计算 Flink版重启

- 实时计算 Flink版任务

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版实时计算

- 实时计算 Flink版flink

- 实时计算 Flink版版本

- 实时计算 Flink版oracle

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行

实时计算 Flink

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

+关注