06-PDI(Kettle)读取Hive写入HDFS,读取HDFS写入HBase中(下)

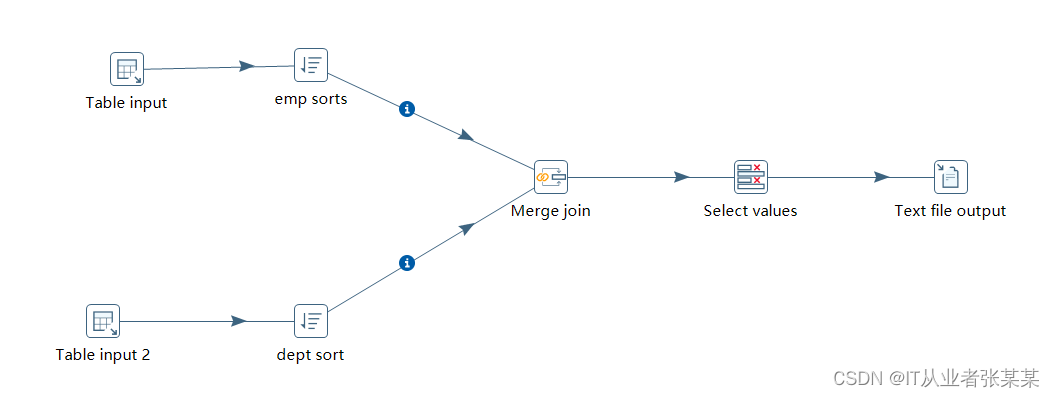

2.读取hive写入HDFS2.1工作流设计工作流设计:2.2 具体转换设计具体步骤项如下:1)table input 步骤项设置本步骤用于链接hive中的emp表,hive数据库链接如下:数据库操作sql语句如下:2)emp sorts 步骤项设置本步骤用于对hive中的数据进行排序:3)table input 2 步骤项设置本步骤用于链接hive中的dept表,hive数据库链接如下:4)d....

06-PDI(Kettle)读取Hive写入HDFS,读取HDFS写入HBase中(上)

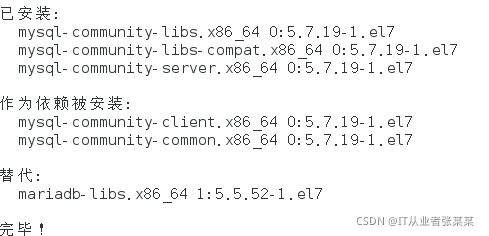

06-PDI(Kettle)读取Hive写入HDFS,读取HDFS写入HBase中本文主要通过Kettle完成对Hive和HBase中数据的读写工作,为了便于按照文档即可实现Kettle的读写Hive和HBase,文本前面也介绍下Hive的安装过程,如何Hive已经完成安装,可跳过前面即可。实验环境:cetnos7.4环境准备1.安装MySQL1.1mysql安装参考:centos7下使用mys....

Spark 入门_读取 HDFS 上的文件|学习笔记

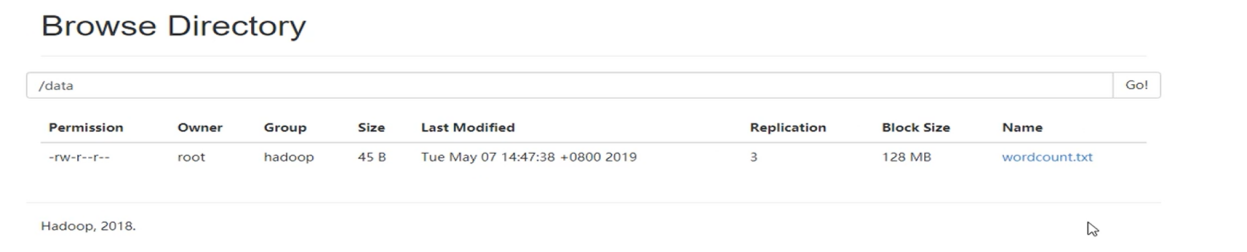

开发者学堂课程【大数据 Spark2020最新课程(知识精讲与实战演练)第一阶段:Spark 入门_读取 HDFS 上的文件】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/688/detail/11947Spark 入门_读取 HDFS 上的文件课题引入:Spark 是大型搜索引擎,需要处理大规模....

Flume 读取本地数据输出到 HDFS/Kafka

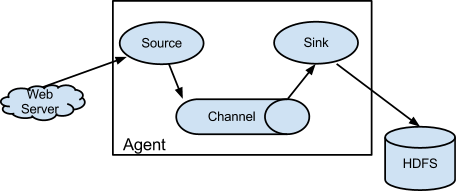

一、介绍Flume是一种分布式,可靠且可用的服务,用于有效地收集,聚合和移动大量日志数据。它具有基于流数据流的简单灵活的体系结构。它具有可调整的可靠性机制以及许多故障转移和恢复机制,具有强大的功能和容错能力。它使用一个简单的可扩展数据模型,允许在线分析应用程序。1.9.0版是Flume的第11版,是Apache顶级项目。Flume 1.9.0是稳定的,可立即投入生产的软件,并且与Flume 1.....

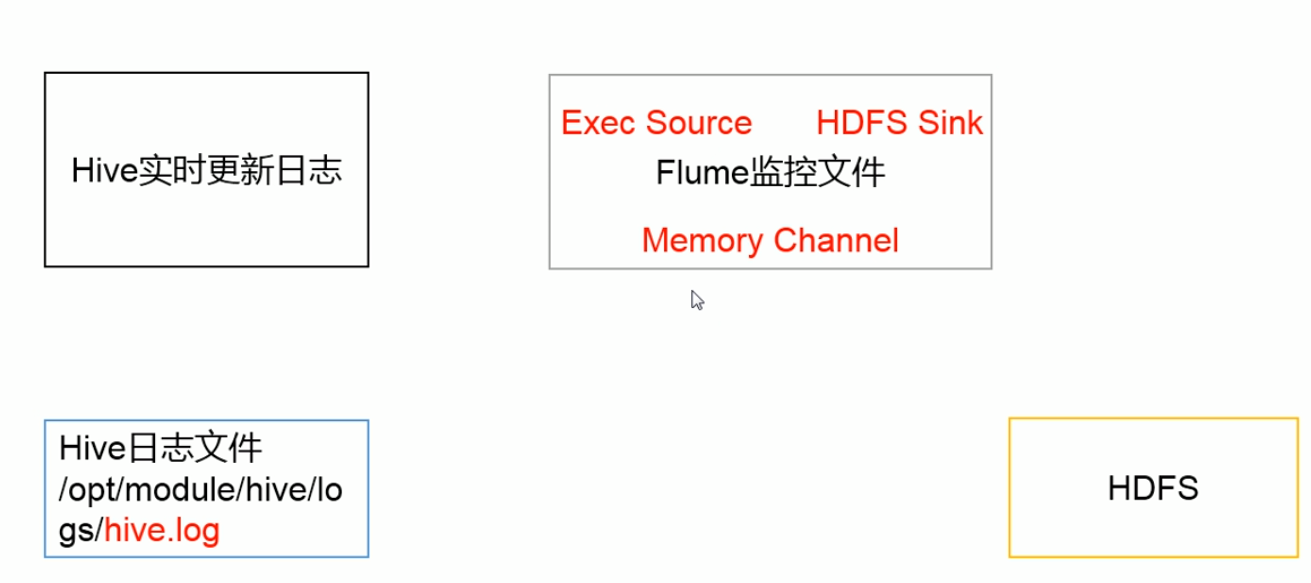

实时读取本地文件到 HDFS 案例分析 | 学习笔记

开发者学堂课程【数据采集系统 Flume :实时读取本地文件到 HDFS 案例分析】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/99/detail/1631实时读取本地文件到 HDFS 案例分析1. 案例需求:实时监控 Hive 日志,饼上传到 HDFS 中。2.需求分析3.实时读取本地文件到 ....

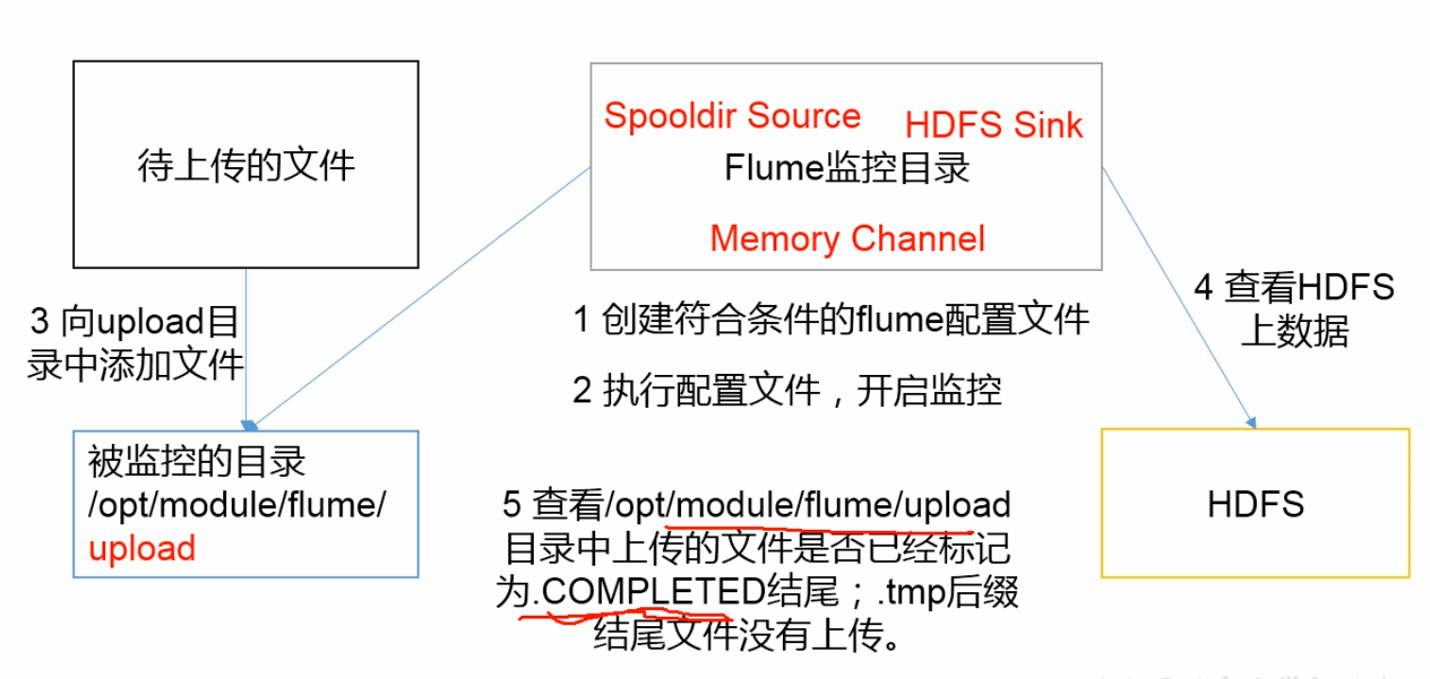

实时读取目录文件到 HDFS 案例分析 | 学习笔记

开发者学堂课程【数据采集系统 Flume 快速入门:实时读取目录文件到 HDFS 案例分析】学习笔记,与课程紧密联系,让用户快速学习知识。课程地址:https://developer.aliyun.com/learning/course/99/detail/1633实时读取目录文件到 HDFS 案例分析(1)实例需求:使用 Flume 监听整个目录的文件(2)需求分析:使用情况:log 和目录里....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版架构

- 文件存储HDFS版数据

- 文件存储HDFS版数据源

- 文件存储HDFS版集成

- 文件存储HDFS版数据集成

- 文件存储HDFS版功能

- 文件存储HDFS版文件

- 文件存储HDFS版下载

- 文件存储HDFS版文件夹

- 文件存储HDFS版自定义

- 文件存储HDFS版hadoop

- 文件存储HDFS版flink

- 文件存储HDFS版操作

- 文件存储HDFS版大数据

- 文件存储HDFS版集群

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版api

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版节点

- 文件存储HDFS版文件存储

- 文件存储HDFS版mapreduce

- 文件存储HDFS版配置

- 文件存储HDFS版报错

- 文件存储HDFS版namenode

- 文件存储HDFS版原理

- 文件存储HDFS版访问