在PyTorch中使用Seq2Seq构建的神经机器翻译模型(三)

9.Seq2Seq(编码器+解码器)代码实现classSeq2Seq(nn.Module): def__init__(self, Encoder_LSTM, Decoder_LSTM): super(Seq2Seq, self).__init__() self.Encoder_LSTM=Encoder_LSTMself.Decoder_LSTM=Decoder_LSTMdefforward(se....

在PyTorch中使用Seq2Seq构建的神经机器翻译模型(二)

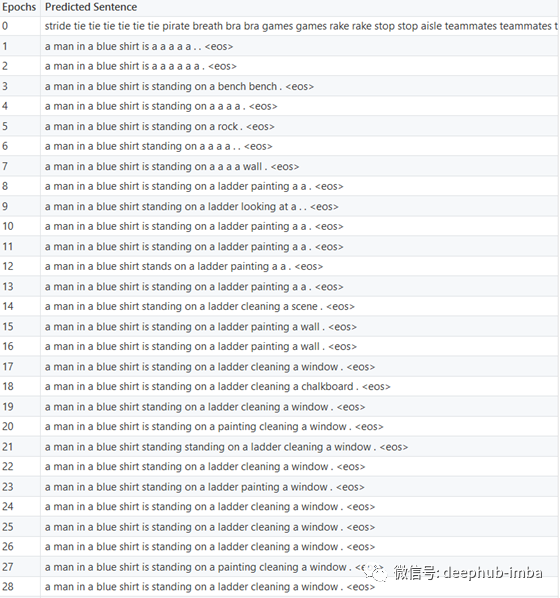

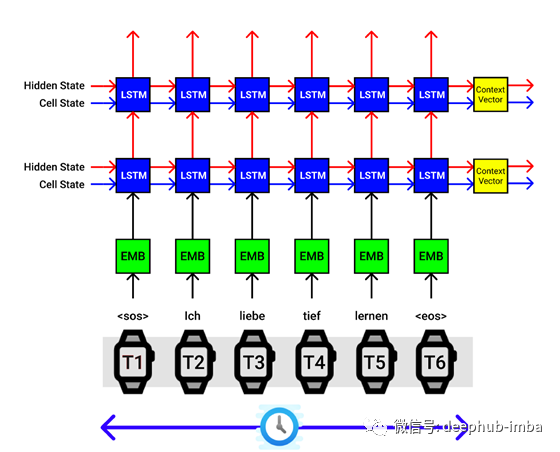

4.编码器模型架构(Seq2Seq)在开始构建seq2seq模型之前,我们需要创建一个Encoder,Decoder,并在seq2seq模型中创建它们之间的接口。让我们通过德语输入序列“ Ich Liebe Tief Lernen”,该序列翻译成英语“ I love deep learning”。LSTM编码器体系结构。X轴对应于时间步长,Y轴对应于批量大小为了便于说明,让我们解释上图中的过程。....

在PyTorch中使用Seq2Seq构建的神经机器翻译模型

1.介绍神经机器翻译(NMT)是一种机器翻译方法,它使用人工神经网络来预测一个单词序列的可能性,通常在一个单一的集成模型中建模整个句子。对于计算机来说,用一个简单的基于规则的系统从一种语言转换成另一种语言是最困难的问题之一,因为它们无法捕捉到过程中的细微差别。不久之后,我们开始使用统计模型,但在进入深度学习之后,这个领域被统称为神经机器翻译,现在已经取得了最先进的成果。这篇文章是针对于初学者的,....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。