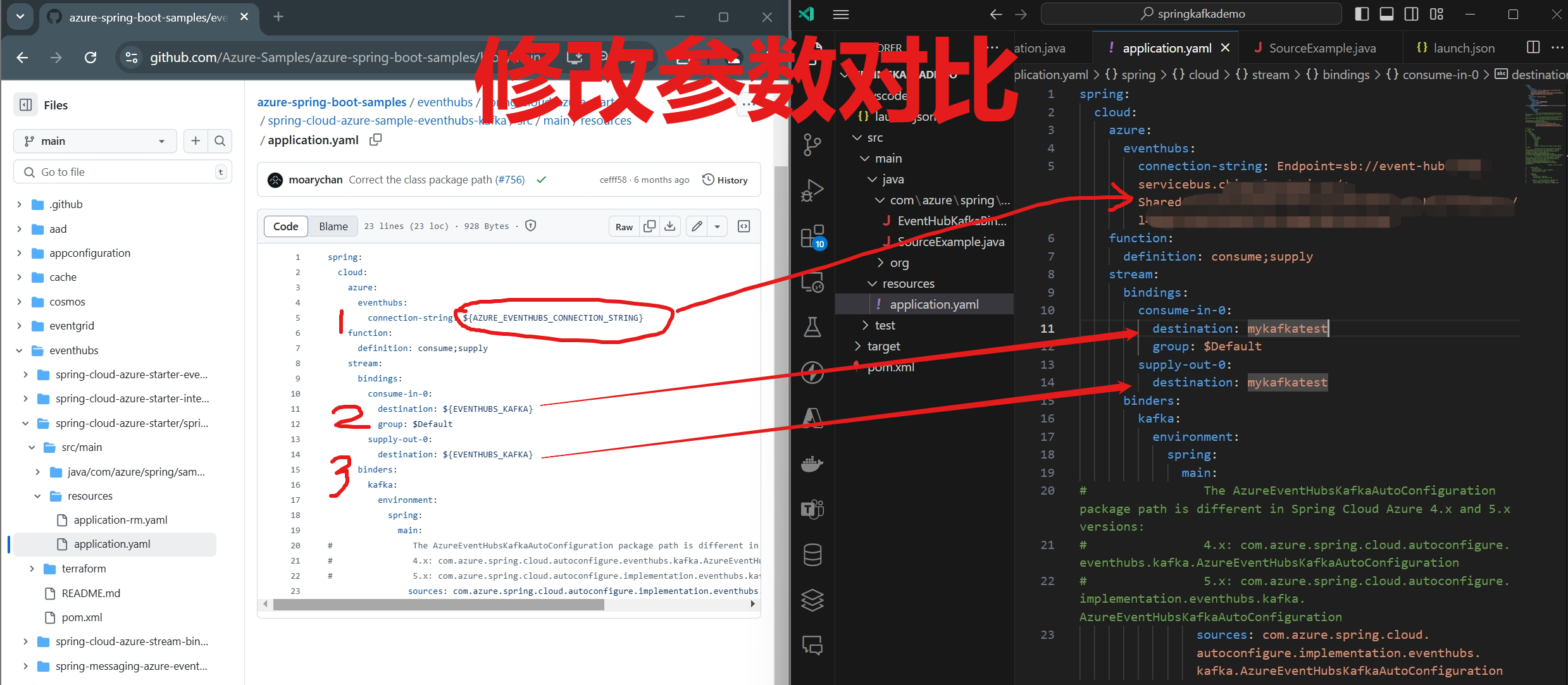

【Azure Kafka】使用Spring Cloud Stream Binder Kafka 发送并接收 Event Hub 消息及解决并发报错

问题描述 根据 Spring Cloud Stream Binder Kafka 发送消息/接收消息的代码示例,只需要配置好 application.yaml 中的 event hub connection string, Event Hub Name就可以正常运行并查看执行结果。 但...

添加预警联系人接收风险通知

云消息队列 Kafka 版实例预警通知默认会发送给所属阿里云账号拥有人。如果阿里云账号拥有人不是实际的运维人员或者开发人员,将无法及时处理异常。Kafka提供预警联系人功能,支持添加联系人并将预警信息通过短信、钉钉和Webhook等方式发送给联系人。

我的也是flink1.7 连接kafka,接收kafka数据,不知道有啥影响?

我的也是flink1.7 连接kafka,接收kafka数据,周期性提示org.apache.kafka.clients.NetworkClient [] - [Consumer clientId=20000-5, groupId=20000] Node -1 disconnected.,不知道有啥影响?

Flink CDC两台服务器传输数据,在sink端部署kafka接收数据,是否可行?

问题1:Flink CDC两台服务器传输数据,相互间无法访问对方的数据库,但服务器ip可以ping通,无法使用flink sql模式同步如果我在source端使用flink cdc捕获数据,在sink端部署kafka接收数据,是否可行?类似于这种模式?问题2:采用这种模式?source端使用debezium解析日志,传输到kafka中,sink使用flink接收数据?

Logstash接收Kafka数据写入至ES

1 Kafka数据写入至ES方式Kafka->logstash->elasticsearch->kibana(简单,只需启动一个代理程序)根据以上情况,项目决定采用方案一将Kafka中的数据存入到elasticsearch中去。项目拓扑图如下所示:此时消息的整体流向为:日志/消息整体流向Flume => kafka => logstash => elastic....

在 PyFlink 1.13.3 中接收 Kafka 消息

要在 PyFlink 1.13.3 中接收 Kafka 消息并进行流处理,然后将最终结果写入数据库,可以按照以下步骤进行操作: 安装 PyFlink 和相关依赖: pip install apache-flink==1.13.3 编写 PyFlink 程序代码:创建一个新的 Python 脚本,...

Flink CDC中我一个流作业kafka接收到的一个表数据想跟一个固定数据集做关联 该怎么做?

Flink CDC中我一个流作业里面 我从kafka接收到的一个表数据 想跟一个固定数据集做关联 该怎么做呢 ?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版下载

- 云消息队列 Kafka 版迁移

- 云消息队列 Kafka 版教程

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版幂等

- 云消息队列 Kafka 版语义

- 云消息队列 Kafka 版once

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版数据

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版日志

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析

- 云消息队列 Kafka 版java

- 云消息队列 Kafka 版入门

云消息队列

涵盖 RocketMQ、Kafka、RabbitMQ、MQTT、轻量消息队列(原MNS) 的消息队列产品体系,全系产品 Serverless 化。RocketMQ 一站式学习:https://rocketmq.io/

+关注