大数据-163 Apache Kylin 全量增量Cube的构建 手动触发合并 JDBC 操作 Scala

点一下关注吧!!!非常感谢!!持续更新!!! 目前已经更新到了: Hadoop(已更完) HDFS(已更完) MapReduce(已更完) Hive(已更完) Flume(已更完) Sqoop(已更完) Zookeeper(已更完) HBase(已更完) Redis (已更完) Kafka(已更完) ...

大数据-162 Apache Kylin 全量增量Cube的构建 Segment 超详细记录 多图

点一下关注吧!!!非常感谢!!持续更新!!! 目前已经更新到了: Hadoop(已更完) HDFS(已更完) MapReduce(已更完) Hive(已更完) Flume(已更完) Sqoop(已更完) Zookeeper(已更完) HBase(已更完) Redis (已更完) Kafka(已更完) ...

Uber基于Apache Hudi增量 ETL 构建大规模数据湖

Uber 的全球数据仓库团队使用统一的、 PB 级、集中建模的数据湖使所有 Uber 的数据民主化。数据湖由使用维度数据建模技术[1]开发的基础事实、维度和聚合表组成,工程师和数据科学家可以自助方式访问这些表,为 Uber 的数据工程、数据科学、机器学习和报告提供支持。因此,计算这些表的 ETL(提取、转换、加载)管道对 Uber 的应用程序和服务至关重要,为乘客安全、ETA 预测、欺诈检测等核....

基于 Apache Flink Table Store 的全增量一体实时入湖

作者|陈婧敏本文简要回顾了数据入湖(仓)的发展阶段,针对在数据库数据入湖中面临的问题,提出了使用 Flink Table Store 作为全增量一体入湖的解决方案,并辅以开源 Demo 的测试结果作为展示。文章主要内容包括:数据库数据集成入湖(仓)的发展阶段及面临痛点基于 Apache Flink Table Store 解决全增量一体入湖总结与展...

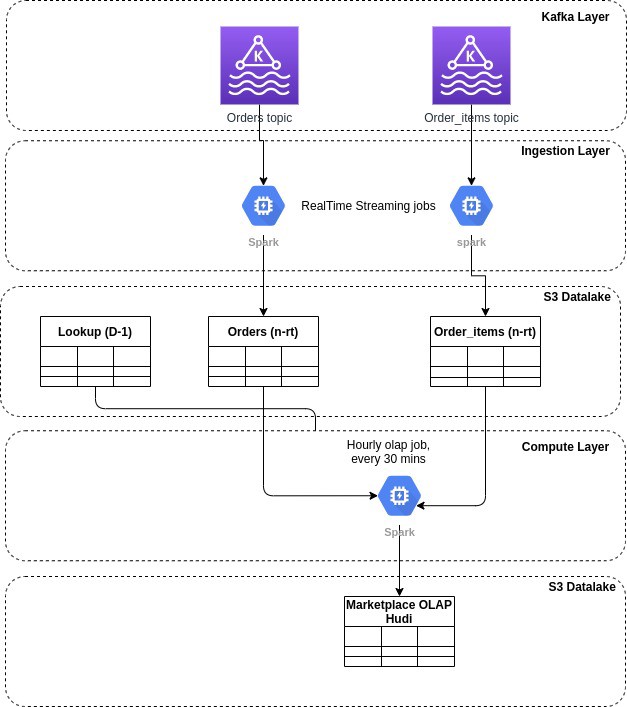

基于 Apache Hudi 构建增量和无限回放事件流的 OLAP 平台

1. 摘要在本博客中,我们将讨论在构建流数据平台时如何利用 Hudi 的两个最令人难以置信的能力。增量消费--每 30 分钟处理一次数据,并在我们的组织内构建每小时级别的OLAP平台事件流的无限回放--利用 Hudi 的提交时间线在超级便宜的云对象存储(如 AWS S3)中存储 10 天的事件流(想象一个具有 10 天保留期的 kafka 主题)具有部分记录更新的自定义 Hudi Payload....

Apache Flink - 增量检查点 - CP的意外大小

"是什么原因导致一些CP节省了预期的大小(大约500kB),有些CP的大小在整个当前管理状态大小附近,即使负载是恒定的?使用增量检查点时,lastCheckpointSize指标的确切测量结果是什么?"

Apache Kylin权威指南3.3 触发增量构建

3.3 触发增量构建 3.3.1 Web GUI触发 在Web GUI上触发Cube的增量构建与触发全量构建的方式基本相同。在Web GUI的Model页面中,选中想要增量构建的Cube,单击Action→Build,如图3-3所示。 不同于全量构建,增量构建的Cube会在此时弹出对话框让用户选择“End Date”(如 图3-4所示),目前Kylin要求增量Segment的起始时间等于Cub.....

Apache Kylin权威指南3.2 设计增量Cube

3.2 设计增量Cube 3.2.1 设计增量Cube的前提 并非所有的Cube都适用于增量构建,Cube的定义必须包含一个时间维度,用来分割不同的Segment,我们将这样的维度称为分割时间列(Partition Date Column)。尽管由于历史原因该命名中存在“date”的字样,但是分割时间列既可以是Hive中的Date类型、也可以是Timestamp类型或String类型。无论是哪.....

Apache Kylin权威指南3.1 为什么要增量构建

第3章 增量?构建 第2章介绍了如何构建Cube并利用其完成在线多维分析的查询。每次Cube的构建都会从Hive中批量读取数据,而对于大多数业务场景来说,Hive中的数据处于不断增长的状态。为了支持Cube中的数据能够不断地得到更新,且无需重复地为已经处理过的历史数据构建Cube,因此对于Cube引入了增量构建的功能。 我们将Cube划分为多个Segment,每个Segment用起始时间和结束时....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Apache您可能感兴趣

- Apache iceberg

- Apache数据湖

- Apache性能

- Apache调优

- Apache孵化器

- Apache meetup

- Apache阿里云

- Apache doris

- Apache日志

- Apache技术

- Apache flink

- Apache配置

- Apache rocketmq

- Apache安装

- Apache php

- Apache dubbo

- Apache tomcat

- Apache服务器

- Apache linux

- Apache spark

- Apache开发

- Apache服务

- Apache报错

- Apache mysql

- Apache微服务

- Apache访问

- Apache kafka

- Apache从入门到精通

- Apache hudi

- Apache实践

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注