在DMS中是否有单独执行Spark SQL预览查询结果的功能,而不是执行整个任务并写入表?

在DMS中是否有单独执行Spark SQL预览查询结果的功能,而不是执行整个任务并写入表?

云数据仓库ADB中dms任务编排中spark开发,spark能不能集成adb直接读里面的表?

云数据仓库ADB中dms任务编排中spark开发,spark能不能集成adb直接读里面的表,类似spark on hive?

请问spark引擎是可以直接访问大数据计算MaxCompute表的么?

请问spark引擎是可以直接访问大数据计算MaxCompute表的么?我尝试了spark2.3也不行

请问大数据计算MaxCompute spark引擎为什么读不到maxcompute上面的表呢?

请问大数据计算MaxCompute spark引擎为什么读不到maxcompute上面的表呢?是我漏配置了什么参数么?

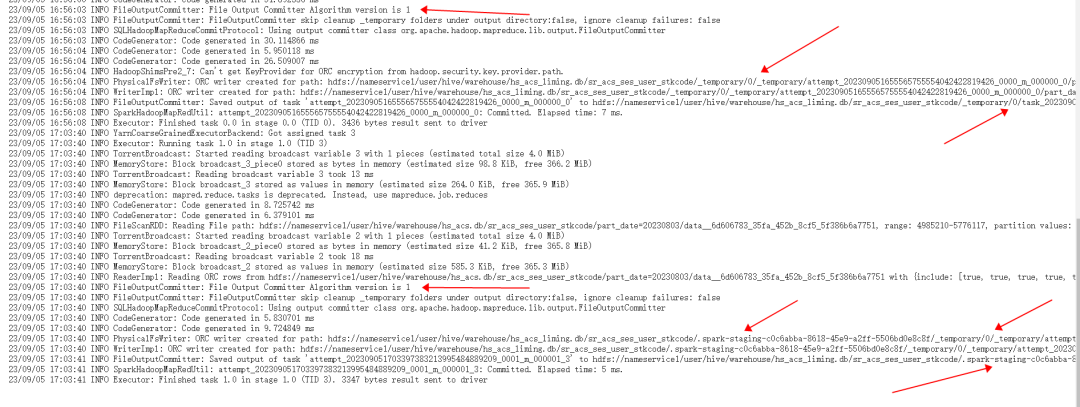

聊聊 Spark 作业的 commit 提交机制 - Spark并发更新ORC表失败的问题原因与解决方法

1 问题现象多个Spark 作业并发更新同一张ORC表时,部分作业可能会因为某些临时文件不存在而失败退出,典型报错日志如下:org.apache.spark.SparkException: Job aborted. Caused by: java.io.FileNotFoundException: File hdfs://kxc-cluster/user/hive/warehouse/hstes....

DataWorks使用spark读取maxcomputer的表进行count的时候为什么报错?

DataWorks使用spark读取maxcomputer的表进行count的时候为什么报错,unsupported type?

为什么 DataWorks ODPS spark pyspark 查询不到表。提示table不存在?

为什么 DataWorks ODPS spark pyspark 查询不到表。提示table不存在?

spark写入hudi表时同步创建hive表映射,结果hive是张空表,查询不到数据

##一、版本 hudi-0.12.0,spark-3.1.2,hadoop-3.3.0 ##二、问题描述 ###目的: 使用spark-shell,创建一些数据,写入hudi表,写入的同时同步给hive,将数据映射为hive表,实现hudi和hive的双写; ###结果: 能成功的创建hive表,但是张空表,查询不出数据;但是使用sparkSQL查询反而正常; 三、spark-shell hud....

SQL、Pandas和Spark:如何实现数据透视表?

01 数据透视表简介数据透视表,顾名思义,就是通过对数据执行一定的"透视",完成对复杂数据的分析统计功能,常常伴随降维的效果。例如在Excel工具栏数据透视表选项卡中通过悬浮鼠标可以看到这样的描述:在上述简介中,有两个关键词值得注意:排列和汇总,其中汇总意味着要产生聚合统计,即groupby操作;排列则实际上隐含着使汇总后的结果有序。当然,如果说只实现这两个需求还不能完全表达出数据透视表与常规的....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark您可能感兴趣

- apache spark技术

- apache spark大数据

- apache spark优先级

- apache spark batch

- apache spark客户端

- apache spark任务

- apache spark调度

- apache spark yarn

- apache spark作业

- apache spark Hive

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark rdd

- apache spark MaxCompute

- apache spark集群

- apache spark运行

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark机器学习

- apache spark应用

- apache spark实战

- apache spark操作

- apache spark程序

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注