Flink1.15.4 flinksql CDC设置TTL问题?

Flink1.15.4 中利用flinksql CDC同步mysql数据到kafka中,一旦sql中使用SET 'table.exec.state.ttl' = '48h' 后,手动停止任务,再通过checkpoint/savepoint恢复,还是从头在同步数据到upsert-kafka中,请问是什么原因?难道设置TTL后,就恢复job后就无法增量同步数据吗?状态后端为rocksdb,flink....

实时计算 Flink版产品使用合集之不设置ttl会导致ckp越来越大,设置了会丢失数据如何解决

问题一:Flink CDC中mysql cdc connector是否支持自定义deserializer? Flink CDC中mysql cdc connector是否支持自定义deserializer。我看官网2.4版本貌似不支持? 参考回答: 支持,datastream支持的 关于本问题的更多回答可点击原文查看:https://...

在Flink如果lag能够正常使用的话,lag函数里面的数据是不是也随着状态的ttl过期?

在Flink如果lag能够正常使用的话,lag函数里面的数据是不是也随着状态的ttl过期?过期后会导致数据无法正确的找到上一条?

Flink CDC 中ttl是不是只在有开窗时候有效,我这个作业只是简单的同步?

Flink CDC 中ttl只在有开窗时候有效,试过用rocketsdb解决这个问题,但我看rocksdb模式也会占用不小的文件空间;也尝试过设置tableEnv.getConfig().setIdleStateRetention,但是没效果,不知道ttl是不是这样设置呢?

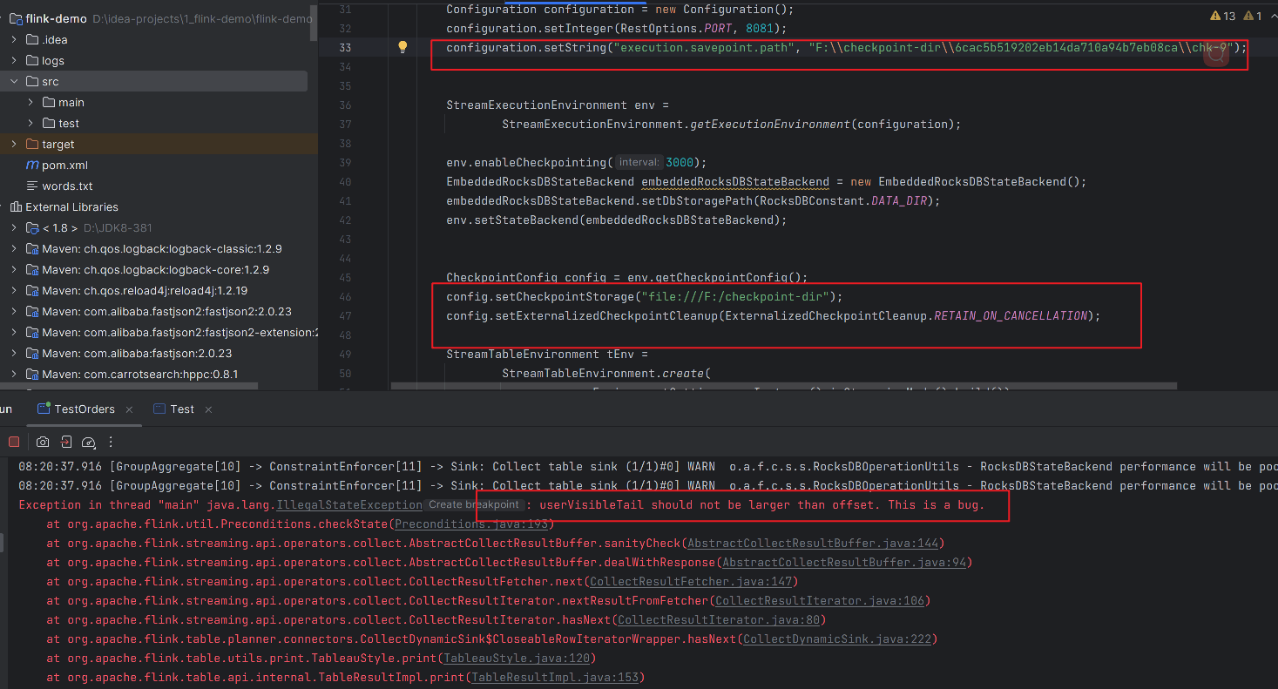

Flink CDC里 rocksdb 全量checkpoint开启了ttl,为什么文件还会增大?

Flink CDC里 rocksdb 全量checkpoint开启了ttl,为什么checkpoint文件还持续增大 ?

Flink cdc增量同步的时候,我可以设置ttl进行内存释放,那全量同步的时候怎么实现内存的释放?

Flink cdc增量同步的时候,我可以设置ttl进行内存释放,那全量同步的时候怎么实现内存的释放?我一次同步多张表。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版ttl相关内容

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版湖仓

- 实时计算 Flink版starrocks

- 实时计算 Flink版实践

- 实时计算 Flink版空间

- 实时计算 Flink版TaskManager

- 实时计算 Flink版文件

- 实时计算 Flink版checkpoint

- 实时计算 Flink版编译

- 实时计算 Flink版架构

- 实时计算 Flink版任务

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版flink

- 实时计算 Flink版实时计算

- 实时计算 Flink版版本

- 实时计算 Flink版oracle

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行