Spark Streaming之checkpoint机制

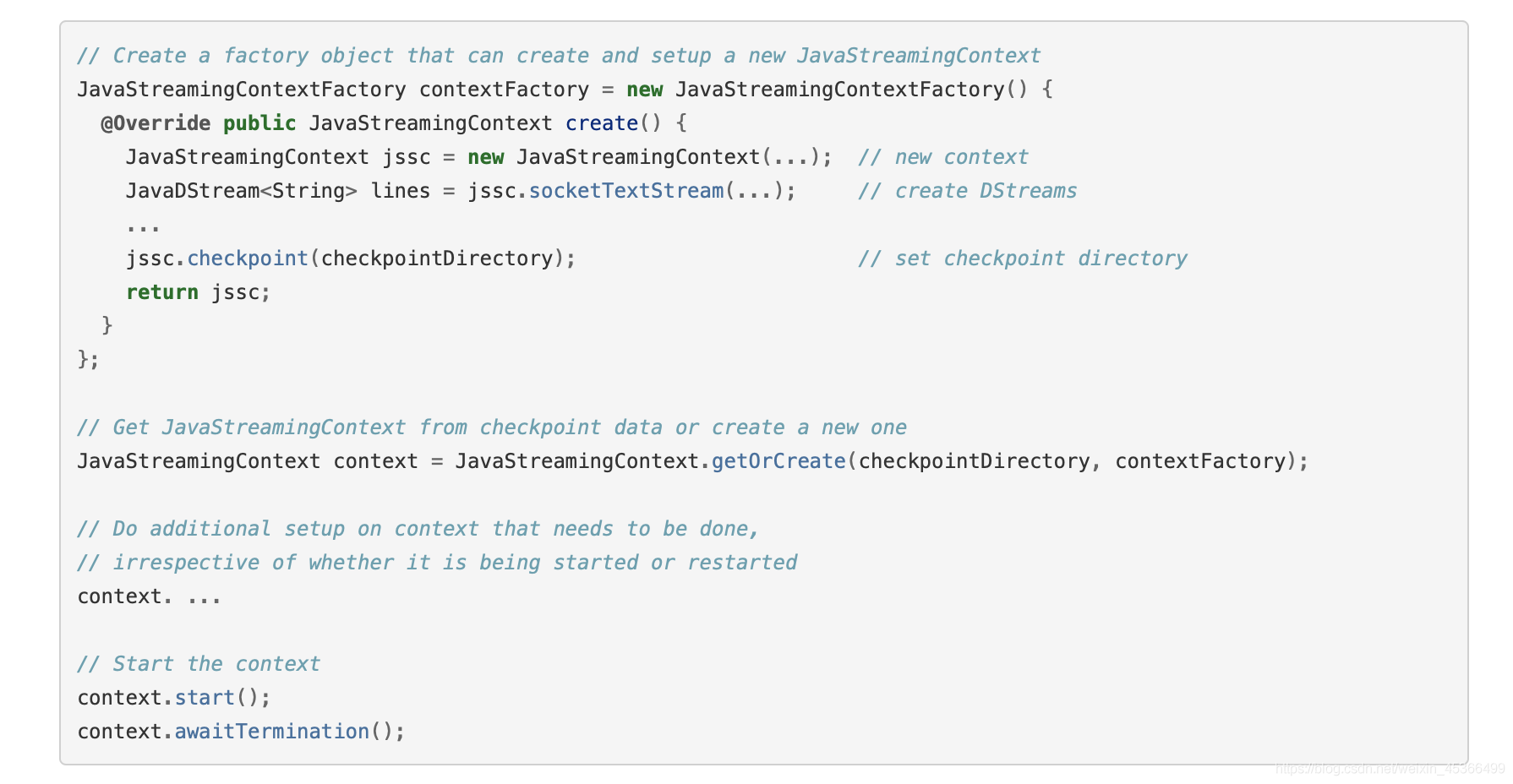

一、checkpoint机制每一个Spark Streaming应用,正常来说,都是要7 * 24小时运转的,这就是实时计算程序的特点。因为要持续 不断的对数据进行计算。因此,对实时计算应用的要求,应该是必须要能够对与应用程序逻辑无关的失败,进行 容错。如果要实现这个目标,Spark Streaming程序就必须将足够的信息checkpoint到容错的存储系统上,从而让它能 够从失败中进行恢复。....

Spark修炼之道(进阶篇)——Spark入门到精通:第十四节 Spark Streaming 缓存、Checkpoint机制

作者:周志湖 微信号:zhouzhihubeyond 主要内容 本节内容基于官方文档:http://spark.apache.org/docs/latest/streaming-programming-guide.html Spark Stream 缓存 Checkpoint 案例 1. Spark Stream 缓存 通过前面一系列的课程介绍,我们知道DStream是由一系列...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark您可能感兴趣

- apache spark安装

- apache spark日志

- apache spark分析

- apache spark应用

- apache spark OSS

- apache spark机制

- apache spark缓存

- apache spark rdd

- apache spark湖仓

- apache spark lakehouse

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark大数据

- apache spark MaxCompute

- apache spark集群

- apache spark运行

- apache spark任务

- apache spark summit

- apache spark模式

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark机器学习

- apache spark实战

- apache spark操作

- apache spark技术

- apache spark yarn

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注