Scala 文件 I/O

Scala 进行文件写操作,直接用的都是 java中 的 I/O 类 (java.io.File): 实例import java.io._ object Test { def main(args: Array[String]) { val writer = new PrintWriter(new File("test.txt...

scala 读取文件(中文)异常 thread "main" java.nio.charset.MalformedInputException: Input length = 1

scala 读取文件(中文)异常 thread "main" Source.fromFile java.nio.charset.MalformedInputException: Input length = 1 其实吧,就是你读取的文件中读取了中文。 ...

一天学完spark的Scala基础语法教程十三、文件IO操作(idea版本)

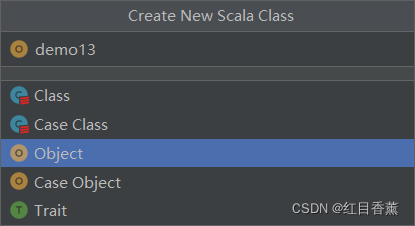

创建测试类【day1/demo13.scalc】,类型为【Object】Scala 文件 I/OScala 进行文件写操作,直接用的都是 java中 的 I/O 类 (java.io.File):package day1 import java.io.{File, PrintWriter} object demo13 { def main(args: Array[String]) { ...

Flink - 读取 Parquet 文件 By Scala / Java

一.引言parquet 文件常见与 Flink、Spark、Hive、Streamin、MapReduce 等大数据场景,通过列式存储和元数据存储的方式实现了高效的数据存储与检索,下面介绍 Flink 场景下如何读取 Parquet。Parquet 相关知识可以参考:Spark - 一文搞懂 parquet。编辑二.Parquet Read By Scala1.依赖准备与环境初始化import ....

scala 学习笔记(02) 元组Tuple、数组Array、Map、文件读写、网页抓取示例

package yjmyzz import java.io.PrintWriter import java.util.Date import scala.io.Source object ScalaApp02 { def main(args: Array[String]) { tupleDemo println mapDemo println ...

scala小工具:自动生成跑批文件

import scala.io.StdInimport java.time.format.DateTimeFormatterimport java.time.LocalDate._import java.io.PrintWriterimport java.time.LocalDateobject TestBasic { def main(args: Array[String]): Unit =.....

IntelliJ IDEA 无法编译scala文件问题?报错

因java项目中用到spark,引入部分scala代码,但是scala一直无法编译,导致一直编译报错,scala SBT 和 插件也已经安装. Maven 中也引入 scala-tools 编译插件.(本人只会java,不会scala).有没有人碰到过这种问题,请教该怎么设置?

大数据Scala系列之文件以及正则表达式

大数据Scala系列之文件以及正则表达式1 读取行导入scala.io.Source后,即可引用Source中的方法读取文件信息。 import scala.io.Sourceobject FileDemo extends App{ val source = Source.fromFile("C:/Users/admin/res.txt") //返回一个迭代器 val lines = sour.....

如何读取CSV文件,然后将其另存为Spark Scala中的JSON?

我正在尝试读取一个包含大约700万行和22列的CSV文件。如何在Spark Dataframe中读取CSV后将其另存为JSON文件?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Scala文件相关内容

开发与运维

集结各类场景实战经验,助你开发运维畅行无忧

+关注