Spark Day05:Spark Core之Sougou日志分析、外部数据源和共享变量

01-[了解]-内容回顾主要讲解:RDD函数,分为两类Transformation转换函数和Action触发函数。1、RDD函数类型 - 转换函数 当RDD调用转换函数,产生新的RDD lazy懒惰,不会立即执行 - 触发函数 当RDD调用Action函数,返回值不是RDD,要么没有返回值Unit,要么就是非RDD 立即执行 2、RDD 常用函数 - ...

Spark RDD高级应用(传参、闭包、共享变量)

0x00 教程内容向Spark传递参数的两种方式闭包的概念及实操共享变量的两种方式0x01 向Spark传递参数的方式Spark 中的大部分操作都依赖于用户传递的函数,主要有两种方式:方式一:匿名函数方式二:传入静态方法和传入方法的引用1. 匿名函数在前面的教程中,我们用到了很多次这种方式,如这句:val wordRDD = textFileRDD.flatMap(line => line....

Spark的共享变量(广播变量和累加器)底层实现

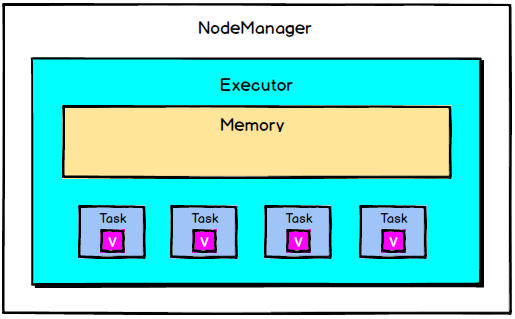

Spark一个非常重要的特性就是共享变量。默认情况下,如果在一个算子的函数中使用到了某个外部的变量,那么这个变量的值会被拷贝到每个task中,此时每个task只能操作自己的那份变量副本。如果多个task想要共享某个变量,那么这种方式是做不到的。Spark为此提供了两种共享变量,一种是Broadcast Variable(广播变量),另一种是Accumulator(累加变量)。Broadcast ....

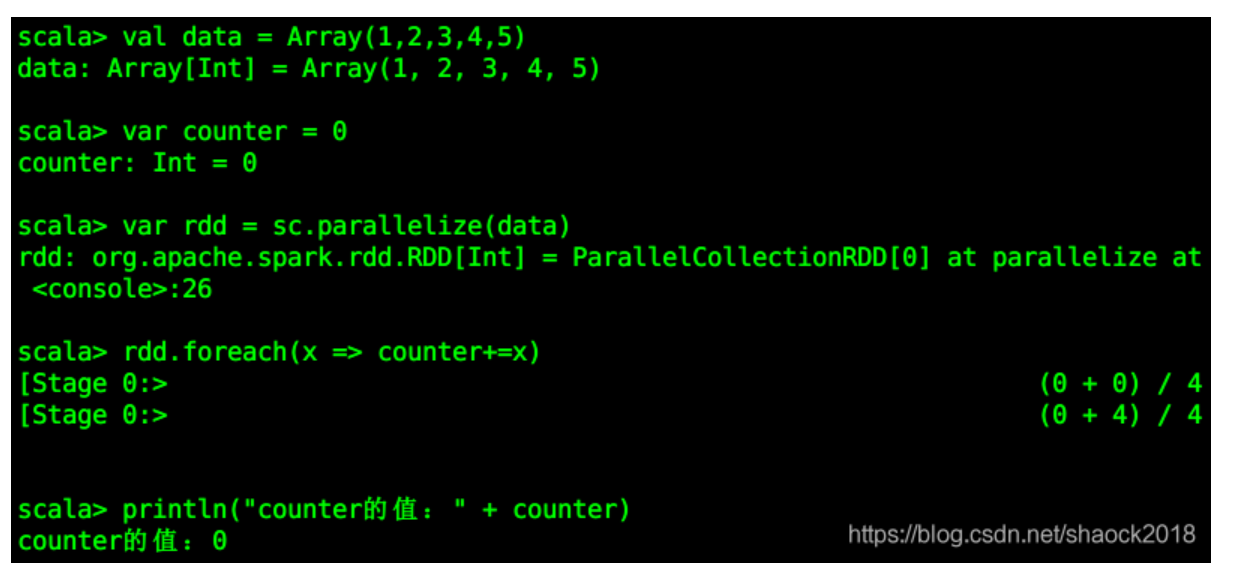

Spark踩坑记:共享变量

前言 前面总结的几篇spark踩坑博文中,我总结了自己在使用spark过程当中踩过的一些坑和经验。我们知道Spark是多机器集群部署的,分为Driver/Master/Worker,Master负责资源调度,Worker是不同的运算节点,由Master统一调度。 而Driver是我们提交Spark程序的节点,并且所有的reduce类型的操作都会汇总到Driver节点进行整合。节点之间会将map/....

《Spark大数据分析:核心概念、技术及实践》一3.9 共享变量

本节书摘来自华章出版社《Spark大数据分析:核心概念、技术及实践》一书中的第3章,第3.9节,作者[美] 穆罕默德·古勒(Mohammed Guller),更多章节内容可以访问云栖社区“华章计算机”公众号查看。 3.9 共享变量 Spark使用的架构是无共享的。数据分布在集群的各个节点上,每个节点都有自己的CPU、内存和存储资源。没有全局的内存空间用于任务间共享。驱动程序和...

Spark-神奇的共享变量

一般情况下,当一个 传递给 Spark 操作 ( 例如 map 和 reduce) 的函数在 远 程 节 点上面 运 行 时 ,Spark 操作 实际 上操作的是 这 个函数所用 变 量的一个独立副本。 这 些 变 量被复制到每台机器上,并且 这 些 变 量在 远 程机器上 的所有更新都不会 传递 回 驱动 程序。通常跨任 务 的 读 写 变 量是低效的,但是, Spark 还 是 ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark您可能感兴趣

- apache spark安装

- apache spark日志

- apache spark分析

- apache spark应用

- apache spark OSS

- apache spark机制

- apache spark缓存

- apache spark rdd

- apache spark湖仓

- apache spark lakehouse

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark大数据

- apache spark MaxCompute

- apache spark集群

- apache spark运行

- apache spark任务

- apache spark summit

- apache spark模式

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark机器学习

- apache spark实战

- apache spark操作

- apache spark技术

- apache spark yarn

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注