从零开始用Pytorch实现LLaMA 4的混合专家(MoE)模型

近期发布的LLaMA 4模型引入了混合专家(Mixture of Experts, MoE)架构,旨在提升模型效率和性能。尽管社区对LLaMA 4的实际表现存在一些讨论,但MoE作为一种重要的模型设计范式,继Mistral等模型之后再次受到关注。所以我们将使用Pytorch逐步从零开始实现一个简化版的LLaMA 4 MoE模型。通过详细的代码实现和解释,我们将深入理解MoE架构的关键组件及其工作....

使用PyTorch从零构建Llama 3

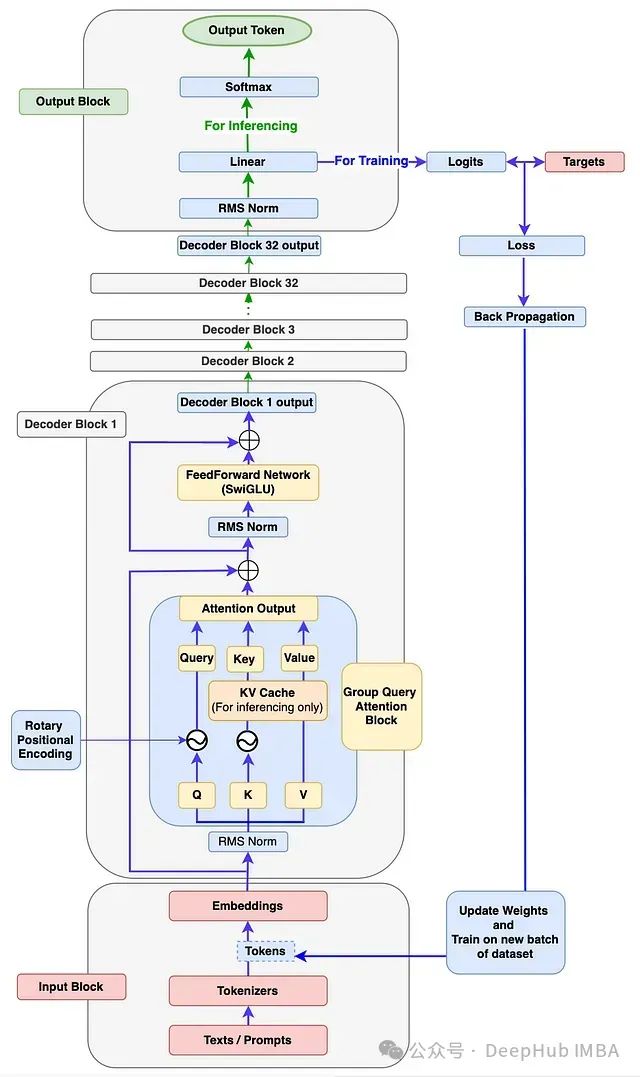

我们上次发了用PyTorch从零开始编写DeepSeek-V2的文章后,有小伙伴留言说希望介绍一下Llama 3。那么今天他就来了,本文将详细指导如何从零开始构建完整的Llama 3模型架构,并在自定义数据集上执行训练和推理。 [图1]:Llama 3架构展示训练和推理流程。因为官方Llama 3论文中未提供相关图表。所以此图为大概架构图...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

pytorch您可能感兴趣

- pytorch源码分析

- pytorch性能优化

- pytorch模型

- pytorch代码

- pytorch内存管理

- pytorch优化

- pytorch cuda

- pytorch内存

- pytorch gpu

- pytorch机制

- pytorch神经网络

- pytorch教程

- pytorch实战

- pytorch训练

- pytorch学习

- pytorch数据集

- pytorch tensorflow

- pytorch官方教程

- pytorch安装

- pytorch卷积

- pytorch构建

- pytorch卷积神经网络

- pytorch数据

- pytorch源码

- pytorch分类

- pytorch框架

- pytorch案例

- pytorch学习笔记

- pytorch版本

- pytorch张量