推理服务框架支持说明

Gateway with Inference Extension支持多种生成式AI推理服务框架,并为基于不同推理服务框架部署的生成式AI推理服务提供一致的能力,包括制定灰度发布策略、推理负载均衡、基于模型名称的路由等。本文介绍Gateway with Inference Extension对不同生成式AI推理服务框架的支持与使用方式。

使用ACK Gateway with Inference Extension实现生成式AI推理服务灰度发布

通过ACK Gateway with Inference Extension组件,您可以在生成式AI推理服务中实现更换、升级使用的基础模型或者对多个LoRA模型进行灰度更新,将服务中断的时间降至最低。本文介绍如何使用ACK Gateway with Inference Extension组件对生成式AI推理服务进行渐进式灰度发布。

使用ACK Gateway with Inference Extension实现生成式AI推理服务灰度发布

通过ACK Gateway with Inference Extension组件,您可以在生成式AI推理服务中实现更换、升级使用的基础模型或者对多个LoRA模型进行灰度更新,将服务中断的时间降至最低。本文介绍如何使用ACK Gateway with Inference Extension组件对生成式AI推理服务进行渐进式灰度发布。

使用ACK Gateway with Inference Extension实现推理服务的请求熔断

ACK Gateway with Inference Extension组件支持在开启推理服务智能负载均衡的同时配置熔断规则。当服务出现异常时,熔断机制可以自动切断有问题的服务连接,防止故障蔓延。本文介绍如何使用ACK Gateway with Inference Extension为推理服务配置流量熔断规则。

使用ACK Gateway with Inference Extension实现推理服务的流量镜像

ACK Gateway with Inference Extension组件在支持推理服务智能负载均衡的同时,也支持推理请求的流量镜像功能。在生产环境中部署新推理模型时,您可以通过流量镜像复制生产流量来评估新模型的表现,确保其性能和稳定性符合要求之后再正式上线。本文介绍如何使用ACK Gateway with Inference Extension来实现推理请求的流量镜像。

ACK Gateway with Inference Extension:优化多机分布式大模型推理服务实践

【阅读原文】戳:ACK Gateway with Inference Extension:优化多机分布式大模型推理服务实践 ACK Gateway with Inference Extension组件专为LLM推理场景设计,支持四层/七层流量路由,并提供基于模型服务器负载智能感知的负载均衡能力。此外,通过InferencePool和InferenceModel自定义资...

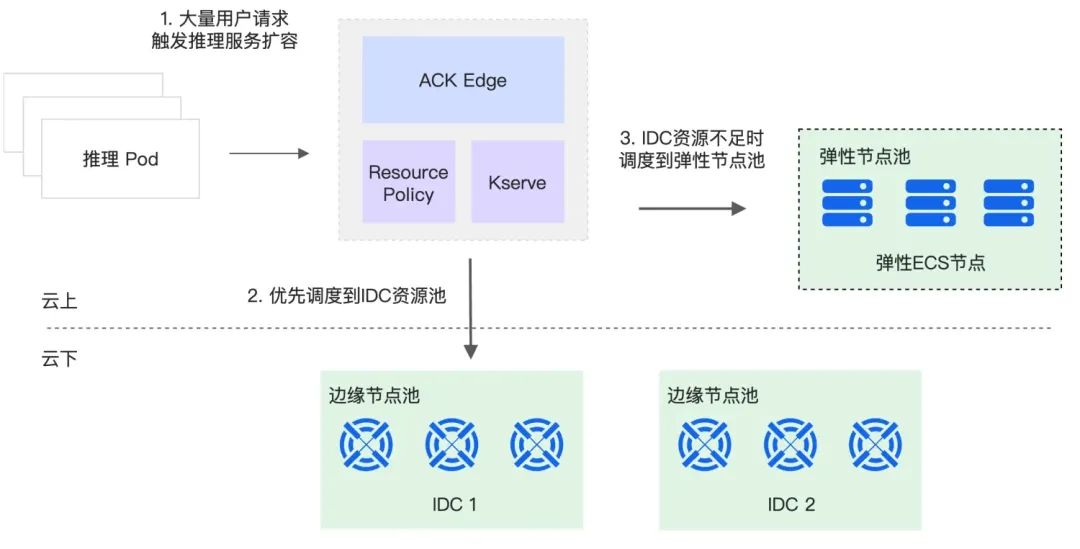

应对IDC资源紧缺:ACK Edge如何解决LLM推理服务的弹性挑战

背景 春节期间,国产大模型DeepSeek凭借其卓越的性能和创新能力在全球范围内迅速走红,引发了广泛的关注和讨论。然而,随着访问量的急剧攀升,其推理服务器资源很快变得捉襟见肘,最终不得不暂停API充值服务。这一系列事件让业界认识到,大语言模型(LLM)的推理业务正逐渐成为AI产业竞争的又一个至关重要的业务场景。 LLM推理业务的需求往往呈现出显著的潮汐流量特性...

应对IDC资源紧缺:ACK Edge如何解决LLM推理服务的弹性挑战

【阅读原文】戳:应对IDC资源紧缺:ACK Edge如何解决LLM推理服务的弹性挑战 背景 春节期间,国产大模型DeepSeek凭借其卓越的性能和创新能力在全球范围内迅速走红,引发了广泛的关注和讨论。然而,随着访问量的急剧攀升,其推理服务器资源很快变得捉襟见肘,最终不得不暂停API充值服务。这一...

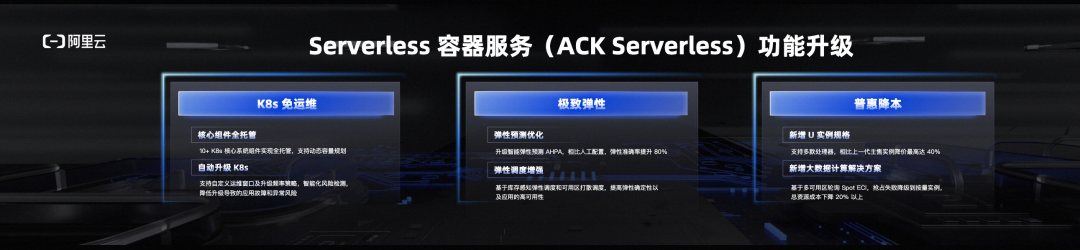

如何基于ACK Serverless快速部署AI推理服务

基于ACK Serverless(Alibaba Cloud Kubernetes Serverless Framework)快速部署AI推理服务的步骤如下: 创建函数计算服务: 在阿里云控制台,创建一个函数计算服务,用于托管AI推理服务的代码。编写AI推理代码: 使用适合的编程语言编写AI推理...

如何基于 ACK Serverless 快速部署 AI 推理服务

作者:元毅随着 AI 浪潮的到来,各种 AI 应用层出不穷,众所周知 AI 应用对 GPU 资源强烈依赖,但 GPU 很昂贵,如何降低 GPU 资源使用成本成为用户首要问题。而 AI 与 Serverless 技术结合,完全可以达到按需使用资源,降低资源成本的目的。那么在云原生场景下,是否有这样开箱即用、标准、开放的方案呢?答案是有。我们在 ACK Serverless 中提供 Knative ....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

容器服务Kubernetes版您可能感兴趣

- 容器服务Kubernetes版算力

- 容器服务Kubernetes版idc

- 容器服务Kubernetes版云端

- 容器服务Kubernetes版技术

- 容器服务Kubernetes版架构

- 容器服务Kubernetes版安全

- 容器服务Kubernetes版profiling

- 容器服务Kubernetes版ai

- 容器服务Kubernetes版部署

- 容器服务Kubernetes版serverless

- 容器服务Kubernetes版集群

- 容器服务Kubernetes版容器

- 容器服务Kubernetes版pod

- 容器服务Kubernetes版应用

- 容器服务Kubernetes版云原生

- 容器服务Kubernetes版服务

- 容器服务Kubernetes版阿里云

- 容器服务Kubernetes版 Pod

- 容器服务Kubernetes版docker

- 容器服务Kubernetes版k8s

- 容器服务Kubernetes版 Docker

- 容器服务Kubernetes版kubernetes

- 容器服务Kubernetes版节点

- 容器服务Kubernetes版安装

- 容器服务Kubernetes版 K8S

- 容器服务Kubernetes版实践

- 容器服务Kubernetes版配置

- 容器服务Kubernetes版网络

- 容器服务Kubernetes版资源

- 容器服务Kubernetes版 kubernetes