AccessKey网络访问限制策略

通过AccessKey网络访问限制策略,限制使用永久AccessKey的API请求来源IP地址,将AccessKey调用来源控制在可信的网络环境内,提升AccessKey的安全性。

RT-DETR改进策略【Neck】| ECCV-2024 RCM 矩形自校准模块 优化颈部网络

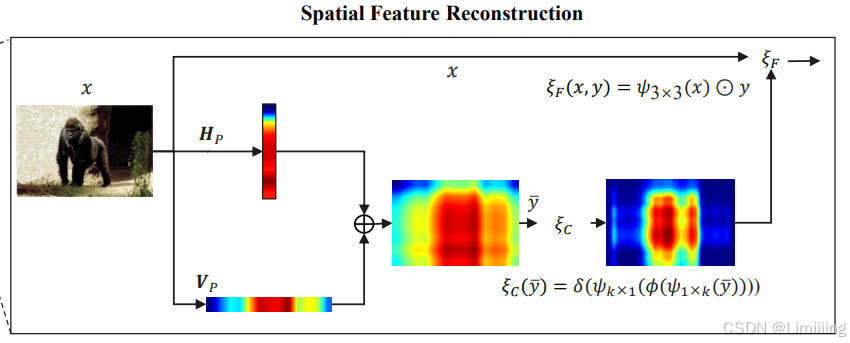

一、本文介绍 本文记录的是利用自校准模块RCM优化RT-DETR的目标检测方法研究。RCM通过矩形自校准函数可以将注意力区域校准得更接近前景对象,有效提高对前景对象的定位能力。==本文将其应用在颈部网络上,使模型能够捕获轴向全局上下文信息,并应用于金字塔上下文提取,使模型表现出更高的精度。== 专栏目录:RT-DETR改进目录一览 | 涉及卷积层、轻量化、注意力、损失函数、Backbone、S.....

RT-DETR改进策略【Neck】| GSConv+Slim Neck:混合深度可分离卷积和标准卷积的轻量化网络设计

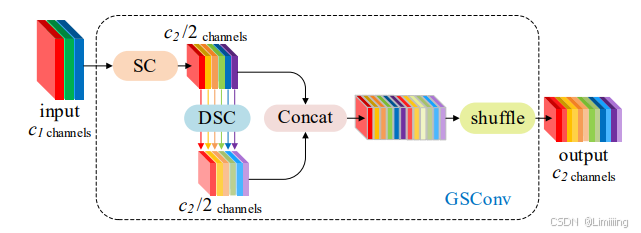

一、本文介绍 本文记录的是利用GsConv优化RT-DETR的颈部网络。深度可分离卷积(DSC)在轻量级模型中被广泛使用,但其在计算过程中会分离输入图像的通道信息,导致特征表示能力明显低于标准卷积(SC),而GsConv采用混合策略,使DSC的输出通过打乱特征更接近SC,从而优化模型的性能。本文利用GsConv+Slim Neck改进RT-DETR的颈部网络,==使其在提升特征表示能力的同时降低....

RT-DETR改进策略【Neck】| BiFPN:双向特征金字塔网络-跨尺度连接和加权特征融合

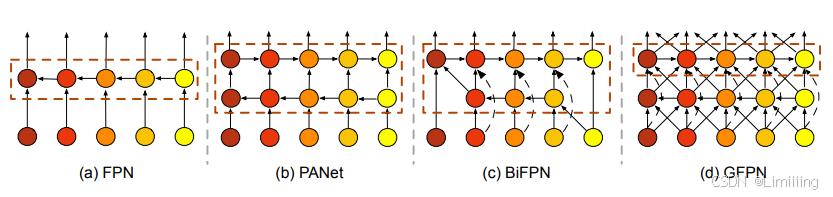

一、本文介绍 本文记录的是基于BiFPN结构的RT-DETR颈部网络改进方法研究。在RT-DETR的Neck颈部网络中使用的FPN+PAN的结构,但是FPN在融合不同输入特征时简单地将它们相加,没有区分不同特征的重要性;PAN虽然增加了额外的自底向上路径聚合网络,但参数和计算量较大。==为了解决这些问题,本文将颈部结构换成BiFPN,利用多尺度特征融合网络,使模型既能考虑不同输入特征的重要性,又....

RT-DETR改进策略【Neck】| ASF-YOLO 注意力尺度序列融合模块改进颈部网络,提高小目标检测精度

一、本文介绍 本文记录的是利用ASF-YOLO提出的颈部结构优化RT-DETR的目标检测网络模型。将RT-DETR的颈部网络改进成ASF-YOLO的结构,==使模型能够有效的融合多尺度特征,捕获小目标精细信息,并根据注意力机制关注小目标相关特征,显著提高模型精度。== 专栏目录:RT-DETR改进目录一览 | 涉及卷积层、轻量化、注意力、损失函数、Backbone、SPPF、Neck、检测头等.....

RT-DETR改进策略【Neck】| GFPN 超越BiFPN 通过跳层连接和跨尺度连接改进RT-DETR颈部网络

一、本文介绍 本文记录的是利用GFPN颈部结构优化RT-DETR的目标检测网络模型。利用GFPN改进后的颈部网络,通过跳层连接,==避免了在进行反向传播时的梯度消失问题==,并且引入跨尺度连接,==可以实现不同级别和层次的特征充分融合,获取足够的高层语义信息和低层空间信息交换,从而在大规模变化场景下提高检测性能。== 专栏目录:RT-DETR改进目录一览 | 涉及卷积层、轻量化、注意力、损失函.....

RT-DETR改进策略【模型轻量化】| 替换骨干网络为 GhostNet V3 2024华为的重参数轻量化模型

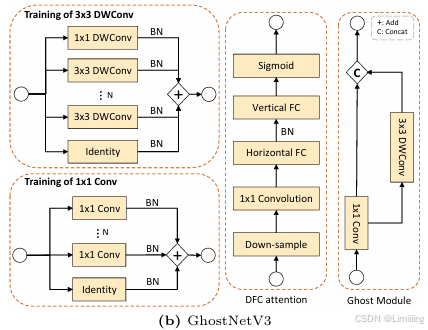

一、本文介绍 本文记录的是基于 GhostNetV3 的 RT-DETR轻量化改进方法研究。GhostNetV3的轻量模块采用重参数化方法,训练时为深度可分离卷积和1×1卷积添加线性并行分支,推理时通过逆重参数化移除分支、折叠操作,能够在不增加推理成本的同时提高性能,从而实现RT-DETR的轻量化改进。 专栏目录:RT-DETR改进目录一览 | 涉及卷积层、轻量化、注意力、损失函数、Backb.....

RT-DETR改进策略【模型轻量化】| 替换骨干网络为MoblieNetV2,含模型详解和完整配置步骤

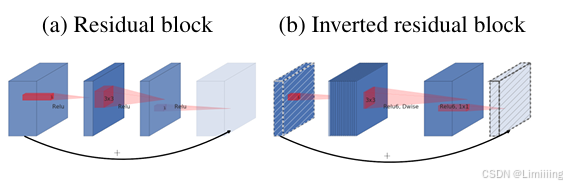

一、本文介绍 本文记录的是基于MobileNet v2的 RT-DETR轻量化改进方法研究。MobileNet v2采用深度可分离卷积将标准卷积分解为深度卷积和1×1卷积,大幅削减计算量。同时,引入线性瓶颈层来防止非线性在低维空间破坏信息,避免非线性层导致的性能下降问题。本文将MobileNet v2应用到RT-DETR中,借助其高效的结构和特性,在保持一定精度的前提下,显著降低 RT-DETR....

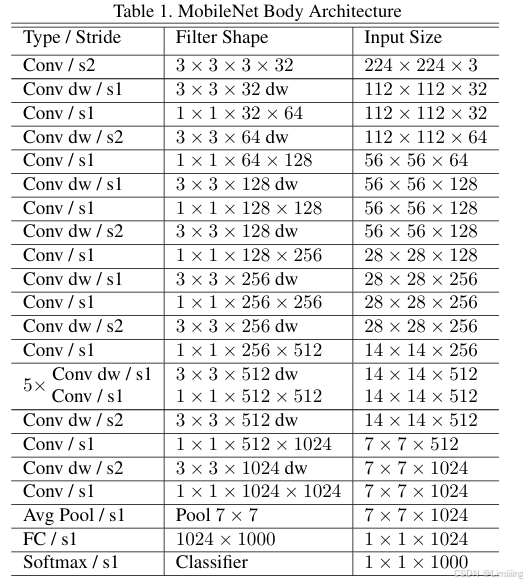

RT-DETR改进策略【模型轻量化】| 替换骨干网络为MoblieNetV1,用于移动视觉应用的高效卷积神经网络

一、本文介绍 本文记录的是基于MobileNet V1的RT-DETR轻量化改进方法研究。MobileNet V1基于深度可分离卷积构建,其设计旨在满足移动和嵌入式视觉应用对小型、低延迟模型的需求,具有独特的模型收缩超参数来灵活调整模型大小与性能。本文将MobileNet V1应用到RT-DETR中,有望借助其高效的结构和特性,提升RT-DETR在计算资源有限环境下的性能表现,同时保持一定的精度....

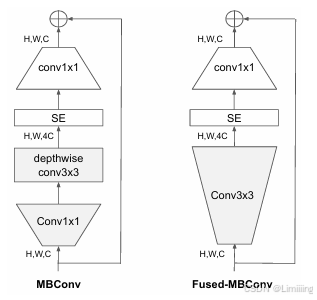

RT-DETR改进策略【模型轻量化】| 替换骨干网络为EfficientNet v2,加速训练,快速收敛

一、本文介绍 本文记录的是基于 EfficientNet v2 的 RT-DETR轻量化改进方法研究。EfficientNet v2针对EfficientNet v1存在的训练瓶颈,如大图像尺寸训练慢、早期深度卷积层速度慢以及等比例缩放各阶段非最优等情况进行改进,以实现训练速度快、参数效率高和泛化能力好的优势,将其应用到RT-DETR中有望提升模型整体性能,在保证精度的同时降低模型复杂度和训练时....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

网络策略相关内容

- rt-detr策略网络融合

- rt-detr策略bifpn网络

- rt-detr策略轻量网络

- rt-detr策略颈部网络

- 策略网络融合

- 策略融合网络

- 策略bifpn网络

- 策略neck网络

- 策略卷积网络

- 策略轻量网络

- rt-detr策略网络步骤

- rt-detr策略网络ghostnet

- rt-detr策略网络cvpr-2024

- 策略骨干网络efficientnet结构

- rt-detr策略骨干网络cvpr-2024

- 策略网络cvpr-2024

- 策略轻量网络结构

- 策略骨干网络cvpr-2024 starnet模块

- 策略conv卷积调制注意力机制网络

- rt-detr策略网络信息

- 策略构建网络

- 策略网络配置步骤

- rt-detr策略主干网络cvpr骨干

- rt-detr策略主干网络cvpr

- rt-detr策略网络骨干

- 策略网络cvpr骨干convnets

- 策略主干网络convnext步骤

- 策略主干网络cvpr lsknet

- 策略网络范式

- 策略cgblock网络信息分类

网络更多策略相关

域名解析DNS

关注DNS行业趋势、技术、标准、产品和最佳实践,连接国内外相关技术社群信息,追踪业内DNS产品动态,加强信息共享,欢迎大家关注、推荐和投稿。

+关注